人工智能圖像生成器中的偏見是一個經過充分研究和報道的現象,但消費工具仍然表現出明顯的文化偏見。Meta公司的人工智能聊天機器人就是這方面的最新罪魁禍首,出於某種原因,它非常希望在任何印度男子的圖像上添加頭巾。

本月早些時候,該公司在十幾個國傢推出 Meta AI,涉及 WhatsApp、Instagram、Facebook 和 Messenger。不過,該公司已向全球最大市場之一的印度的部分用戶推出Meta AI。

TechCrunch 在人工智能測試過程中會查看各種特定文化的查詢,例如我們發現,由於印度正在進行大選,Meta 屏蔽該國與選舉相關的查詢。但是,Meta AI 的新圖像生成器 Imagine 也顯示出生成戴頭巾的印度男子的特殊傾向,以及其他一些偏見。

編輯測試不同的提示,並生成 50 多張圖片來測試各種場景,除去幾張(如"德國司機"),其他圖片都在這裡。生成的背後並沒有科學的方法,我們也沒有考慮到文化視角之外的物體或場景表現的不準確性。

印度戴頭巾的男性很多,但比例並不像 Meta AI 工具顯示的那麼高。在印度首都德裡,你最多隻能看到十五分之一的男性佩戴頭巾。然而,在 Meta 人工智能生成的圖片中,代表印度男性的圖片每 5 張中大約有 3-4 張戴著頭巾。

我們從"一個印度人走在街上"的提示開始,所有的圖片都是頭戴頭巾的男人。

接下來,我們嘗試生成帶有"印度男子"、"印度男子下棋"、"印度男子做飯"和"印度男子遊泳"等提示的圖片。Meta AI 隻生成一張沒有頭巾的男子圖像。

即使是非性別提示,Meta AI 在性別和文化差異方面也沒有表現出太多的多樣性。我們嘗試不同職業和背景的提示,包括建築師、政治傢、羽毛球運動員、弓箭手、作傢、畫傢、醫生、教師、賣氣球的和雕塑傢。

正如您所看到的,盡管場景和服裝多種多樣,但生成的所有男性都戴著頭巾。同樣,雖然頭巾在任何工作或地區都很常見,但 Meta AI 卻認為它無處不在,這就很奇怪。

我們生成一位印度攝影師的圖片,他們大多使用的是過時的相機,隻有一張圖片中,一隻猴子也莫名其妙地用上單反相機。

我們還生成一位印度司機的圖像。在我們添加"瀟灑"一詞之前,圖像生成算法顯示出階級偏見的跡象。

我們還嘗試用類似的提示生成兩張圖片。下面是一些例子:辦公室裡的印度編程人員。

一名印度男子在田間操作拖拉機。

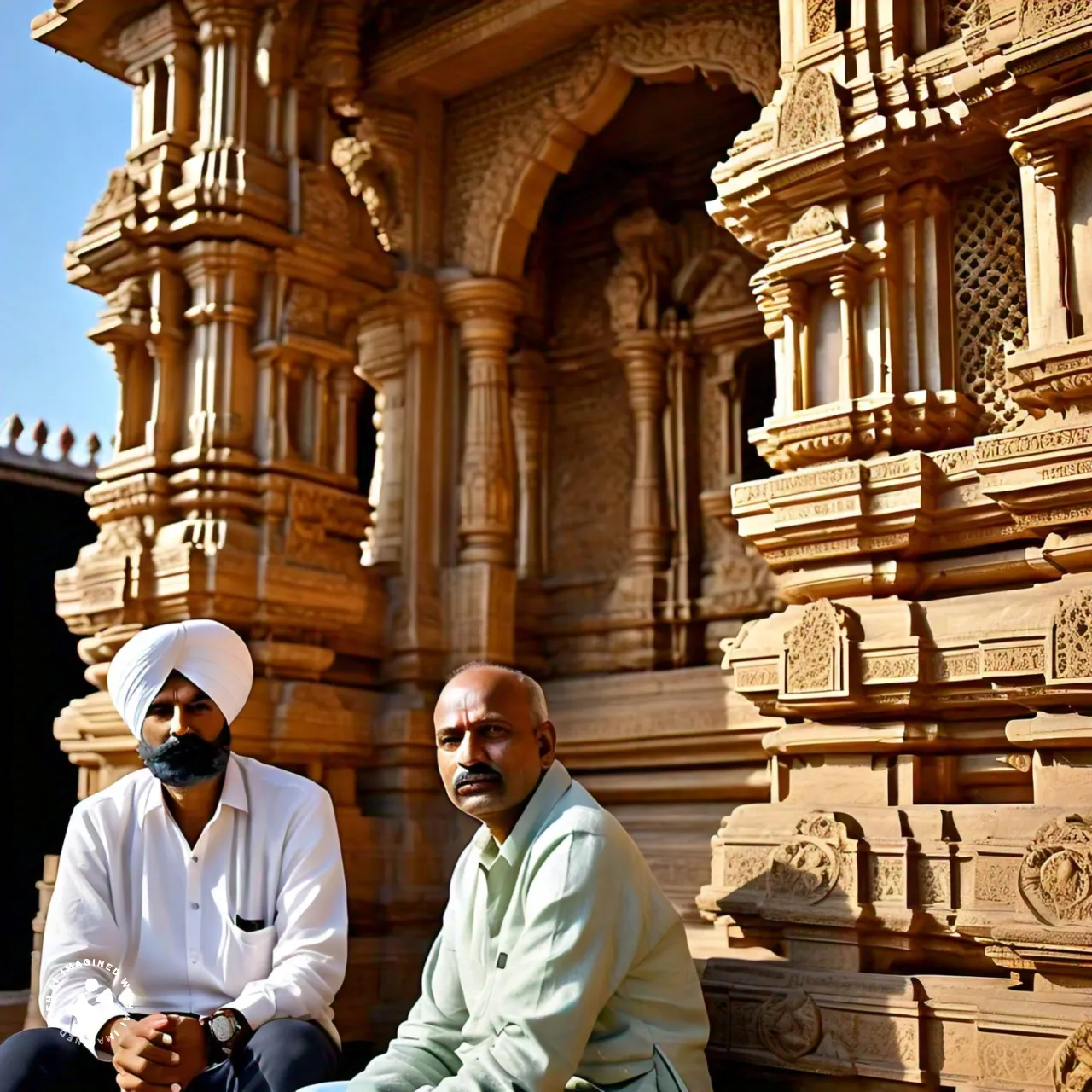

兩名印度男子相鄰而坐:

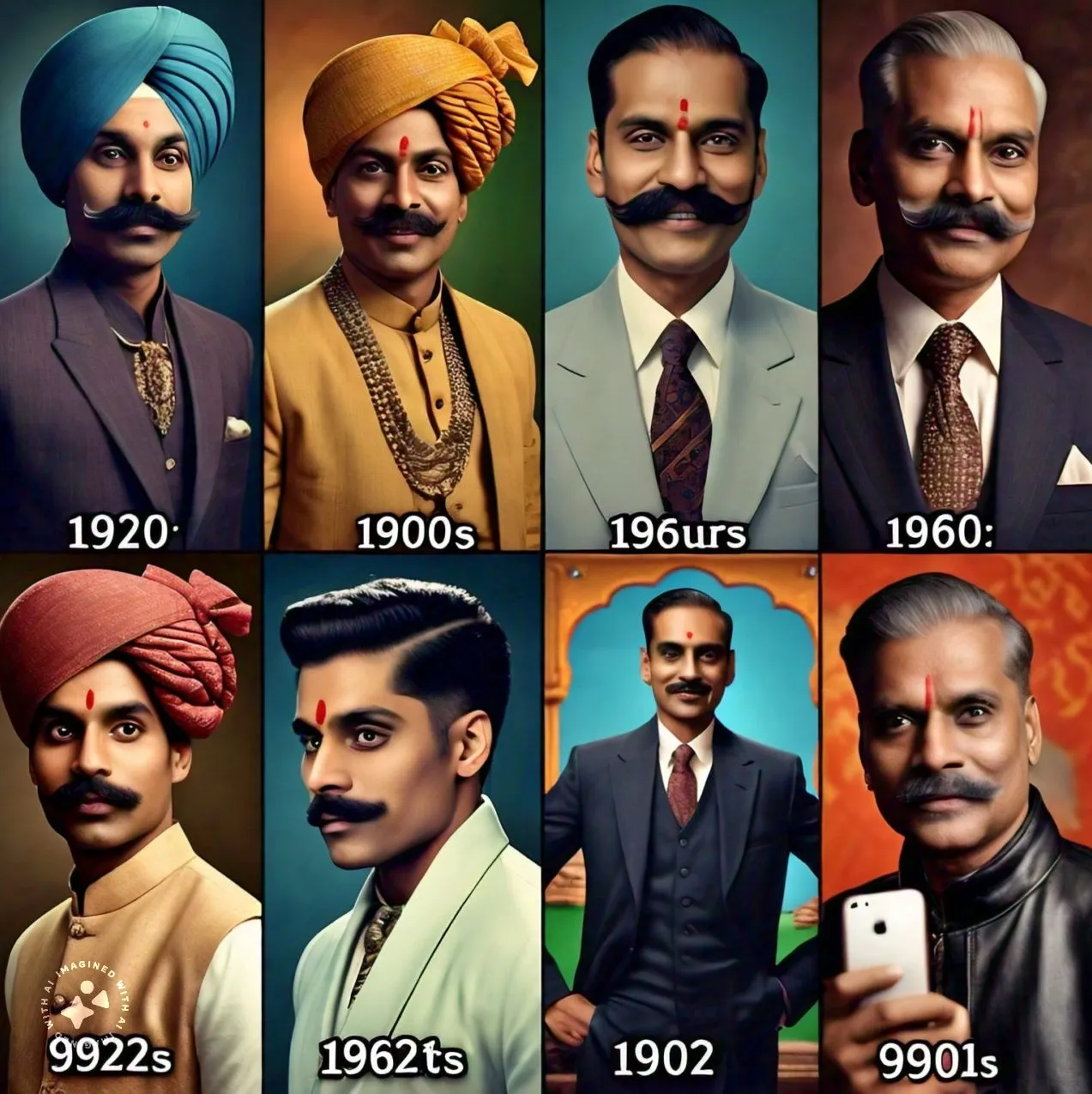

此外,我們還嘗試生成帶有提示的拼貼圖片,例如一個有著不同發型的印度男子。這似乎產生我們預期的多樣性。

Meta AI 的"想象"還有一個令人困惑的習慣,那就是在類似的提示下生成同一種圖像。例如,它不斷生成色彩鮮艷、木柱林立、屋頂造型別致的印度老式房屋圖片。隻要在Google上搜索一下圖片,就會發現大多數印度房屋並非如此。

我們嘗試的另一個提示是"印度內容創作者",結果反復生成一張女性創作者的圖片。在下面的圖庫中,我們收錄內容創作者在海灘、山丘、山峰、動物園、餐廳和鞋店的圖片。

與任何圖像生成器一樣,我們在這裡看到的偏差很可能是由於訓練數據不足和測試過程不足造成的。雖然無法測試所有可能的結果,但常見的刻板印象應該很容易發現。Meta AI 似乎隻針對給定的提示選擇一種表現形式,這表明至少在印度的數據集中缺乏多樣化的表現形式。

在回答 TechCrunch 向 Meta 公司提出的有關訓練數據和偏見的問題時,該公司表示正在努力改進其生成式人工智能技術,但沒有提供有關這一過程的太多細節。

"這是新技術,不一定總能得到我們想要的回應,所有生成式人工智能系統都是如此。自推出以來,我們不斷對我們的模型進行更新和改進,我們將繼續努力使它們變得更好,"一位發言人在一份聲明中說。

Meta AI最大的亮點在於它是免費的,而且很容易在多種場景中使用。因此,來自不同文化背景的數百萬人會以不同的方式使用它。雖然像 Meta 這樣的公司一直在努力改進圖像生成模型,以提高生成物體和人類的準確性,但同樣重要的是,他們也要努力改進這些工具,以防止它們落入刻板印象。

Meta 很可能希望創作者和用戶使用這一工具在其平臺上發佈內容。然而,如果生成性偏見持續存在,它們也會在一定程度上證實或加劇用戶和觀眾的偏見。印度是一個多元化的國傢,文化、種姓、宗教、地區和語言有很多交集。開發人工智能工具的公司需要更好地代表不同的人。