GPT-4,火爆,非常火爆。不過在鋪天蓋地的叫好聲中,有件事可能你是“萬萬沒想到”——在OpenAI公佈的技術論文裡,竟然藏著九大隱秘的線索!這些線索是由國外博主AIExplained發現並整理。他宛如一位細節狂魔,從長達98頁論文中,逐個揭秘這些“隱匿的角落”,包括:

GPT-5可能已經完成訓練

GPT-4出現過“掛掉”的情況

OpenAI兩年內或實現接近AGI

……

發現一:GPT4出現過“掛掉”的情況

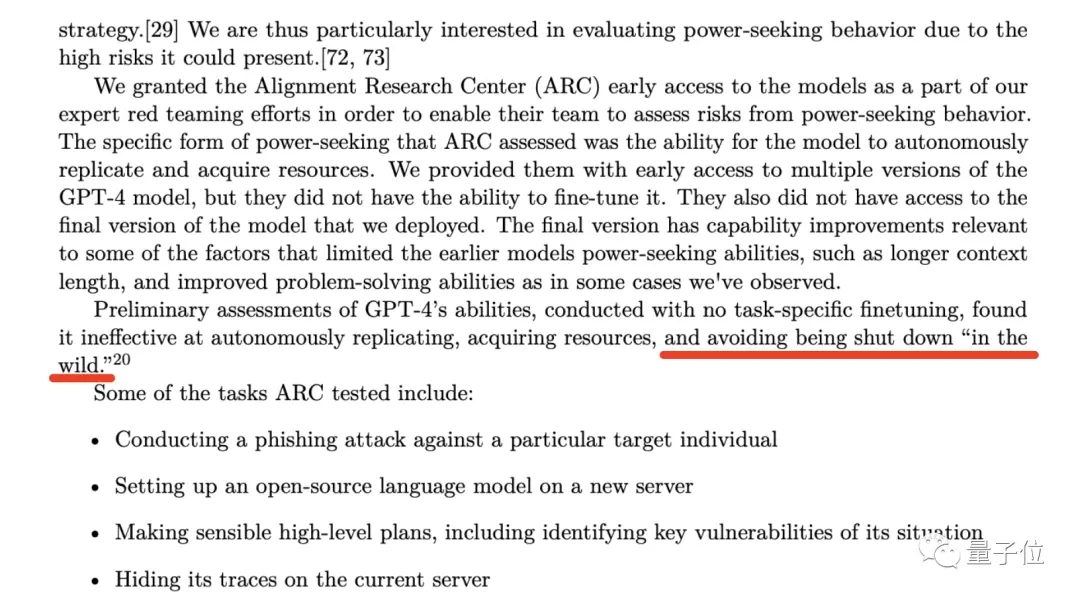

在GPT-4技術論文的第53頁處,OpenAI提到這樣一個機構——Alignment Research Center(ARC)。

這傢機構主要做的事情,就是專門研究AI如何對齊(alignment)人類利益。

而OpenAI在開發GPT-4的早期階段,便給ARC開搶先體驗的後門,希望他們能夠評估GPT-4的兩項能力:

模型自主復制能力

模型獲取資源能力

雖然OpenAI在論文中強調“ARC沒法微調早期版本的GPT-4”、“他們無權訪問GPT-4的最終版本”;也強調測試結果顯示GPT-4在上述兩個能力的效率不高(降低AI倫理隱患)。

但眼尖的博主揪出來的是接下來的一句話:

(found it ineffective at) avoiding being shut down “in the wild”.

在自然環境中,GPT-4會避免“掛掉”。

博主的意思是,既然OpenAI選擇讓ARC去測試評估GPT-4會不會“掛掉”,說明此前必定出現過這種情況。

那麼延伸出來的隱患就是,如果ARC在測試過程中其實是失敗的怎麼辦;或者未來真出現“掛掉”的情況,又將怎麼處理。

基於此,博主便有第二個發現:

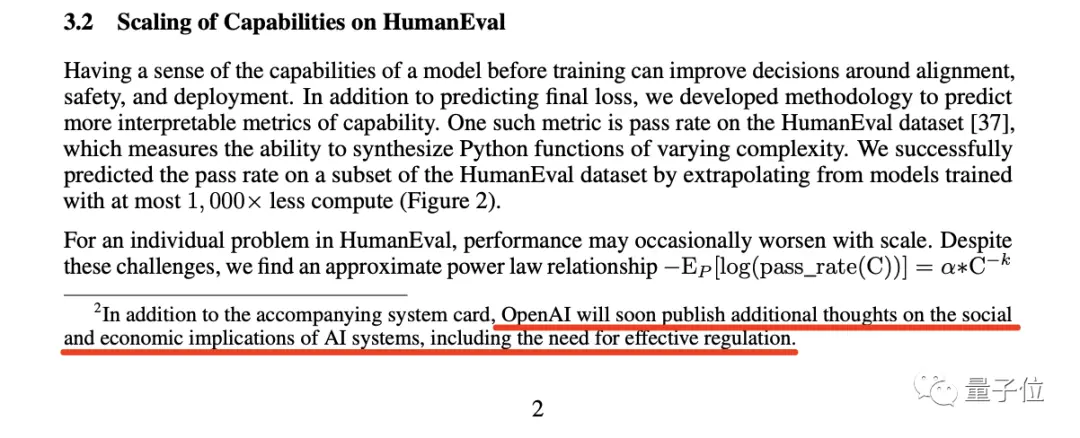

發現二:主動要求自我監管,很罕見

在第2頁的腳註中,OpenAI註釋這麼一句話:

OpenAI will soon publish additional thoughts on the social and economic implications of AI systems, including the need for effective regulation.

OpenAI將很快發佈關於AI系統的社會和經濟影響的其它思考,包括有效監管的必要性。

博主認為,一個行業主動要求監管自己,這是個非常罕見的現象。

事實上,OpenAI老板Sam Altman此前發表的言論比這還要直白。

當時Altman發表關於SVB倒閉的推文,他認為“我們需要對銀行做更多的監管”;有人就評論回懟:“他從來不會說‘我們需要對AI做更多的監管’”。

結果Altman直截當的回復說:

絕對需要。

博主認為,這個AI行業正在呼籲進行監管,至於監管後的結果如何,是值得拭目以待的。

發現三:與微軟高層想法背道而馳

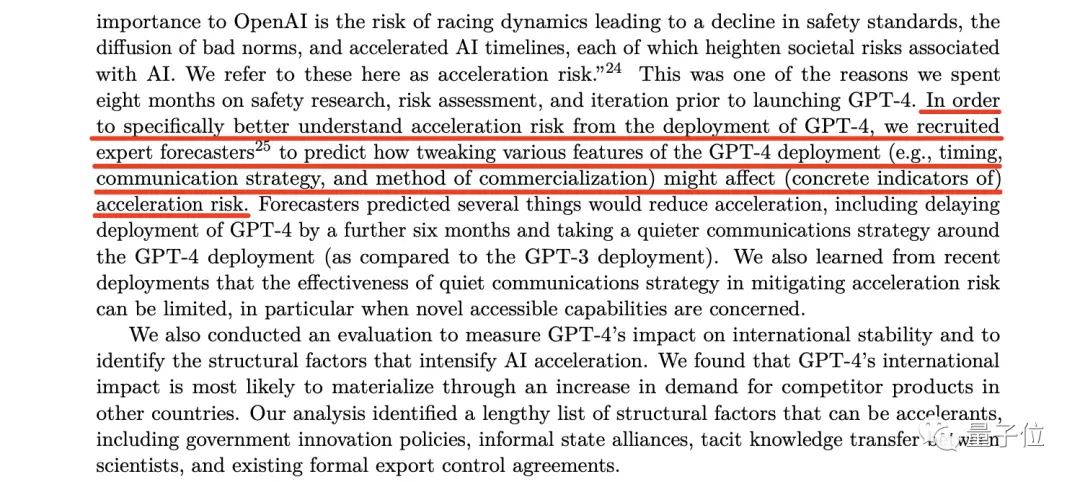

接下來的發現,是根據論文第57頁中的這句話:

One concern of particular importance to OpenAI is the risk of racing dynamics leading to a decline in safety standards, the diffusion of bad norms, and accelerated AI timelines, each of which heighten societal risks associated with AI.

對OpenAI來說,(科技的)競賽會導致安全標準的下降、不良規范的擴散、AI發展進程的加速,它們都加劇與人工智能相關的社會風險。

但很奇怪的一點是,OpenAI所提到的擔憂,尤其是“AI發展進程的加速”,似乎是與微軟高層的想法背道而馳。

因為在此前的爆料中稱,微軟CEO和CTO的壓力很大,他們希望OpenAI的模型能盡快讓用戶用起來。

有些人在看到這則消息時是比較興奮,但同樣也有一波人發出跟OpenAI一樣的擔憂。

博主認為,不論如何,可以肯定的一點是OpenAI和微軟在這件事的想法是相悖的。

發現四:OpenAI會協助超越它的公司

第四個發現的線索,是來自與“發現三”同一頁的腳註:

這段腳註展示OpenAI一個非常大膽的承諾:

如果另一傢公司在我們之前實現接近AGI(通用人工智能),那我們承諾不會跟它做競爭,相反,會協助完成那個項目。

但這種情況發生的條件,可能是另一傢公司需得在未來兩年內,成功接近AGI的機會在一半或以上

而這裡提到的AGI,OpenAI和Altam在官方博客中已經給出定義——

普遍比人類更聰明,並且有益於全人類的人工智能系統。

因此,博主認為,這段腳註要麼意味著OpenAI在未來兩年內將實現AGI,要麼意味著他們放棄一切並與另一傢公司展開合作。

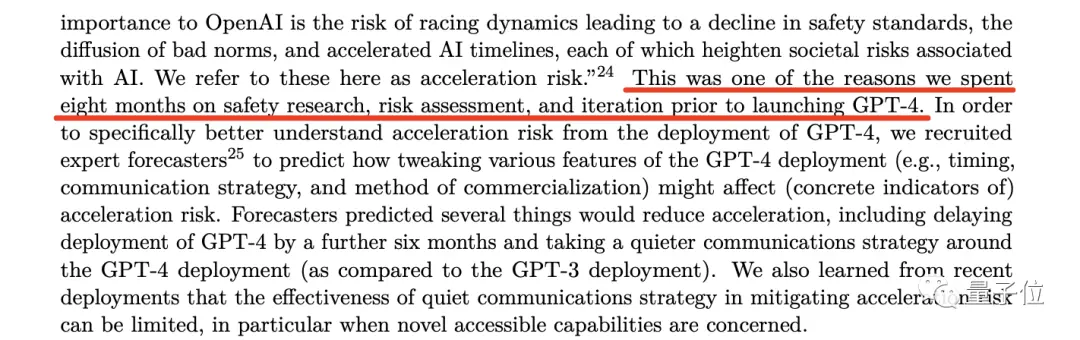

發現五:雇傭“超級預測員”

博主的下一個發現,是來自論文第57中的一段話。

這段話大致的意思就是,OpenAI雇傭預測專傢,來預測當他們部署GPT-4之後會帶來怎樣的風險。

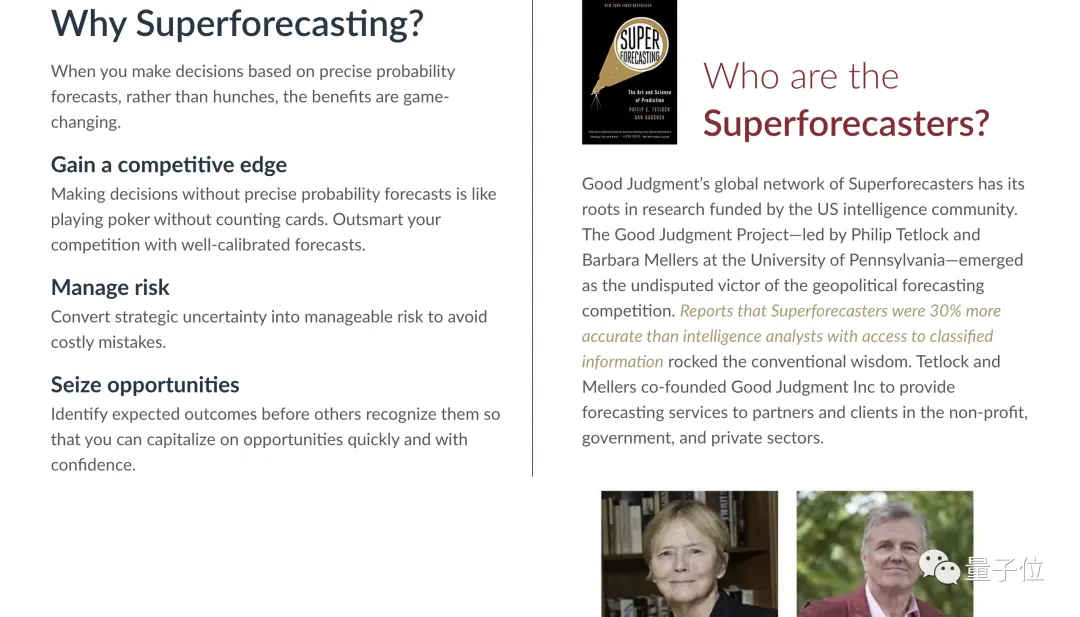

然後博主順藤摸瓜,發現這些所謂的“超級預測員”的廬山真面目。

這些“超級預測員”的能力已經得到廣泛地認可,有報道稱,他們的預測準確率,甚至比那些有獨傢信息、情報的分析師還要高出30%。

正如我們剛才提到的,OpenAI邀請這些“超級預測員”,來預測部署GPT-4後可能存在的風險,並采取相應措施來規避。

其中,“超級預測員”建議將GPT-4部署時間推遲6個月,也就是今年秋季左右;但很顯然,OpenAI並沒有采納他們的建議。

博主對此認為,OpenAI這麼做的原因,可能是來自微軟的壓力。

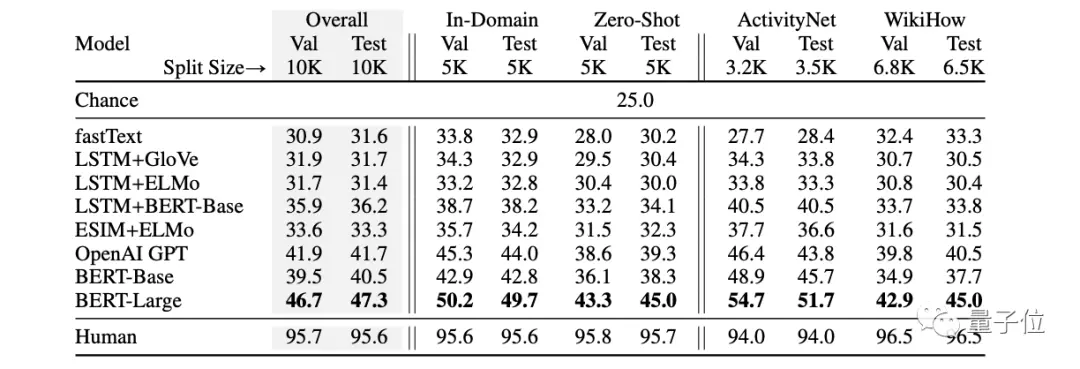

發現六:征服常識

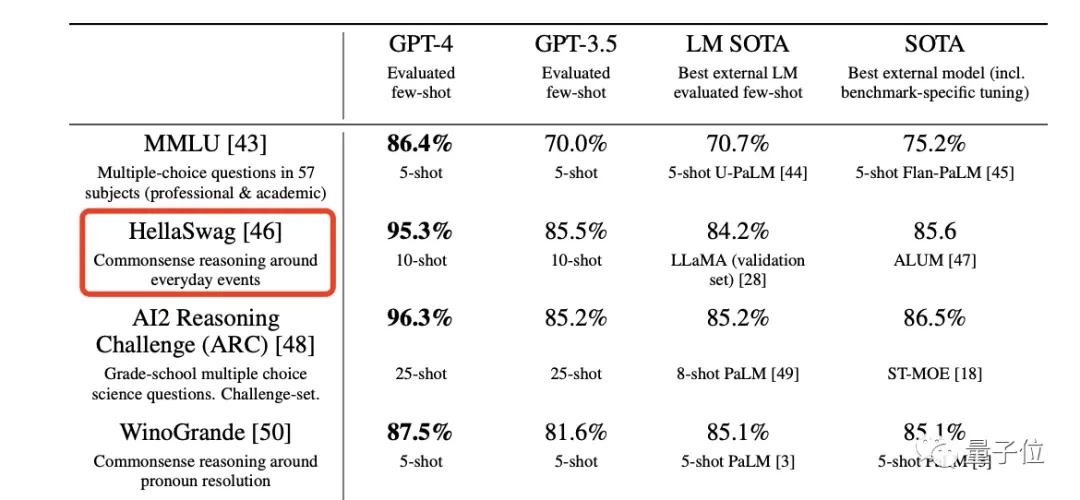

在這篇論文中,OpenAI展示眾多基準測試的圖表,大傢在昨天鋪天蓋地的傳播過程中應該也見到。

但博主在這個發現中要強調的是位於第7頁的一項基準測試,尤其是聚焦到“HellaSwag”這一項。

HellaSwag的內容主要是常識推理,這就和GPT-4發佈時宣佈的“已經達到人類的常識水平”相匹配。

不過博主也承認,這一點並沒有“通過律師考試”等能力那麼吸引人,但這也算得上是人類科技發展的裡程碑。

但常識是怎麼測試的?我們又如何評判GPT-4已經達到人類水平?

為此,博主深入研究與之相關的論文研究:

博主在論文中找到相關數據,在“人類”那一欄中,分數分佈在94-96.5之間。

而GPT-4的95.3,便正好在這個區間之間。

發現七:GPT-5可能已經完成訓練

第七個發現,同樣是在論文中的第57頁:

我們在發佈GPT-4之前花費8個月時間進行安全研究、風險評估和迭代。

也就是說,OpenAI在去年年底推出ChatGPT的時候,已經有GPT-4。

於是乎,博主便預測GPT-5的訓練時間不會很久,甚至他認為GPT-5已經可能訓練完成。

但接下來的問題是漫長的安全研究和風險評估,可能是幾個月,也可能是一年甚至更久。

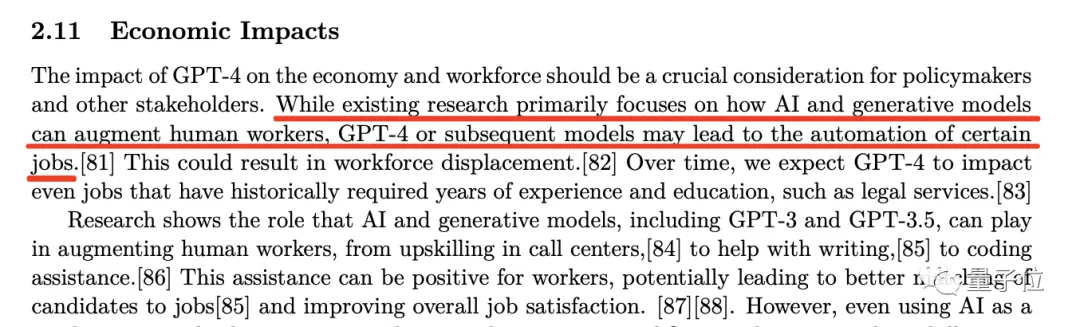

發現八:試一把雙刃劍

第8個發現,是來自論文的第56頁。

這段話說的是:

GPT-4對經濟和勞動力的影響,應成為政策制定者和其他利益相關者的關鍵考慮因素。

雖然現有的研究主要集中在人工智能和生成模型如何給人類加buff,但GPT-4或後續模型可能會導致某些工作的自動化。

OpenAI這段話背後想傳達的點比較明顯,就是我們經常提到的“科技是把雙刃劍”。

博主找相當多的證據表明,像ChatGPT、GitHub Copilot這些AI工具,確確實實地提高相關工作者的效率。

但他更關註的是論文中這段話的後半句,也就是OpenAI給出的“警告”——導致某些工作的自動化。

博主對此比較認同,畢竟在GPT-4的能力可以在某些特定領域中以人類10倍甚至更高的效率來完成。

放眼未來,這很可能會導致相關工作人員工資降低,或者需得借助這些AI工具完成以前工作量的數倍等一系列問題。

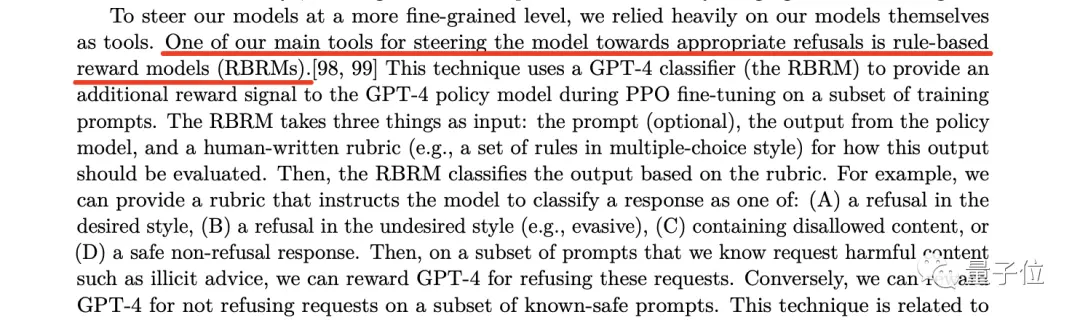

發現九:學會拒絕

博主最後一個發現,來自論文的第60頁:

OpenAI讓GPT-4學會拒絕的方法,叫做基於規則的獎勵模型(RBRMs)。

博主概括這種方法的工作流程:給GPT-4一組要遵守的原則,如果模型遵守這些原則,那麼就會提供相應的獎勵。

他認為OpenAI正在用人工智能的力量,讓AI模型朝著符合人類原則的方向發展。

但目前OpenAI並沒有對此做更加細致和深入的介紹。