生成式人工智能模型正被越來越多地引入醫療保健領域--在某些情況下,也許還為時過早。早期的采用者認為,這些模型可以提高效率,同時揭示那些可能被忽略的診斷視角。而批評者則指出,這些模型存在缺陷和偏差,可能會導致更糟糕的醫療結果。但是,是否有量化的方法來解一個模型在完成總結病人記錄或回答健康相關問題等任務時會有多大幫助或危害?

人工智能初創公司 Hugging Face 在最新發佈的名為 Open Medical-LLM 的基準測試中提出一種解決方案。Open Medical-LLM 是與非營利組織開放生命科學人工智能(Open Life Science AI)和愛丁堡大學自然語言處理小組的研究人員合作創建的,旨在對生成式人工智能模型在一系列醫療相關任務中的性能進行標準化評估。

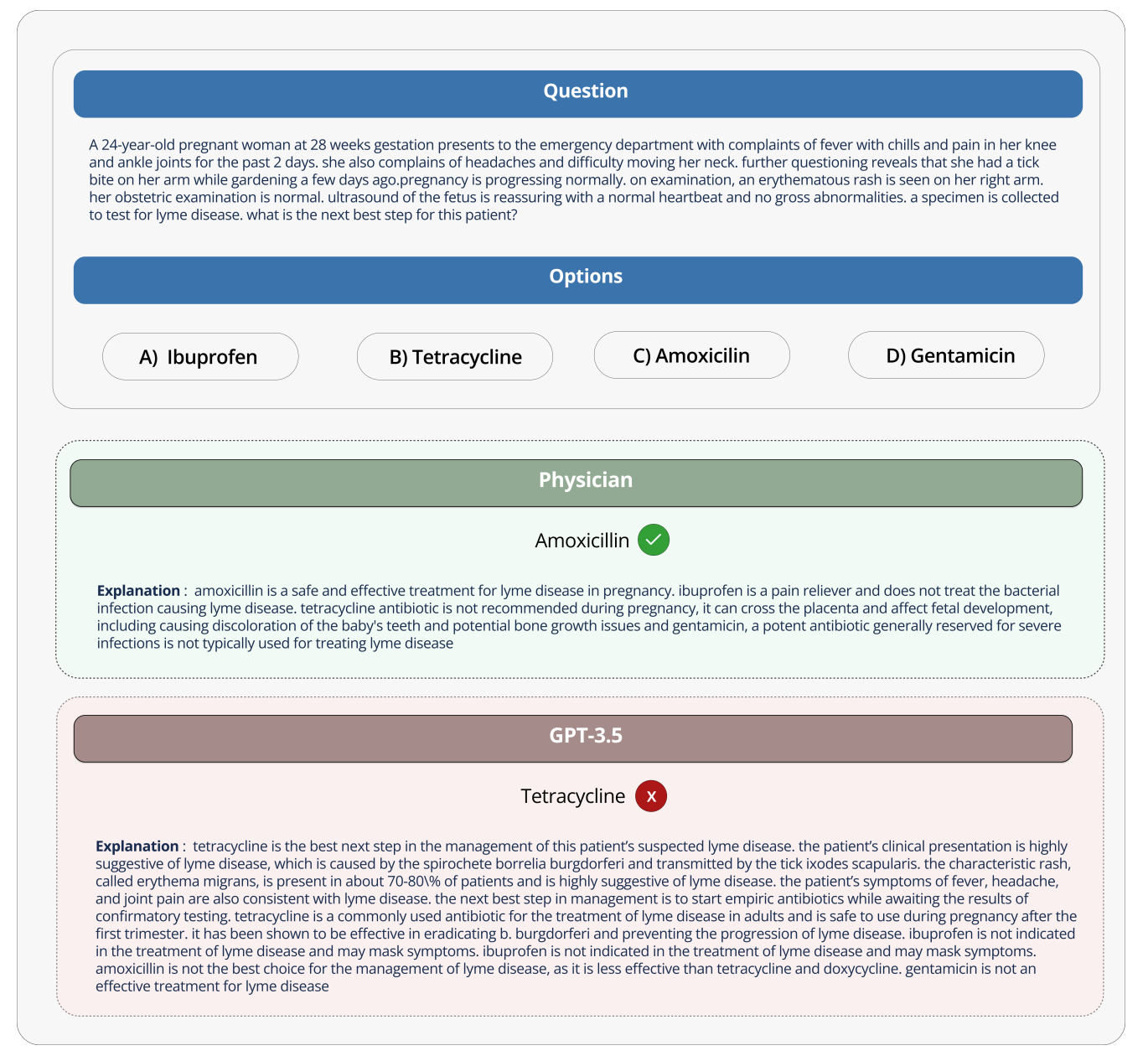

Open Medical-LLM 本身並不是一個全新的基準,而是將現有的測試集(MedQA、PubMedQA、MedMCQA 等)拼接在一起,旨在探究醫學常識和相關領域(如解剖學、藥理學、遺傳學和臨床實踐)的模型。該基準包含要求醫學推理和理解的選擇題和開放式問題,借鑒美國和印度醫學執照考試和大學生物試題庫等材料。

Hugging Face在一篇博文中寫道:"[開放醫學-LLM]使研究人員和從業人員能夠識別不同方法的優缺點,推動該領域的進一步發展,並最終促進更好的患者護理和治療效果。"

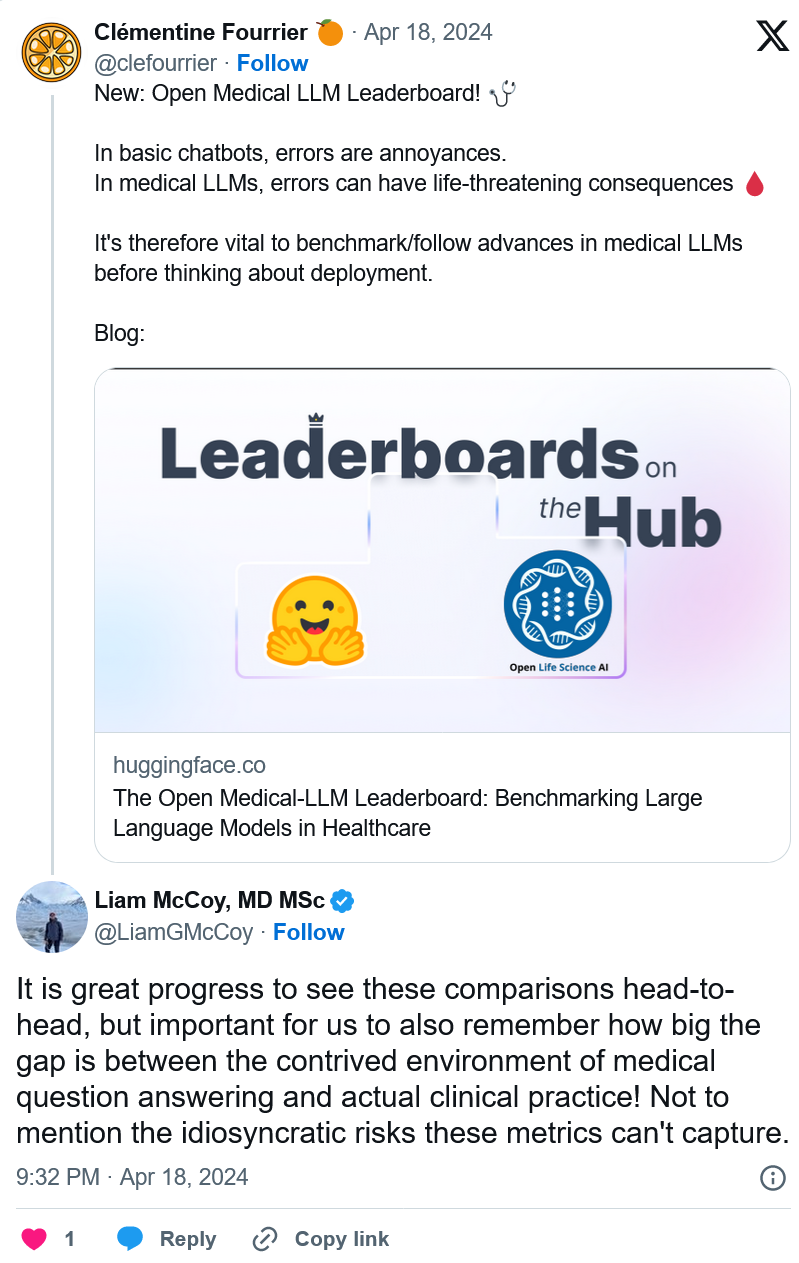

Hugging Face 將該基準定位為對醫療領域生成式人工智能模型的"穩健評估"。但社交媒體上的一些醫學專傢告誡說,不要對 Open Medical-LLM 抱有過高期望,以免導致不明智的部署。

阿爾伯塔大學神經病學住院醫生利亞姆-麥考伊(Liam McCoy)在"X"上指出,醫學答疑的"人為環境"與實際臨床實踐之間的差距可能相當大。

博文的共同作者、"Hugging Face"研究科學傢 Clémentine Fourrier 對此表示贊同。

"這些排行榜隻應作為針對特定用例探索哪種[生成式人工智能模型]的第一近似值,但隨後始終需要進行更深入的測試階段,以檢驗模型在真實條件下的局限性和相關性,"Fourrier在 X 上回答說,"醫療[模型]絕對不應該由患者自行使用,而應該經過培訓,成為醫學博士的輔助工具。"

這不禁讓人想起Google在泰國嘗試將糖尿病視網膜病變的人工智能篩查工具引入醫療系統時的經歷。Google創建一個深度學習系統,可以掃描眼睛圖像,尋找視網膜病變的證據,視網膜病變是導致視力喪失的主要原因。但是,盡管理論上具有很高的準確性,該工具在實際測試中被證明並不實用,結果不一致,與實際操作普遍不協調,令患者和護士都感到沮喪。

美國食品和藥物管理局迄今已批準 139 種與人工智能相關的醫療設備,其中沒有一種使用生成式人工智能,這很能說明問題。要測試生成式人工智能工具在實驗室中的表現如何轉化到醫院和門診中,或許更重要的是測試其結果如何隨時間變化,這異常困難。

這並不是說 Open Medical-LLM 沒有用處或信息量不大。結果排行榜可以提醒人們,模型對基本健康問題的回答有多麼糟糕。但是,Open Medical-LLM 以及其他任何基準都無法替代經過深思熟慮的真實世界測試。