英國安全研究所(U.K.SafetyInstitute)是英國最近成立的人工智能安全機構,該機構發佈一個工具集,旨在"加強人工智能安全",使工業界、研究機構和學術界更容易開展人工智能評估。該工具集名為Inspect,采用開源許可(特別是MIT許可),旨在評估人工智能模型的某些能力,包括模型的核心知識和推理能力,並根據結果生成評分。

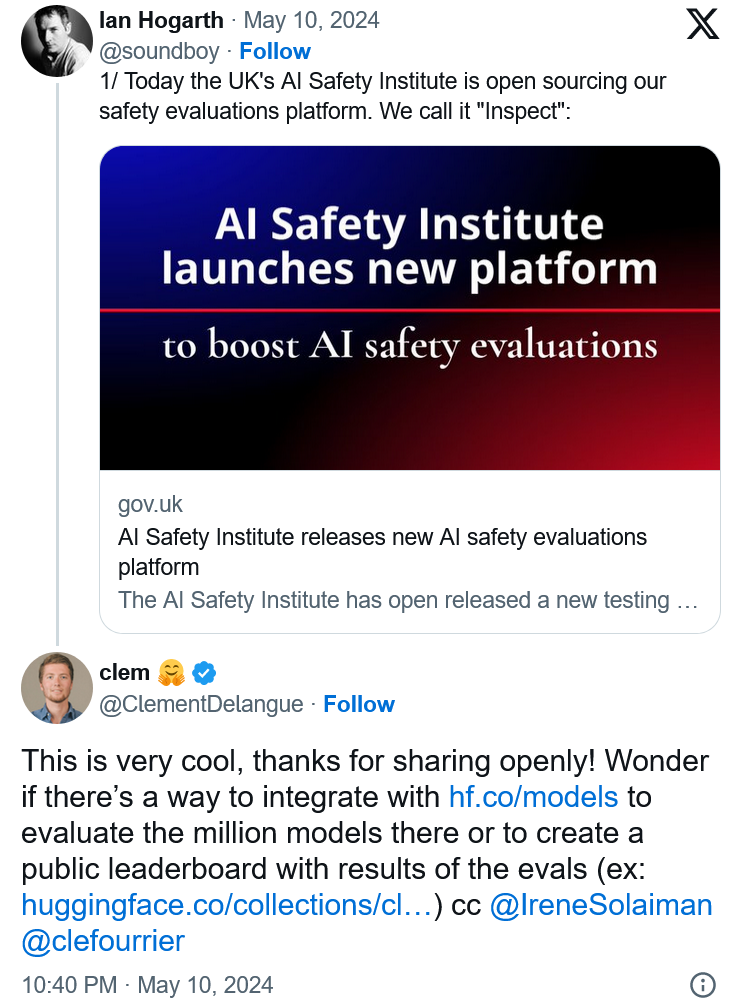

在周五宣佈這一消息的新聞稿中,安全研究所聲稱,Inspect 標志著"由國傢支持的機構主導的人工智能安全測試平臺首次被廣泛使用"。

安全研究所主席伊恩-霍加斯(Ian Hogarth)在一份聲明中說:"人工智能安全測試方面的成功合作意味著要有一個共享的、可訪問的評估方法,我們希望Inspect能夠成為一個基石。我們希望看到全球人工智能社區利用Inspect不僅開展自己的模型安全性測試,而且幫助調整和構建開源平臺,以便我們能夠全面開展高質量的評估。"

眾所周知,人工智能基準很難制定--其中最重要的原因是,當今最復雜的人工智能模型幾乎都是黑盒,其基礎設施、訓練數據和其他關鍵細節都被創建這些模型的公司保密。那麼,Inspect 如何應對這一挑戰呢?主要是通過可擴展的新測試技術。

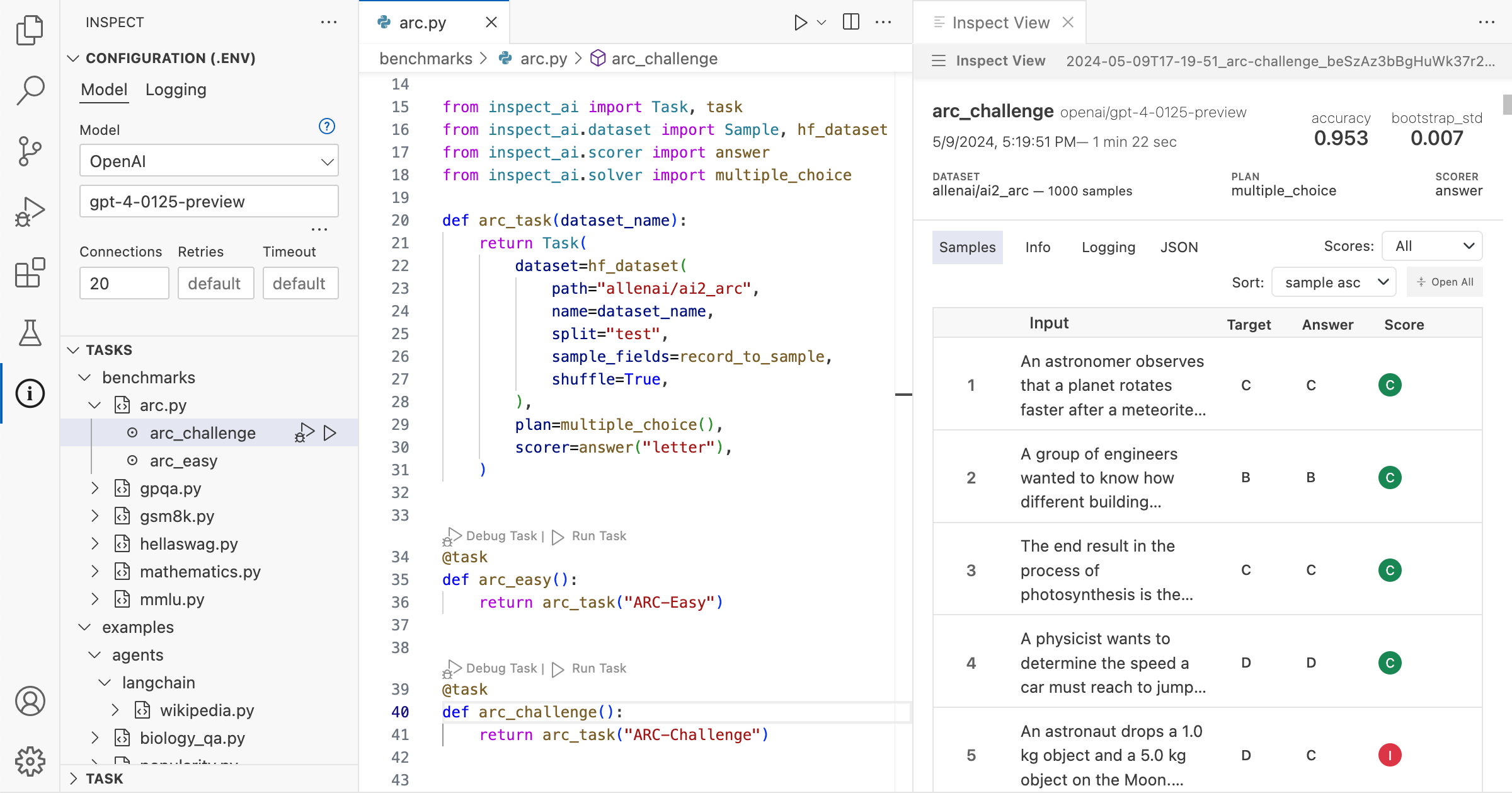

Inspect 由三個基本部分組成:數據集、求解器和評分器。數據集為評估測試提供樣本。求解器負責執行測試。評分器負責評估求解器的工作,並將測試得分匯總為指標。可以通過用 Python 編寫的第三方軟件包來增強 Inspect 的內置組件。

Mozilla 研究員、著名人工智能倫理學傢德博拉-拉吉(Deborah Raj)在 X 上發表一篇文章,稱 Inspect "證明對人工智能問責開源工具的公共投資的力量"。

人工智能初創公司Hugging Face的首席執行官克萊門特-德朗格(Clément Delangue)提出將Inspect與Hugging Face的模型庫整合在一起,或利用工具集的評估結果創建一個公共排行榜的想法。

Inspect 發佈之前,美國政府機構--國傢標準與技術研究院(NIST)啟動NIST GenAI,該計劃旨在評估各種生成式人工智能技術,包括文本和圖像生成人工智能。NIST GenAI 計劃發佈基準,幫助創建內容真實性檢測系統,並鼓勵開發能識別虛假或誤導性人工智能生成信息的軟件。

今年 4 月,美國和英國宣佈建立合作夥伴關系,共同開發先進的人工智能模型測試,這是繼去年 11 月英國在佈萊切利公園舉行的人工智能安全峰會上宣佈承諾之後的又一合作。作為合作的一部分,美國打算成立自己的人工智能安全研究所,廣泛負責評估人工智能和生成式人工智能的風險。