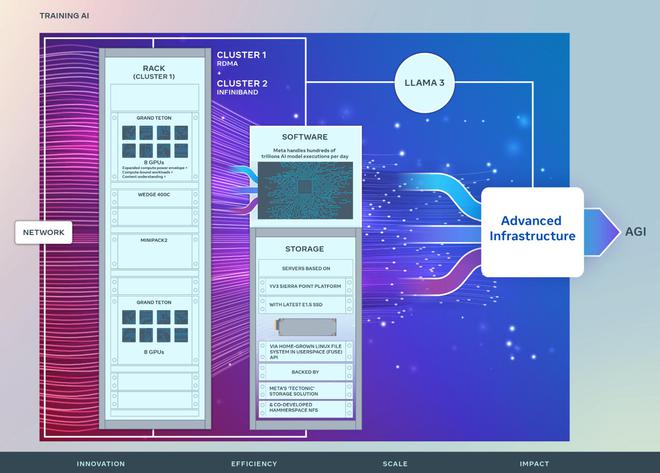

3月13日消息,美國時間周二,Facebook母公司Meta公佈兩個數據中心規模新集群的技術細節,它們各自擁有超過2.4萬個GPU,並在硬件、網絡、存儲、設計、性能和軟件等方面上,專為支持大型語言模型如Llama3進行訓練而深度優化。這兩個新集群基於Meta先前研究超級集群(RSC)的成功。RSC自2022年啟用以來,已展現出強大的計算力。

在硬件配置方面,每個集群都配備24576個英偉達Tensor Core H100 GPU(每個數萬美元),與之前使用的16000個英偉達A100 GPU相比有明顯提升,這將極大地促進自然語言處理、語音識別和圖像生成等人工智能研究和開發工作。

Meta表示,這種升級不僅在數量上有所增加,其性能上的躍進也將支持更大、更復雜的模型,為生成式人工智能產品的開發鋪平道路。

Meta計劃在2024年底之前,將其人工智能基礎設施擴大到高達35萬個H100 GPU。目標是擁有相當於近60萬個H100 GPU的算力。

雖然兩個新集群的GPU數量相同,但它們在網絡基礎設施方面各有差異,均支持400 Gbps端點之間的互聯。其中一個集群采用基於Arista 7800交換機配合Wedge400和Minipack2 OCP機架交換機的遠程直接內存訪問(RDMA)和融合以太網(RoCE)網絡解決方案,而另一個則應用英偉達Quantum2 InfiniBand網絡架構。

值得一提的是,兩個集群均基於Meta自研的開放GPU硬件平臺Grand Teton構建,這是公司為支撐大型AI工作負載而開發的GPU基礎硬件平臺。作為Zion-EX平臺的後續產品,Grand Teton在主機到GPU的帶寬、計算及數據網絡帶寬、以及功率包絡等方面都實現顯著的增強。

此外,這些集群充分利用Meta專為Grand Teton等方案設計的Open Rack電源和機架架構,提高數據中心的靈活性。

Meta的Open Rack v3硬件設計引入一個靈活的機架配置方案。與傳統的固定母線設計相比,它允許在機架中的任意位置安裝電源架,從而使機架配置更加靈活。

在建設這些新集群時,Meta特別關註每臺服務器吞吐量、機架數量減少及能源效率之間的平衡。通過對機架內服務器數量的定制化設計,Meta確保這些集群在提供高性能的同時,也達到能源的高效利用。

在存儲技術上,這些集群運用Linux Filesystem中的Userspace API,並得到Meta自傢Tectonic分佈式存儲方案的加持。與此同時,Meta還與Hammerspace合作,一道開發並行網絡文件系統(NFS)。

兩個集群均基於配備最新高容量E1.S SSD的YV3 Sierra Point服務器平臺。為優化網絡利用率,Meta進行網絡拓撲和路由的調整,並部署英偉達的集體通信庫(NCCL)。NCCL是一套針對英偉達GPU和網絡進行優化的標準通信例程庫。

Meta還在積極推進其PyTorch基礎AI框架的發展,以應對數十萬GPU的訓練需求。Meta的技術項目經理凱文·李(Kevin Lee)、生產網絡工程師阿迪·甘吉迪(Adi Gangidi)以及生產工程總監馬修·奧爾德姆(Mathew Oldham)在最新博客中共同表達公司的技術願景和戰略。他們強調,Meta將致力於人工智能軟件和硬件的開放式創新,啟動人工智能聯盟,建立一個開放的生態系統,“為人工智能開發帶來透明度、審查和信任,並帶來每個人都能從中受益的創新,這些創新以安全和責任為首要考慮因素”。

這篇博文繼續強調:“面對未來,我們意識到昨天和今天有效的方法可能無法滿足明天的需求。因此,Meta將不斷評估和改進其基礎設施的各個方面,從物理和虛擬層到軟件層等。我們的目標是創建一個既靈活又可靠的系統,以支撐快速發展中的新模型和研究工作。”