作為世上最大加速器芯片CS-2WaferScaleEngine背後的公司,Cerebras剛又宣佈瞭另一個裡程碑——在單個設備上完成瞭目前最大的自然語言處理(NLP)人工智能模型的訓練。此前也有人嘗試在智能手表這樣的可穿戴設備設備上訓練AI模型,但Cerebras這次又將參數提升到瞭20億的量級。

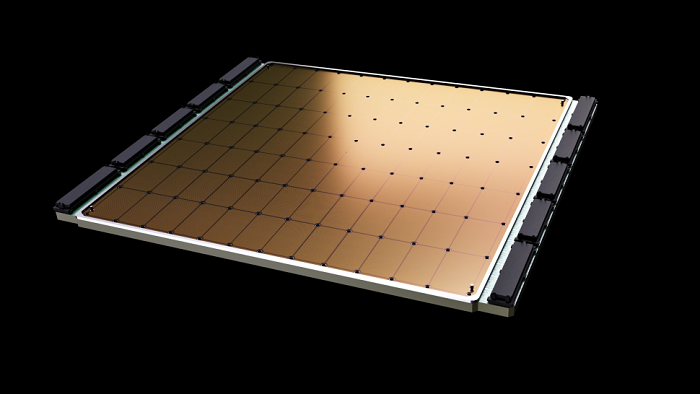

Wafer Scale Engine-2 晶圓級芯片資料圖(來自:Cerebras)

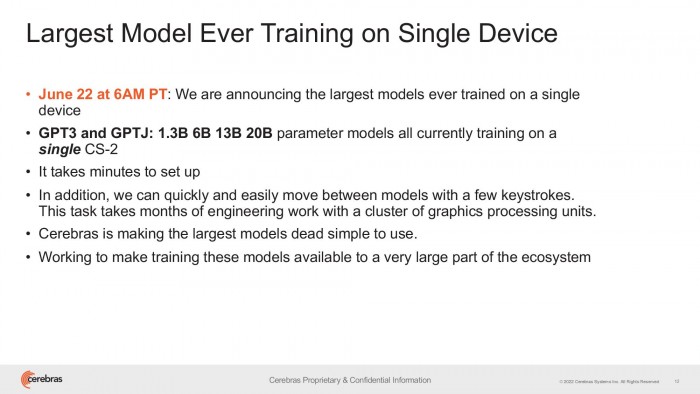

本次演示使用瞭 OpenAI 的 120 億參數 DALL-E,且所有工作負載無需擴展到橫跨多個加速器的平臺上去完成,從而極大地降低瞭對基礎設施和軟件的復雜性要求。

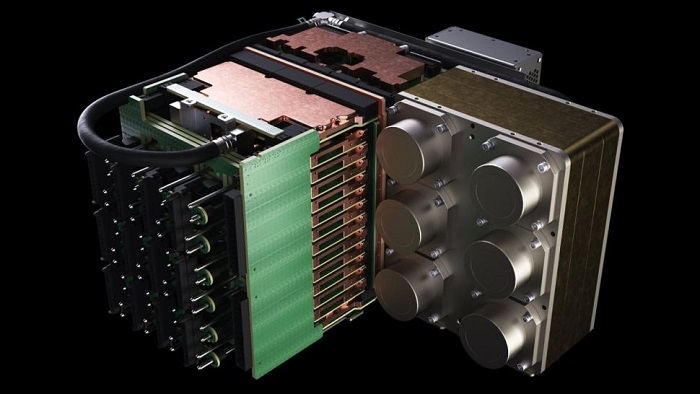

不過需要指出的是,單個 CS-2 系統本身就已經可以媲美超算 —— 7nm 單晶圓(通常可容納數百枚主流芯片),擁有驚人的 2.6 萬億個晶體管、85 萬個內核、40GB 集成緩存,且封裝功耗高達 15kW 。

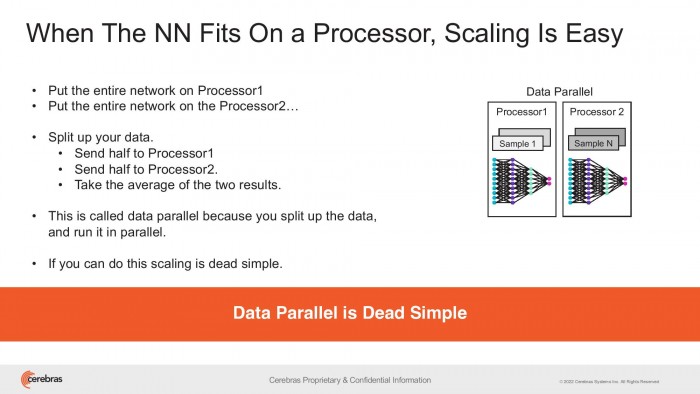

Cerebras 嘗試在單個芯片上保留多達 200 億個參數的 NLP 模型,以顯著降低數以千計的 GPU 訓練成本、擴展所需的相關硬件需求,並且消除瞭在它們之間劃分模型的技術難度。

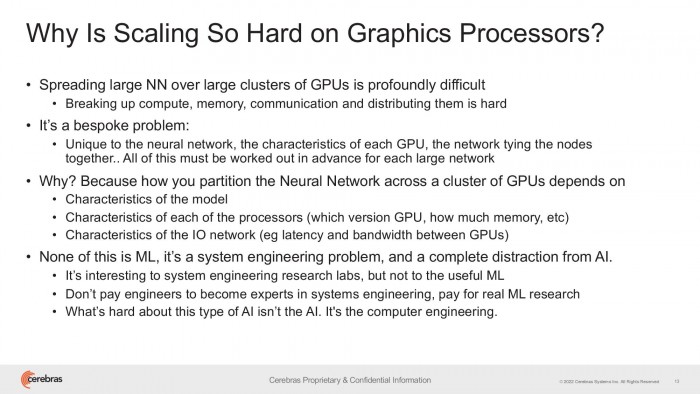

Cerebras 指出,這也是常規 NLP 工作負載的痛點之一,有時動輒需要耗費數月時間才能完成。

由於高度定制,每個正在處理的神經網絡、GPU 規格、以及將它們聯系到一起的網絡,都是獨一無二的 —— 這些元素必須在初次訓練前就搞定,且無法做到跨系統移植。

至於 OpenAI 的 GPT-3 自然預覽處理模型,它有時已經能夠編寫出讓你誤以為是真人所撰寫的整篇文章,且具有 1750 億個驚人的參數。

不過 DeepMind 在 2021 年底推出的 Gopher,已將這個數字大幅提升到瞭 2800 億,且 Google Brain 甚至宣佈訓練瞭一個超萬億參數的 Switch Transformer 模型。

Cerebras 首席執行官兼聯合創始人 Andrew Feldman 表示:更大的 NLP 模型,意味著它的準確度也更高。

但通常隻有極少數公司擁有如此龐大的必要資源和專業知識,來分解這些大型模型、並將之分散到數百、或數千個 GPU 上去艱苦運算。

正因如此,我們隻看到過極少數公司能夠訓練大型 NLP 模型 —— 這對行業內的其他人來說過於昂貴、耗時、且難以使用。

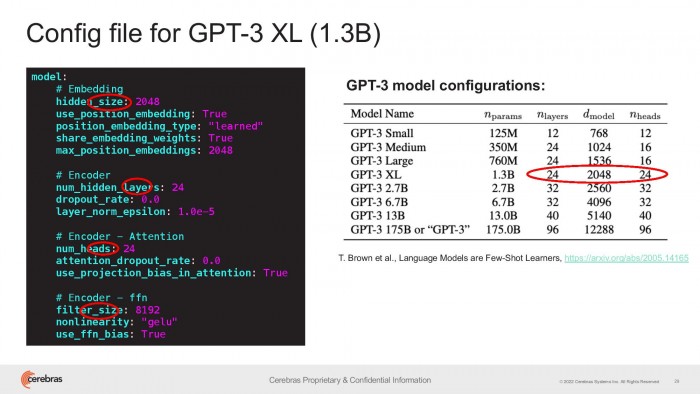

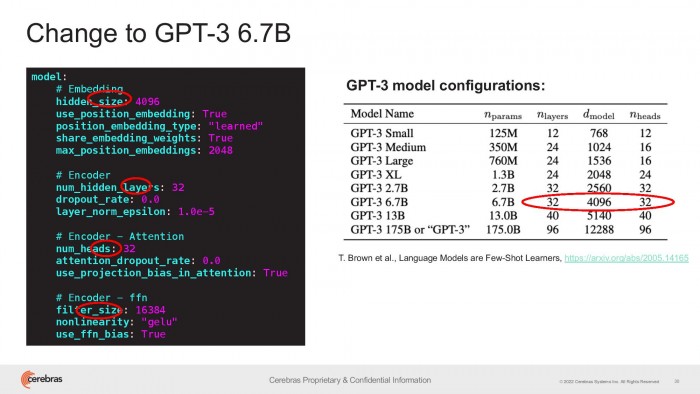

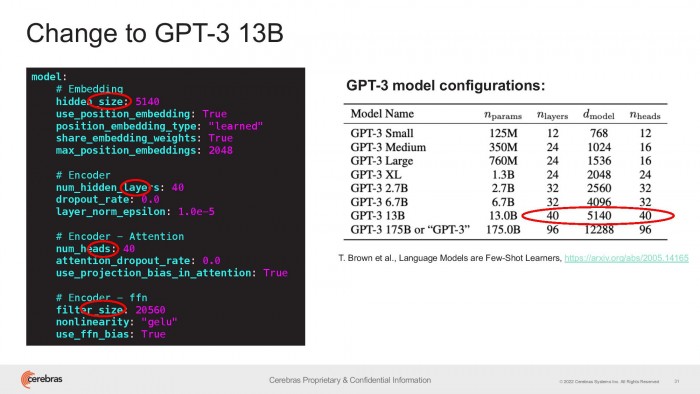

今天,Cerebras 很自豪地宣佈普及瞭 GPT-3XL 1.3B、GPT-J 6B、GPT-3 13B 和 GPT-NeoX 20B,讓整個 AI 生態系統都能夠在幾分鐘內建立大型模型、並在單個 CS-2 平臺上展開訓練。

不過與 CPU 領域類似,主頻隻是衡量性能的其中一項指標。比如 Chinchilla 就嘗試通過使用更少的參數(700 億個),得出瞭較 GPT-3 和 Gopher 更好的結果。