上周,瑞士軟件工程師MatthiasBühlmann發現——流行的圖像合成模型“StableDiffusion”,可實現較現有的JPEG或WebP格式更高的位圖圖像壓縮比、且視覺偽影也更少。即便如此,StableDiffusion也不是那麼完美。作為一種AI圖像合成模型,其通常根據文本描述(所謂的“提示”)而生成圖像。

用鋸齒彩塊來描繪的圖像壓縮概念(via ArsTechnica)

AI 模型通過研究從互聯網上提取的數百萬張圖像來學習這種能力,在訓練過程中,模型在圖像和相關詞之間建立統計關聯。

然後對每張圖像的關鍵信息添加更小的“表示”和賦予“權重”,後者代表 AI 圖像模型所掌握的數學值。

當穩定擴散分析、並將圖像“壓縮”為權重形式時,它們就處在所謂的“潛在空間”中 —— 它們以一種模糊潛力的形式存在,且能夠在解碼時於圖像中復現。

這項研究中用到的 Stable Diffusion 1.4,其權重文件大小約為 4GB —— 代表該 AI 模型掌握的數億張圖像的知識。

使用穩定擴散壓縮圖像的示例

盡管大多數人使用帶文本提示的穩定擴散,但 Bühlmann 還是斬斷文本編碼器、而是強制通過穩定擴散圖像編碼器來處理。

該過程將低精度的 512×512 圖像、轉換為更高精度的 64×64 潛在圖像空間表示。此時圖像存在的數據量較原始文件小得多,但仍可將之解碼擴展回 512×512 圖像、並獲得相當良好的結果。

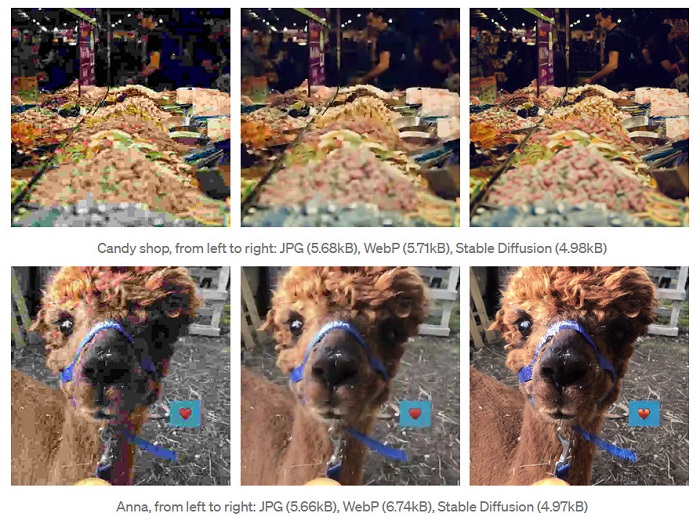

測試期間,Bühlmann 發現使用穩定擴散壓縮的新圖像,可在更高的壓縮比(更小的文件大小)下,主觀上看起來較 JPEG 或 WebP 更佳。

以這張美洲鴕的照片為例,其原始文件大小為 768 KB 。盡管 JPEG / WebP 格式分別可壓縮到 5.68 和 5.71 KB,但穩定擴散方法可進一步壓縮到 4.98 KB 。

與對照的圖像壓縮格式相比,穩定擴散似乎具有更多可分辨的細節、以及明顯更少的壓縮偽影。

不過 Bühlmann 也指出現階段的一個很大局限性 —— 它不太適合面容或文本,且在某些情況下會讓解碼圖像中的細節特征產生“幻象”。

這些特征可能在源圖像中並不存在,更別提解碼需要動用高達 4GB 的穩定擴散權重文件、以及額外的解碼時間。

即便如此,這種非常規穩定擴散用例,還是較實際的解決方案更加有趣,甚至有望開辟圖像合成模型的未來新用途。

感興趣的朋友,可移步至 Google Colab 查看 Bühlmann 的示例代碼,或在有關 Towards AI 的帖子中找到實驗中的更多技術細節。