過去一年多,矽谷掀起的生成式AI革命席卷全球,並愈演愈烈。而在這場革命有中兩條非常明顯的主線:一是基礎技術的進化,以GPT、Gemini為代表的大模型繼續向著AGI(通用人工智能)迭代;二是現象級應用的湧現,生成式AI在不同領域、不同場景下的應用狂潮在逐步改變人類的生活和工作方式,比如雷科技尤其關註的AI硬件領域,就出現AI手機、AIPC、AI電視、AI傢電、AI清潔等新應用。

在兩條主線下,還有一條關於算力的“暗線”。

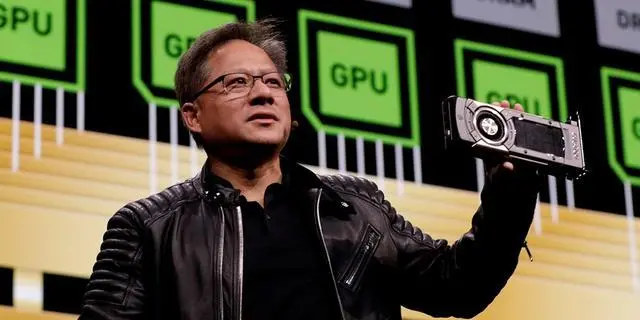

對 AI 的發展來說,算力短缺已經不是一天兩天的問題,時至今日各大公司都還在繼續搶購 GPU,更確切地說,是英偉達的高端 GPU:

如果說《沙丘》是“得香料者得天下”,那 AI 行業就是“得英偉達 GPU 者得天下”。

圖/英偉達

這也讓整個行業對於英偉達 GPU 又愛又恨,一方面是基於 CUDA 平臺的英偉達高端 GPU 可以簡單、高效地進行人工智能訓練,另一方面是所有人都過於依賴英偉達這一傢公司。

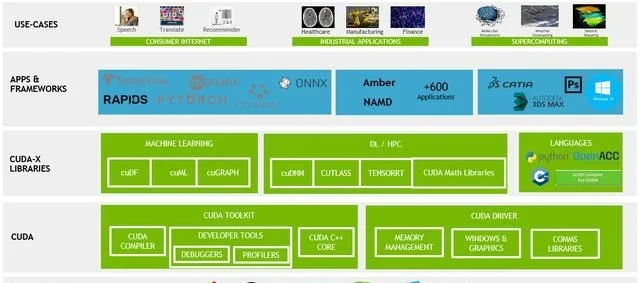

CUDA是英偉達AI的基石

關於英偉達 GPU 成功原因的分析已經很多,其核心主要還是英偉達 GPU 本身的高性能(包括互連性能),加上 CUDA 平臺帶來的軟硬件協同效應。英偉達在硬件本身上的優勢並不難逾越,問題關鍵在於軟件,在於 CUDA 平臺。

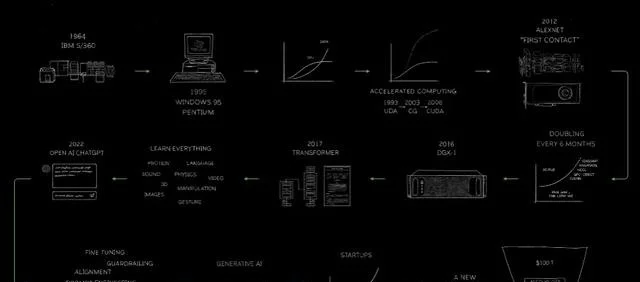

在前段時間的GTC 2024開幕演講上,老黃也回顧英偉達的發展史。

2014年,黃仁勛首次強調機器學習的重要性,當時AlphaGo尚未戰勝李世石,深度學習並未引發世界級關註。不過當時英偉達已提出CUDA(通用計算平臺)的概念,在許多人還在把英偉達當作“遊戲顯卡”的制造商時,其走在 AI 變革前沿。

不過最初,CUDA的應用場景主要是科學計算,就是類似於氣候模擬、物理模擬、生物信息學等專業研究,應用場景很有價值,但卻狹窄。正因為此,英偉達的CUDA一直沒有打開市場,帶給英偉達的回報無法與對應的巨量研發投入匹配。黃仁勛每年都需要向董事會解釋,為什麼英偉達要堅持做CUDA?

其實當時老黃也不知道,英偉達的CUDA會在未來幾年,先後迎來區塊鏈“挖礦”、AI大模型計算等計算場景,真實潑天富貴。

(圖源:英偉達)

短短兩年時間,英偉達通過H100、H200 芯片,締造萬億AI帝國,市值已超越亞馬遜等傳統豪強,按照這樣的勢頭,在可見的未來,超越蘋果、微軟成為世界頭號巨頭也不是沒有可能。

現在,英偉達的“卡”供不應求,不隻是字節、百度等中國科技巨頭在搶著囤卡以應對極端情況,矽谷科技巨頭如微軟、Meta,也全都在找老黃買卡。

在被稱為AI應用元年的2024,英偉達的CUDA(通用計算平臺)正如其名,變得通用起來,從大語言模型、對話式AI、邊緣計算等底層技術,到智能座艙、自動駕駛、人形機器人等應用場景,再到AI手機、AI PC、AI傢電、AI搜索、AI繪畫等應用,以及未來的氣候預測、計算光刻與6G網絡,AI正無處不在,英偉達的計算也無處不在,成為“通用計算”。

當英偉達的卡以及CUDA平臺越來越重要時,其他科技巨頭看到“制霸”危機:

一方面,英偉達的卡價格不菲,且擁有絕對定價權,廠商們囤積GPU卡要給英偉達巨額資金,結果就是:做AI的不一定賺錢(當前幾乎都不賺錢),英偉達卻賺爆。

另一方面,科技巨頭被英偉達卡脖子。英偉達可以決定最頂尖的卡先給誰,給多少,給不給。此外,英偉達也依托GPU的計算資源向上層業務拓展,涉足雲等業務,與科技巨頭形成一定的競爭。

事實上從 2023 年開始,很多芯片廠商和大模型廠商都意識到這些問題,紛紛希望通過另建一套軟件平臺對抗英偉達的 CUDA。不能說所有嘗試都失敗,隻能說目前還沒有出現真正的挑戰者。

如今,一個新聯盟和開源平臺,可能會徹底改變英偉達 CUDA 一傢獨大的局面——如同當初Google振臂高呼組建的OHA聯盟以及開源的Android對抗蘋果一般。因緣際會的是,在這一輪打破CUDA霸權的戰爭中,Google依然扮演至關重要的角色,Android陣營的高通、ARM們也在發揮各自的關鍵作用。

日光之下,無新事。

巨頭組建聯盟反抗CUDA

“整個行業都希望能幹掉 CUDA,包括Google、OpenAI 等公司都在想方設法讓人工智能訓練更加開放。我們認為 CUDA 的護城河既淺又窄。”在去年年底的一場活動上,英特爾 CEO 帕特·基辛格(Pat Gelsinger)語出驚人地指出對於英偉達 CUDA 平臺的看法。

但即便基辛格認為 CUDA 的護城河“既窄又淺”,他也明白挑戰在人工智能訓練上挑戰英偉達,絕非易事。

根據路透社報道,Linux 基金會聯合英特爾、Google、高通、ARM 以及三星等公司成立統一加速基金會(UXL),以英特爾的 oneAPI 為起點,正在開發一套開源軟件套件,允許人工智能開發者在任何 AI 芯片上運行他們的代碼。

圖/ UXL

這裡需要簡單介紹下,oneAPI 是英特爾的統一編程模型和軟件開發框架,可以讓開發者無需對代碼進行重大修改,就能借助 oneAPI 實現跨硬件架構(包括英特爾的 CPU、GPU 和 FPGA)的程序開發。

簡單來說,UXL 就是在 oneAPI 的基礎上更進一步,要實現更廣泛的跨架構跨平臺支持,解除芯片硬件與軟件的強綁定關系。

而集合芯片廠商、大模型廠商以及晶圓代工廠的 UXL,無疑是想取代英偉達 CUDA 平臺,成為全球人工智能開發者的首選開發平臺。高通人工智能和機器學習主管 Vinesh Sukumar 就明確表示:

“我們實際上是在向開發者展示如何從英偉達平臺遷移出來。”

甚至,UXL 最終也將支持英偉達的硬件和代碼。

而除最初參與的創始成員,UXL 還吸引包括亞馬遜 AWS、微軟 Azure 以及多傢芯片廠商。同時根據規劃,UXL 預計在今年上半年確定技術規范,在年底前將技術細節完善成熟。

至於 UXL 能不能成功替代掉 CUDA,成為全球人工智能開發者的首選平臺,顯然還需要一系列的證明,畢竟超越 CUDA:

真的很難。

對抗 CUDA,到底難在哪裡?

首先我們需要明白,CUDA 既是一種編程語言,也是一種編譯器。

作為編程語言,CUDA 是開發者通過 CUDA 與底層硬件(GPU)溝通、調用算力的一種方式,新建一套新的編程語言並不難。作為編譯器,CUDA 無疑有很高的性能,這意味著開發者可以通過 CUDA 在 GPU 上更高效地執行程序,用更容易理解的話說:

CUDA 可以高效地利用 GPU 的峰值算力。

CUDA,圖/英偉達

考慮到今天人工智能訓練對於大算力、高性能的追求,也無怪乎開發者對於 CUDA 的偏愛。

但實際上英偉達在這兩個層面上絕非天下無敵,尤其是 OpenAI 開源的 Triton,不僅能在英偉達的 GPU 上實現接近 CUDA 的執行效率,還在合並 AMD ROCm(對標 CUDA)等平臺的代碼,兼容更多的 GPU。

CUDA 難以被撼動的關鍵在於,它還是一種生態。

去年臺北電腦展上,老黃透露有 400 萬開發者正在使用 CUDA 計算平臺。而且在過去十幾年間(CUDA 推出於 2007 年),CUDA 已經積累大量的高性能程序庫以及框架代碼。這也是為什麼盡管連 OpenAI 都吐槽用 CUDA 為 GPU 編程的難度,但更多開發者還是基於 CUDA,而不是 Triton 進行開發。

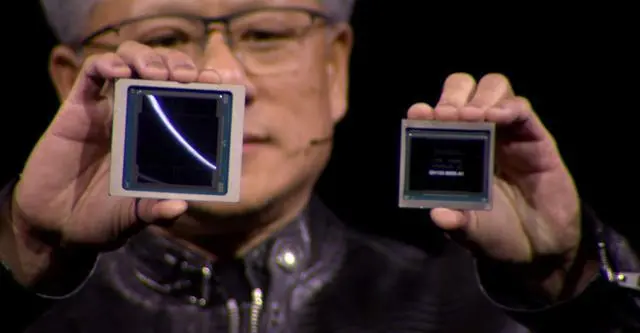

另一方面,英偉達的軟硬件協同設計也讓這種優勢更加牢不可破。

要知道,Triton 可以兼容英偉達的 GPU,其他 GPU 也可以兼容 CUDA,甚至在效率上後來居上也並非不可能。但軟件適配硬件需要時間,尤其是在 GPU 上需要更長的時間。

這意味著英偉達一旦發佈新的 GPU 和 CUDA 版本,不管是兼容 CUDA 還是兼容英偉達的 GPU,就需要重新追趕英偉達的腳步。

(老黃最新發佈的 Blackwell,圖/英偉達)

所以某種程度上,能打敗英偉達的隻有采用軟硬件協同設計的策略,同時擁有強大的芯片能力和軟件能力。

用“Android模式”,打破英偉達算力霸權

Google擁有自己的 TPU、XLA 計算平臺,還有自己的大模型和一系列算力“出口”。但Google這套並不外賣,所以包括 Authropic(Claude 母公司)、Midjourney 都是通過Google雲使用這一套算力解決方案,而沒有選擇購買英偉達的 GPU。

從這角度來看,UXL 雖然聚集從晶圓代工廠到芯片廠商,再到雲計算和大模型廠商,涵蓋 AI 芯片的主要上下遊,但真正的挑戰還在於不同成員之間的協同,這也是 UXL 能不能成功的關鍵。

如果沒有足夠的利益捆綁,每一個“聯盟”都難成氣候,聚集得多高調,渙散就有多迅猛。Android生態能成功的關鍵在於,系統平臺、半導體、硬件、開發者等等參與者能各取所需,一起將蛋糕做大。UXL 是否能形成同樣的正循環效應?當下,我們不知道答案。

年初,OpenAI Sam Altman 語不驚人死不休,曝出計劃籌集 7 萬億美元解決 AI 面對的算力問題。雖然這個數字驚掉所有人的下巴,但也再一次地說明,以 OpenAI 為代表的人工智能行業對於算力的極度渴求——在微軟支持下,OpenAI也在佈局自有芯片體系。

總而言之,英偉達不能滿足所有人,所有人也不滿足於隻有一傢英偉達。換句話說,不管 UXL 能不能成功,Google會不會改變策略,所有人都會繼續挑戰英偉達:

直到打破算力霸權。