隻需3秒鐘,一個根本沒聽過你說話的AI,就能完美模仿出你的聲音。是不是細思極恐?這是微軟最新AI成果——語音合成模型VALL·E,隻需3秒語音,就能隨意復制任何人的聲音。它脫胎於DALL·E,但專攻音頻領域,語音合成效果在網上放出後火:

有網友表示,要是將VALL·E和ChatGPT結合起來,效果簡直爆炸:

看來與GPT-4在Zoom裡聊天的日子不遠。

還有網友調侃,(繼AI搞定作傢、畫傢之後)下一個就是配音演員。

所以VALL·E究竟怎麼做到3秒鐘模仿“沒聽過”的聲音?

用語言模型來分析音頻

基於AI“沒聽過”的聲音合成語音,即零樣本學習。

語音合成趨於成熟,但之前零樣本語音合成效果並不好。

主流語音合成方案基本是預訓練+微調模式,如果用到零樣本場景下,會導致生成語音相似度和自然度很差。

基於此,VALL·E橫空出世,相比主流語音模型提出不太一樣的思路。

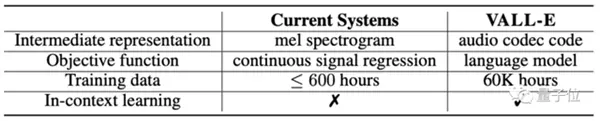

相比傳統模型采用梅爾頻譜提取特征,VALL·E直接將語音合成當成語言模型的任務,前者是連續的,後者是離散化的。

具體來說,傳統語音合成流程往往是“音素→梅爾頻譜(mel-spectrogram)→波形”這樣的路子。

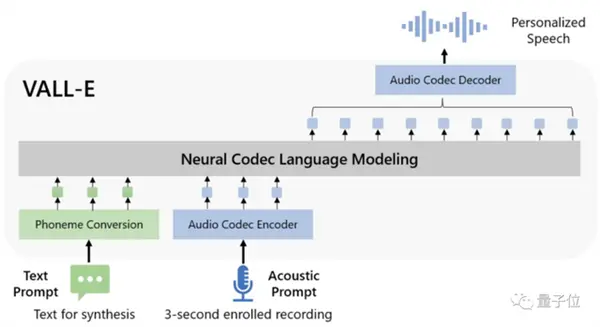

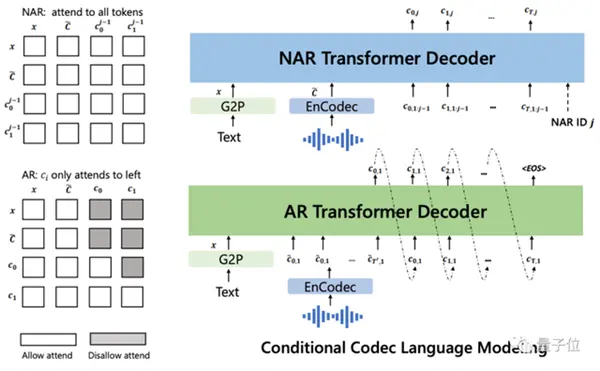

但VALL·E將這一流程變成“音素→離散音頻編碼→波形”:

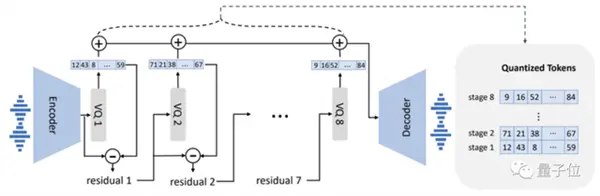

具體到模型設計上,VALL·E也和VQVAE類似,將音頻量化成一系列離散tokens,其中第一個量化器負責捕捉音頻內容和說話者身份特征,後幾個量化器則負責細化信號,使之聽起來更自然:

隨後以文本和3秒鐘的聲音提示作為條件,自回歸地輸出離散音頻編碼:

VALL·E還是個全能選手,除零樣本語音合成,同時還支持語音編輯、與GPT-3結合的語音內容創建。

那麼在實際測試中,VALL·E的效果如何呢?

連環境背景音都能還原

根據已合成的語音效果來看,VALL·E能還原的絕不僅僅是說話人的音色。

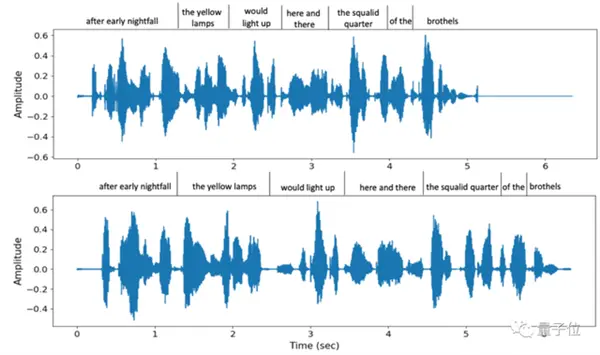

不僅語氣模仿到位,而且還支持多種不同語速的選擇,例如這是在兩次說同一句話時,VALL·E給出的兩種不同語速,但音色相似度仍然較高:

同時,連說話者的環境背景音也能準確還原。

除此之外,VALL·E還能模仿說話者的多種情緒,包括憤怒、困倦、中立、愉悅和惡心等好幾種類型。

值得一提的是,VALL·E訓練用的數據集不算特別大。

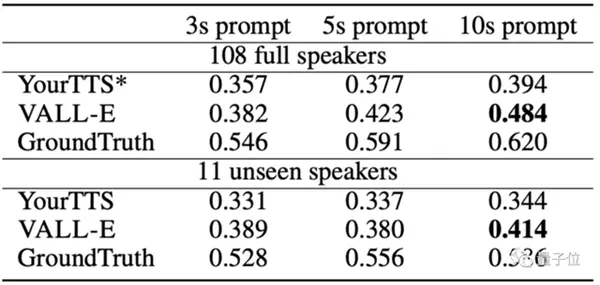

相比OpenAI的Whisper用68萬小時的音頻訓練,在隻用7000多名演講者、6萬小時訓練的情況下,VALL·E就在語音合成相似度上超過經過預訓練的語音合成模型YourTTS。

而且,YourTTS在訓練時,事先已經聽過108個演講者中的97人聲音,但在實際測試中還是比不過VALL·E。

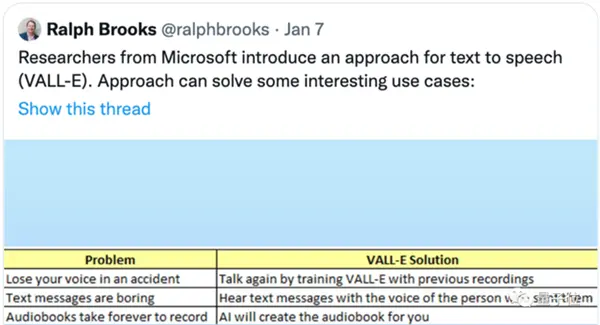

有網友已經在暢想它可以應用的地方:

不僅可以用在模仿自己的聲音上,例如幫助殘障人士和別人完成對話,也可以在自己不想說話時用它代替自己發語音。

當然,還可以用在有聲書的錄制上。

不過,VALL·E目前還沒開源,要想試用可能還得再等等。

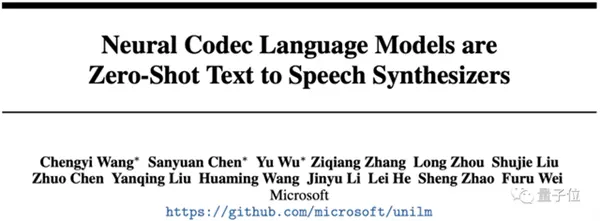

作者介紹這篇論文所有作者均來自微軟,其中有三位共同一作。

一作Chengyi Wang,南開大學和微軟亞研院聯合培養博士生,研究興趣是語音識別、語音翻譯和語音預訓練模型等。

共同一作Sanyuan Chen,哈工大和微軟亞研院聯合培養博士生,研究方向包括自監督學習、NLP和語音處理等。

共同一作Yu Wu,微軟亞研院NLP小組研究員,在北航獲得博士學位,研究方向是語音處理、聊天機器人系統和機器翻譯等。