據路透社研究所的一項調查顯示,截至2023年底,10個國傢/地區近一半(48%)的熱門新聞網站屏蔽OpenAI的爬蟲,而近四分之一(24%)屏蔽Google的AI爬蟲。路透社研究所分析15個覆蓋范圍最廣的在線新聞來源的robots.txt,其中包括《紐約時報》、BuzzFeedNews、《華爾街日報》、《華盛頓郵報》、CNN和NPR等標題,涵蓋德國、印度、西班牙等國傢/地區、英國和美國。

由於缺乏明確的監管框架來管理生成式人工智能對受版權保護的材料的使用,許多大型出版商自行解決問題,將人工智能公司告上法庭,更新服務條款,阻止爬蟲或達成交易以保護優質內容,數據和收入。

該研究將媒體分為三類:傳統印刷出版物、電視和廣播電臺以及數字媒體。

到 2023 年底,超過二分之一 (57%) 的傳統印刷出版物網站(例如《紐約時報》)將屏蔽 OpenAI 的爬蟲程序,而電視和廣播公司的這一比例為 48%,數字媒體的比例為 31%。

同樣,32% 的印刷媒體屏蔽 Google 的抓取工具,而 19% 的廣播公司和 17% 的數字媒體也采取同樣的做法。

Gartner 副總裁、傑出分析師安德魯·弗蘭克 (Andrew Frank) 表示:路透社的研究強調生成式人工智能面臨的一個根本挑戰:它依賴於真實的人生成的真實內容,而這些人將其視為對其生計的威脅。

與此同時,康奈爾大學最近的一項研究發現,當新的人工智能模型根據先前模型而不是人類輸入的數據進行訓練時,它們往往會模型崩潰或退化,導致生成的輸出中錯誤和錯誤信息增加。

“這表明大型語言模型開發人員需要找到方法來補償那些創建或報告真實內容的人,這不僅是為社會,也是為他們自己的商業利益。”弗蘭克說。

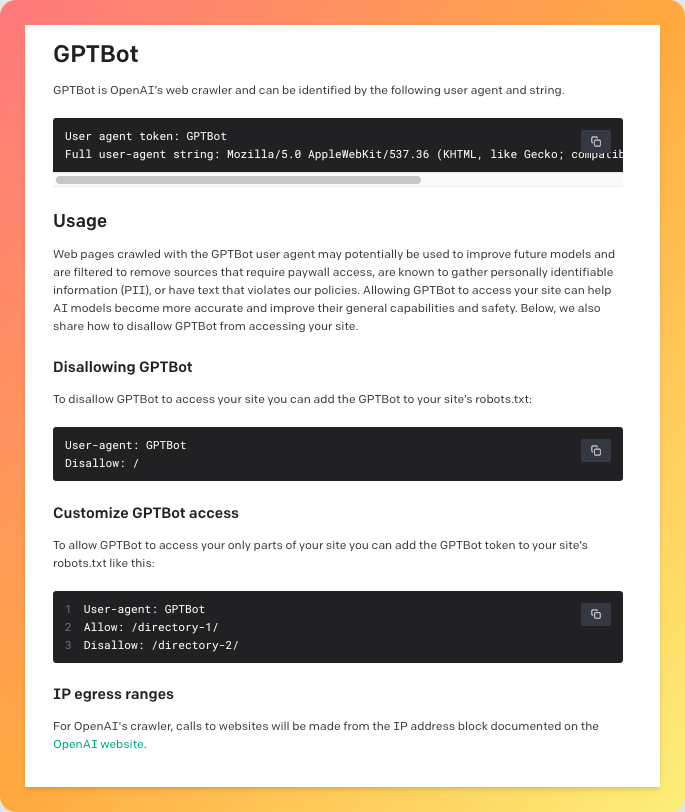

部署網站爬蟲的原因有很多。像Google的 Googlebot 這樣的爬蟲會在這傢科技巨頭的搜索結果中索引出版商網站。與此同時,OpenAI 的爬蟲 GPTBot 通過互聯網收集數據來訓練其大型語言模型,例如 ChatGPT。這使得人工智能工具能夠生成準確的同步數據——新聞出版商尤其具有獨特的優勢來提供這種能力:GoogleAI的權重比優質出版商的內容高出5 到 100倍。人工智能驅動的解決方案正在成為傳統搜索引擎的替代品。

根據這項研究,與南半球的新聞媒體相比,北半球的新聞媒體更傾向於阻止人工智能爬蟲。

在美國,79% 的頂級在線新聞網站屏蔽 OpenAI,而在墨西哥和波蘭,隻有 20% 的網站這樣做。與此同時,德國 60% 的新聞網站屏蔽Google的爬蟲,而波蘭和西班牙則有 7% 的新聞網站屏蔽Google的爬蟲。

幾乎所有屏蔽 Google AI 的網站也屏蔽 OpenAI(97%)。盡管該研究沒有對這一趨勢提供明確的解釋,但它表明 OpenAI 在 Google 之前發佈其爬蟲程序可能對此有所貢獻。

與此同時,在大多數國傢/地區,一些出版商在這兩套爬蟲程序發佈後立即對其進行屏蔽。OpenAI 於去年 8 月初推出人工智能爬蟲,Google也於 9 月緊隨其後。根據這項研究,一旦做出屏蔽決定,沒有任何網站會改變立場,解除對 OpenAI 或 Google AI 爬蟲的屏蔽。