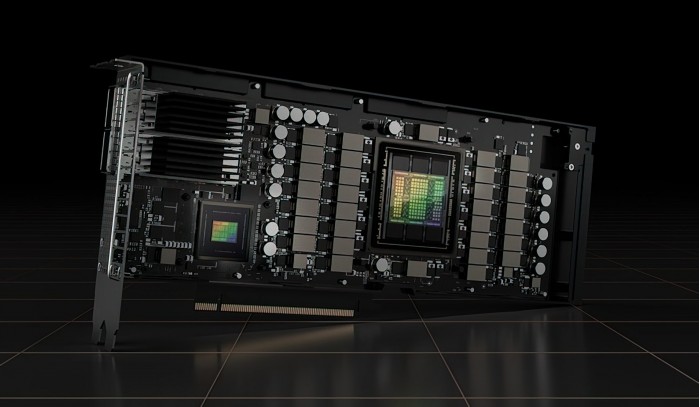

近日有消息稱,英偉達正在開發一款HopperH100PCIe加速卡,特點是具有高達120GB的HBM2e顯存。截至目前,該公司已經發佈兩個版本的HopperH100GPU,分別是SXM5和PCIe板型。雖然兩款SKU都配備80GBVRAM,但前者用上全新的HBM3標準、而後者仍為HBM2e。

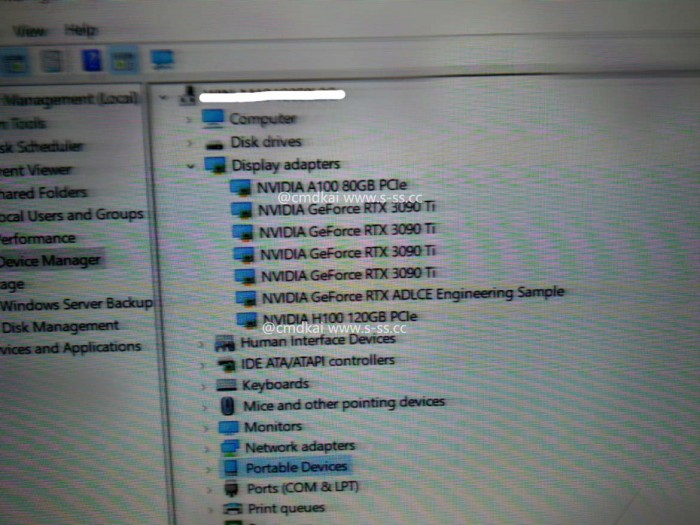

最新消息是,據 s-ss.cc 爆料,英偉達可能正在開發全新的 PCIe 擴展卡版本的 Hopper H100 GPU —— 但它並未配備 80GB HBM2e VRAM、而是增加到 120GB 。

消息稱這張新卡配備六個 HBM2e 堆棧、擁有 6144-bit 總線位寬 @ 120GB VRAM、輔以 SXM5 同款 GH100 GPU 。

總計 16896 個 CUDA 核心、帶寬超 3 TB/s、單精度性能 30 TFLOPS —— 與 SXM5 版本相當。

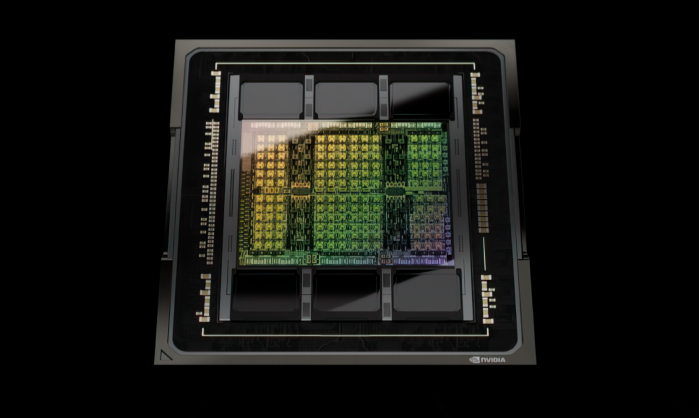

照此規格,英偉達 Hopper GH100 GPU 擁有 144 組 SM 流處理器 / 8 個 GPC —— 每組 GPC 包含 9 個 TPC,每 TPC 由 2 組 SM 單元組成。

每組 SM 單元最多由 128 個 FP32 單元,那樣滿血版應該是 18432 個 CUDA 核心。

GH100 GPU 完整規格參考:

● 每顆 GPU 擁有 8 GPC、72 TPCs(9 TPC / GPC)、2 SM / TPC、144 SM 單元

● 每組 SM 單元擁有 128 個 FP32 CUDA 核心,每顆 GPU 擁有 18432 個 FP32 CUDA 核心。

● 每組 SM 單元擁有 4 個第四代張量核心,每顆 GPU 擁有完整 576 個 Tensor Cores 。

● 6 組 HBM3 或 HBM2e 顯存堆棧,輔以 12 個 @ 512-bit 顯存控制器。

● 配備 60 MB 二級緩存

以下是 SXM5 外形的 NVIDIA H100 GPU 規格:

● 每顆 GPU 擁有 8 GPC / 66 TPC、2 SM / TPC、132 SM 單元

● 每組 SM 單元擁有 128 個 FP32 CUDA 核心,每顆 GPU 擁有 16896 個 FP32 CUDA 核心。

● 每組 SM 單元擁有 4 個第四代張量核心,每顆 GPU 擁有 528 個 Tensor Cores 。

● 5 組 @ 80GB HBM3 顯存堆棧,輔以 10 個 @ 512-bit 顯存控制器。

● 配備 50MB 二級緩存

● 支持第四代 NVLink 和 PCIe 5.0

目前尚不清楚英偉達正在搞測試原型,還是醞釀推出 Hopper H100 GPU 的未來迭代。

不過該公司最近在 GTC 2022 大會上表示,Hopper GPU 現已全面投產,預計首批產品會在下月到來。