斯坦福大學的一個研究小組正在開發一種新的人工智能輔助全息成像技術,並聲稱這種技術比研究人員所見過的任何技術都更薄、更輕、質量更高。這種技術能否將增強現實(AR)頭盔提升到一個新的水平?

斯坦福大學的全息 AR 眼鏡原型。

目前,實驗室版本的視場角很小,在實驗室裡隻有 11.7 度,遠遠小於 Magic Leap 2 甚至微軟 HoloLens。但是,斯坦福大學的計算成像實驗室有一整頁的資料,上面有一個又一個的視覺輔助工具,這些輔助工具表明,該實驗室可能在研究一些特別的東西:更薄的全息組件堆疊,幾乎可以放入標準眼鏡框中,經過訓練,可以投射出逼真的、全彩的、移動的 3D 圖像,這些圖像會在不同深度出現。

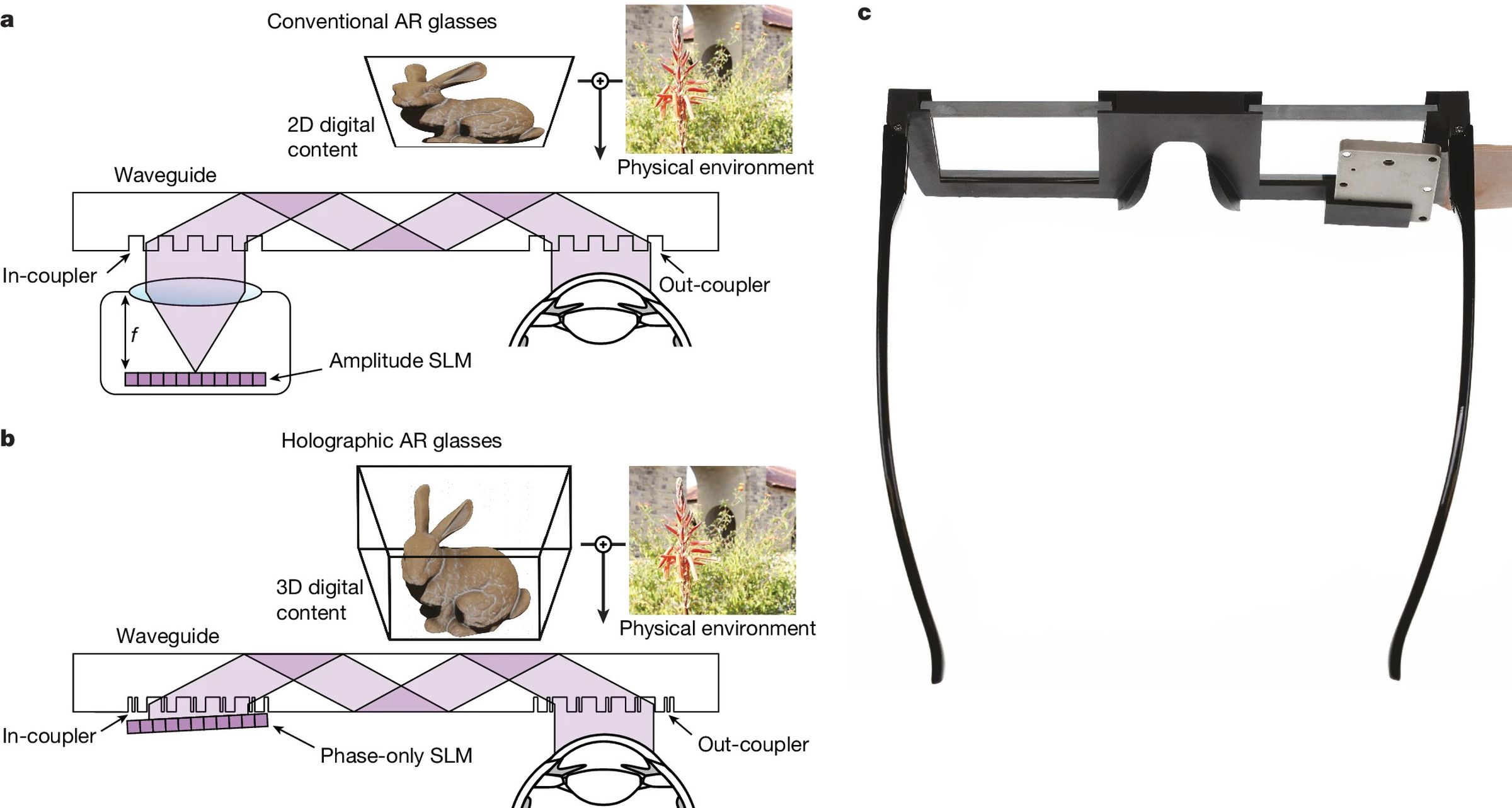

現有 AR 眼鏡(a)和原型眼鏡(b)與 3D 打印原型眼鏡(c)的光學效果對比。圖片:斯坦福計算成像實驗室

現有 AR 眼鏡(a)和原型眼鏡(b)與 3D 打印原型眼鏡(c)的光學效果對比。圖片:斯坦福計算成像實驗室

與其他 AR 眼鏡一樣,這些眼鏡也使用波導,波導是引導光線穿過眼鏡進入佩戴者眼睛的部件。但研究人員說,他們已經開發出一種獨特的"納米光子元表面波導",可以"消除對笨重的準直光學器件的需求",並開發出一種"學習型物理波導模型",利用人工智能算法大幅提高圖像質量。該研究稱,這些模型"利用相機反饋自動校準"。

盡管斯坦福大學的這項技術目前還隻是一個原型,其工作模型似乎是固定在長凳上的,框架也是3D打印的,但研究人員希望能顛覆目前的空間計算市場,這個市場還包括蘋果的Vision Pro、Meta的Quest 3等笨重的直通式混合現實頭盔。

博士後研究員 Gun-Yeal Lee 幫助撰寫這篇發表在《自然》雜志上的論文,他說,目前還沒有其他 AR 系統能在性能和緊湊性方面與之相比。

像 Meta 這樣的公司已經斥資數十億美元購買和構建 AR 眼鏡技術,希望最終能生產出大小和形狀與普通眼鏡無異的完美產品。目前,Meta 的雷朋眼鏡沒有板載顯示屏,但我們去年獲得的泄露的 Meta 硬件路線圖顯示,Meta 第一款真正的 AR 眼鏡的目標日期是 2027 年。