即使全世界都對超級AI如臨大敵,想趕緊懸崖勒馬,恐怕也為時已晚。因為,如今的AI,已經學會自我進化……最近,似乎全世界都在圍剿ChatGPT。前一陣由馬斯克、圖靈獎得主Bengio等大佬聯名發起的暫停高級AI研發的公開信,現在簽名已經上升到9000多人。

即使全世界都對超級AI如臨大敵,想趕緊懸崖勒馬,恐怕也為時已晚。

因為,如今的AI,已經學會自我進化!

前段時間,前Google大腦研究工程師Eric Jang發現:GPT-4能夠以合理的方式批評自己的成果。

與其為大型語言模型(LLM)尋找完美的提示(讓我們一步一步思考),不如讓LLM評估自己的輸出並立即糾正自己的錯誤。

甚至連特斯拉前AI總監,OpenAI研究科學傢Andrej Karpathy大贊,這是一個很好的例子,說明我們還沒有看到GPT-4的最大能力。

在Eric Jang給出的例子中,曾看到微軟研究員發推說GPT-4根本無法寫出‘不押韻’的詩歌。

然而,當再去詢問GPT-4是否完成任務。這時,它道歉後,生成一個不押韻的詩!可以說是滿分。

這恰恰印證GPT-4是有‘反思’能力的。

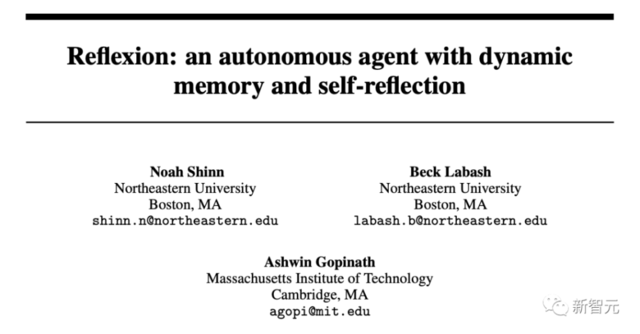

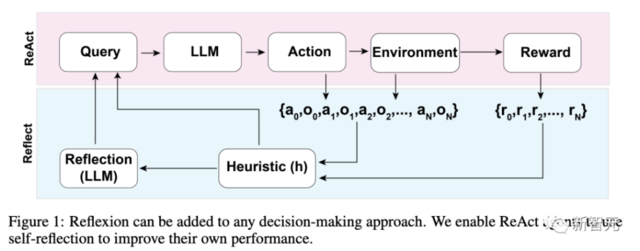

最近,來自美國東北大學、MIT等機構研究者提出Reflexion。這一方法賦予智能體動態記憶,以及自我反思的能力。

論文地址:

為驗證方法的有效性,研究人員評估智能體在AlfWorld環境中完成決策任務的能力,以及在HotPotQA環境中完成知識密集型、基於搜索問答任務的能力。

在這兩項任務的成功率分別為97%和51%。

Reflexion智能體的整體架構

有網友便表示,你可以通過要求 GPT-4 反思‘你為什麼錯?’,並為自己生成一個新的提示,將這個錯誤原因考慮在內,直到結果正確,從而將GPT-4的性能提高驚人的30%。

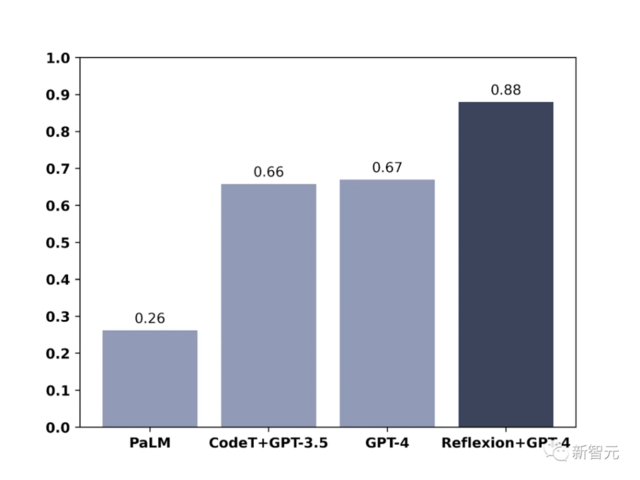

另外,論文指出,在測試模型編寫代碼的能力時,Reflexion+GPT-4也顯著優於常規的GPT-4。

這樣看來,就像Eric Jang所說,

我們現在可以考慮一種‘後綴提示工程’,而不是巧妙的‘前綴提示工程’。這將鼓勵LLM在先前生成的解決方案中找到更正和不一致的地方。