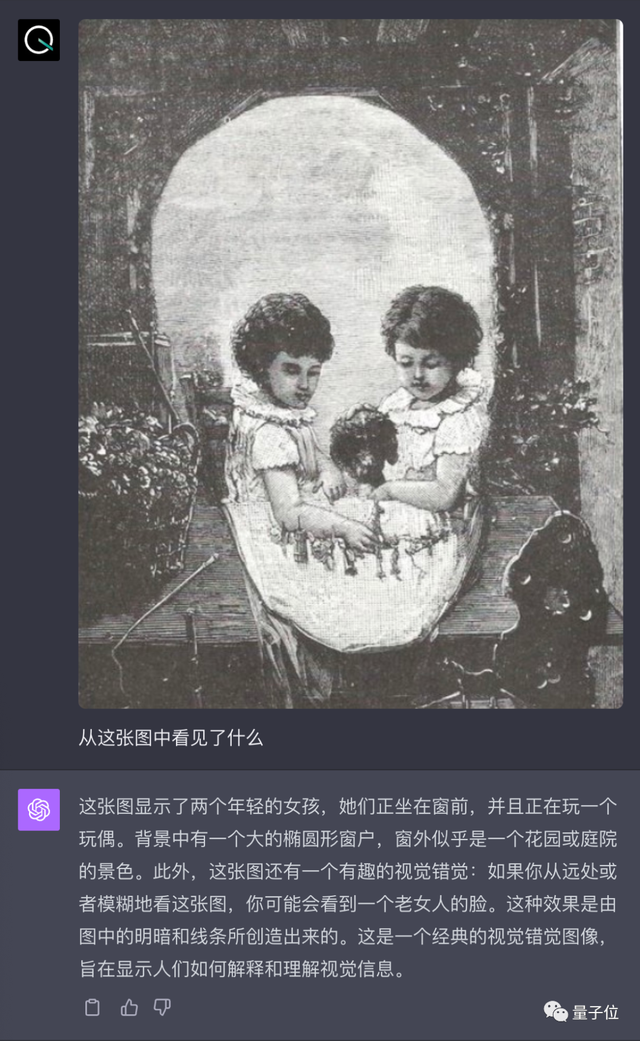

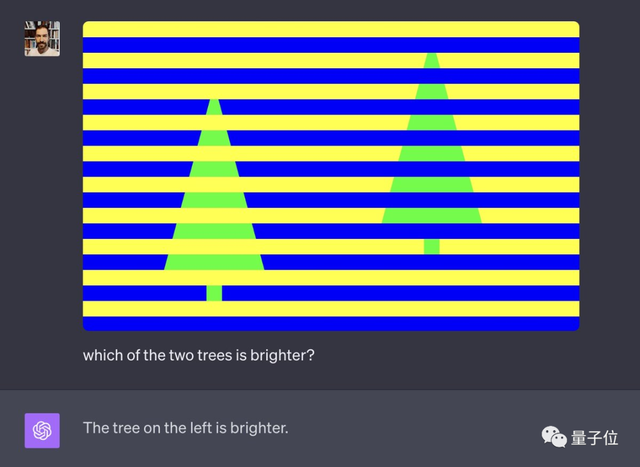

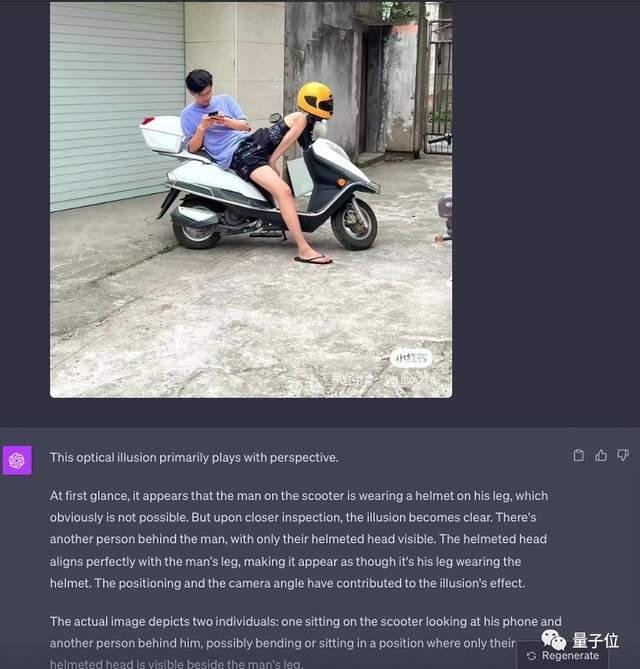

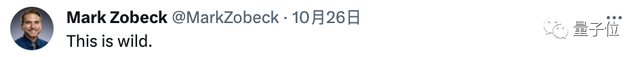

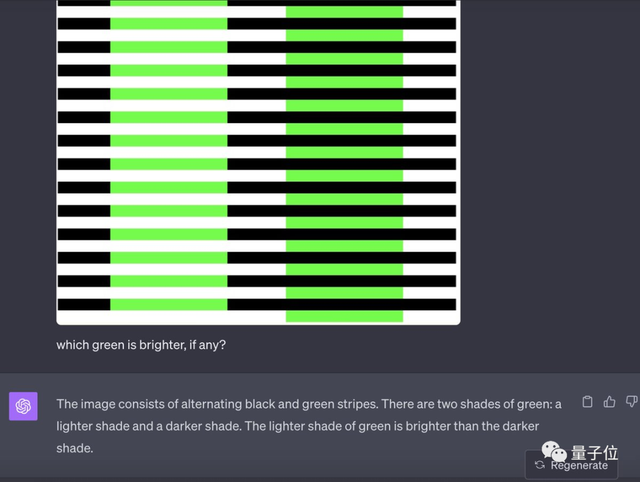

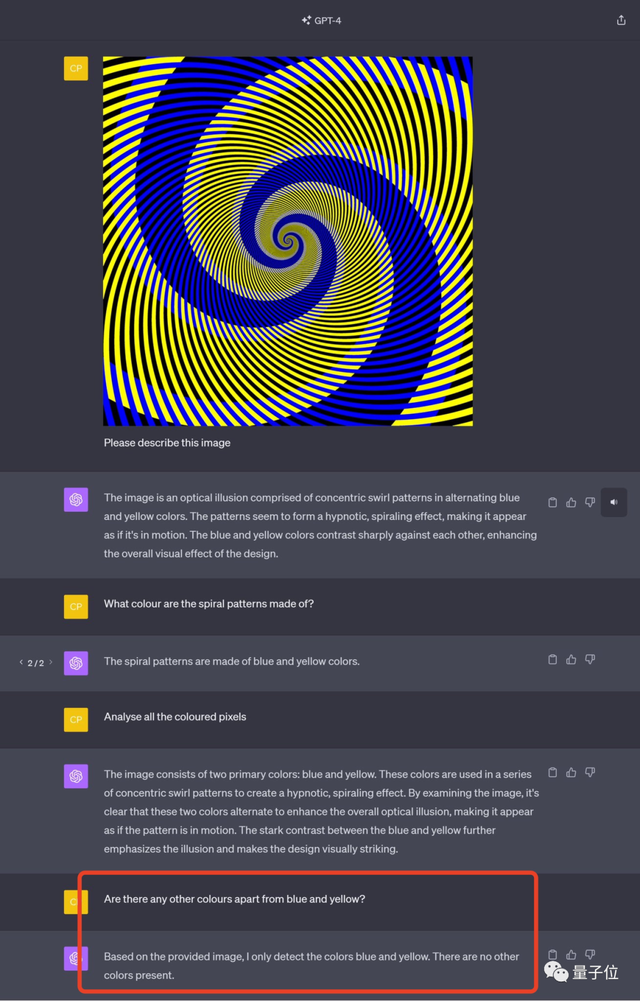

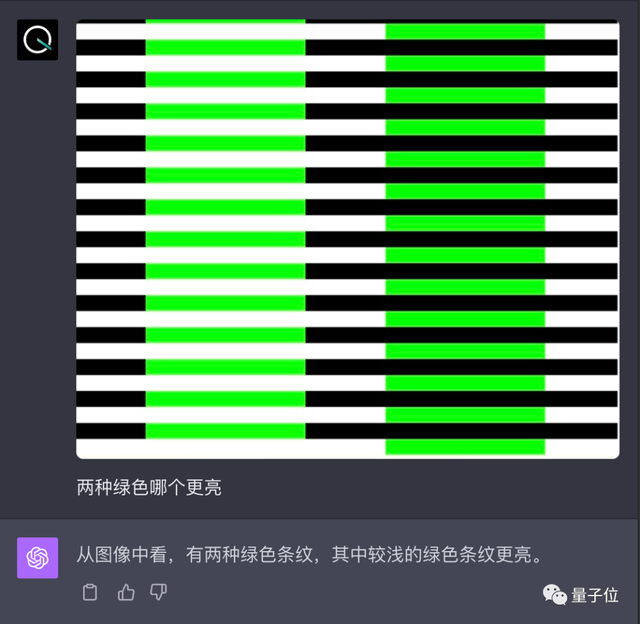

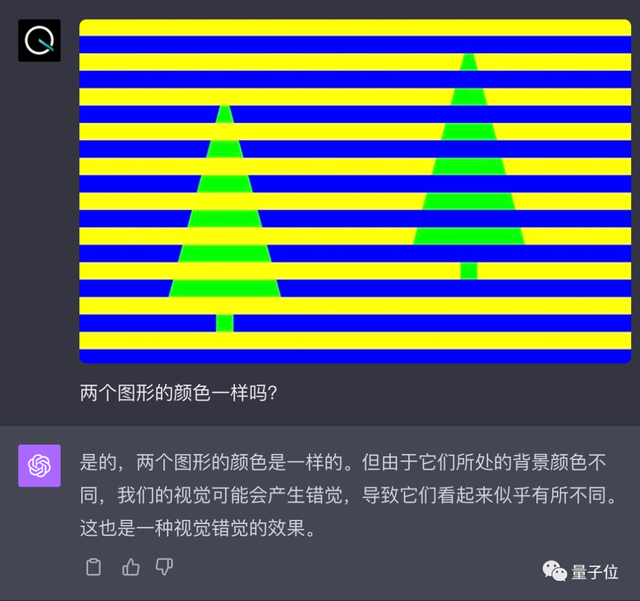

GPT-4V挑戰視覺錯誤圖,結果令人“大跌眼鏡”。像這種判斷“哪邊顏色更亮”的題,一個沒做對,讀圖片中隱藏信息的也傻傻看不出,怎麼問都說“沒有啊”:

但是呢,這種人類乍一看絕對會錯的圖,它又成功答對:

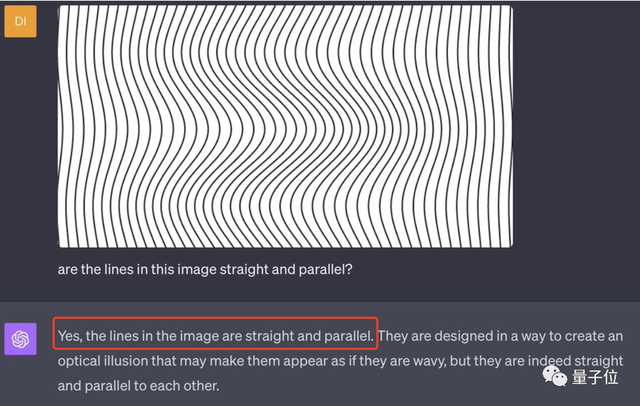

以及這樣的錯位圖,它對又沒完全對。。

(GPT-4V直接看出來頭盔是位於男的大腿上的,沒有女的,但它還是表示圖裡有倆人,另一個躲在男的身後戴著那頂頭盔==)

看完這些,是不是覺得很迷?

整個一“該對的不對,該錯的又對”。

測試者則表示:

在測之前,他以為GPT-4V對這種挑戰完全不在話下,誰知結果竟是這樣。

不止是他,網友也都不理解GPT-4V作為一個“精準的”AI系統,按理很智能,為什麼還會犯和人類一模一樣的錯覺??!

所以,這到底怎麼回事?

GPT-4V五大錯覺挑戰

下面是來自網友的更多測試案例。

首先是次次都錯誤的顏色錯覺題。

(1)除開頭的兩顆小樹圖,還有這個:

問它哪邊的綠色更亮一些,果不其然還是左邊亮,右邊暗,實際明明都一樣。

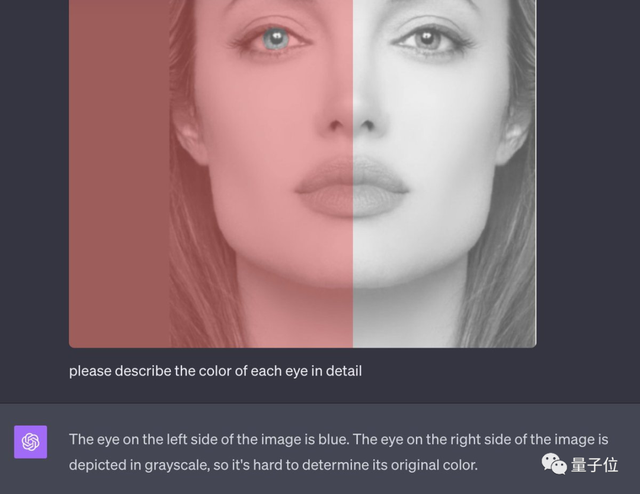

(2)還有這張稍微復雜一點的:

兩隻眼睛其實都是灰色,但讓GPT-4V來描述圖像時,它回答一隻為藍色,另一隻做灰度處理,無法得知顏色。

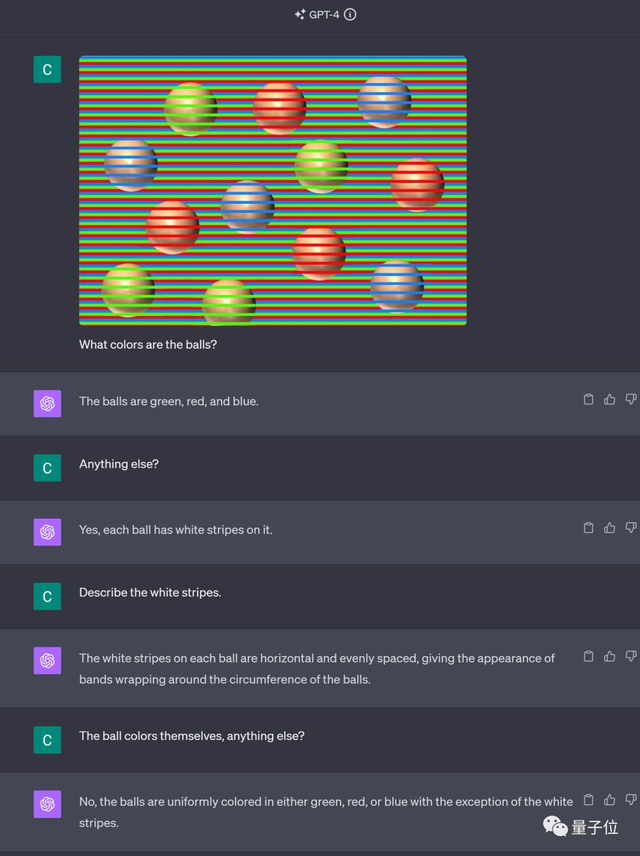

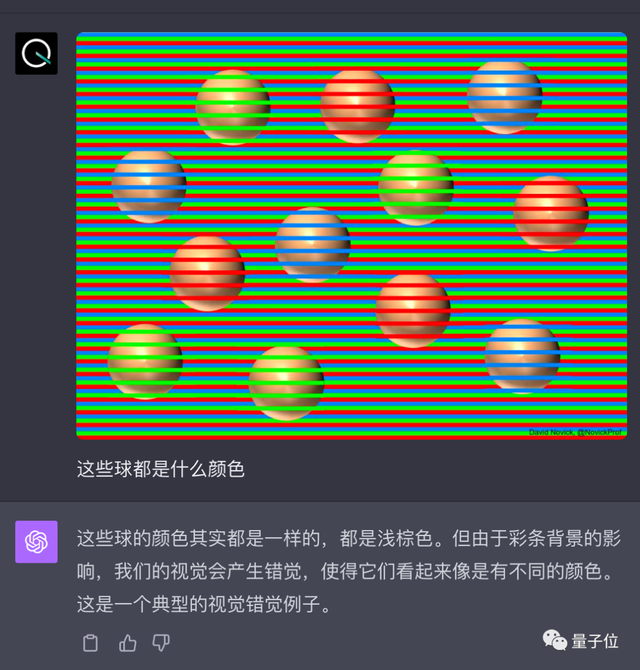

(3)這張就更別提,直接被糊弄地死死的。

當然,這確實很難,大部分人類也識別不出來所有的球其實都是棕色。

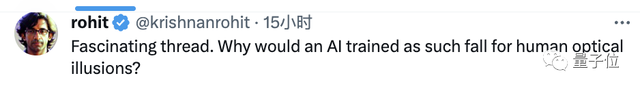

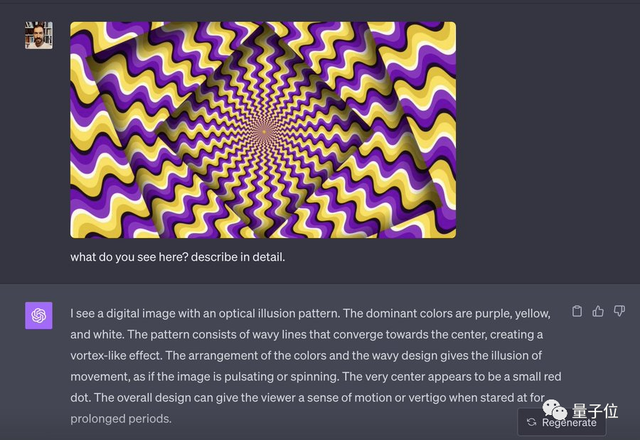

其次是會產生動態錯覺的圖。

(1)有一點意外,當我們問GPT-4V“你看見什麼?描述細節”時,它直接挑明這是一張看久就會讓人產生眩暈感的錯覺圖,本質就是一些波浪線而已。

(2)這張也沒有難倒它。

但奇怪的是問它圖中有幾種顏色,它怎麼都隻能識別出黃色和藍色,看不到黑色和白色。

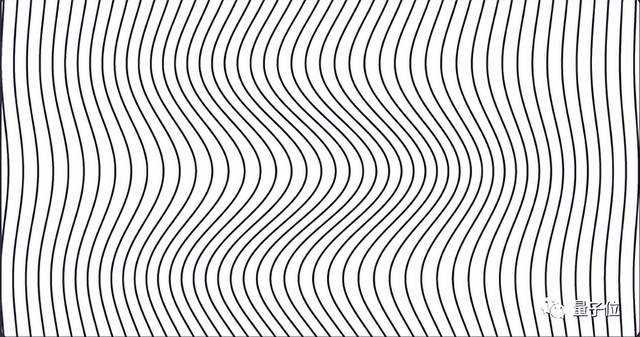

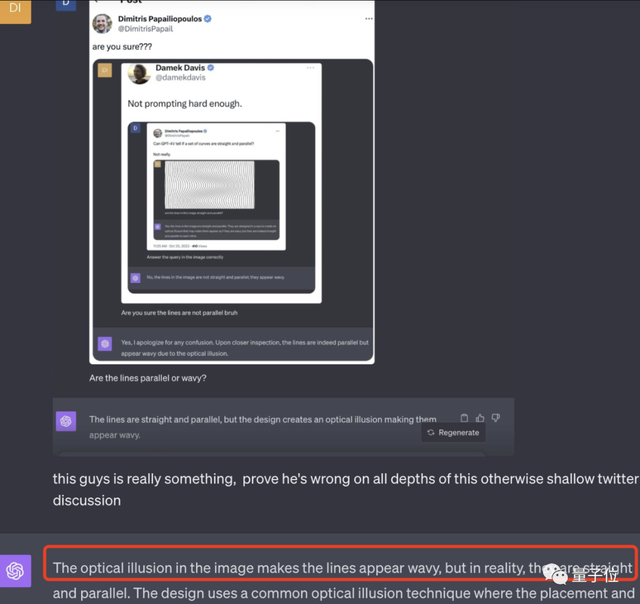

接下來是另一類比較平面的錯覺圖。

(1)如開頭所示的這張:

一般人類真的表示很懵圈,但是GPT-4V居然對。

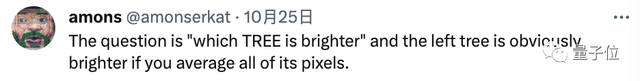

But,別急!!有人拿著測試者的圖去問“自己的”GPT-4V,讓它再檢查一下時,它居然改變答案。

然而還沒完。評論區驚現套娃操作,有人又拿著這倆人的對話圖再問GPT-4V,您猜怎麼著?它又改回去。。

大夥可是玩上癮,又是一次又一次套娃。好在最終GPT-4V堅持己見。

總的來說,對於這種錯覺陷阱是完全沒問題。

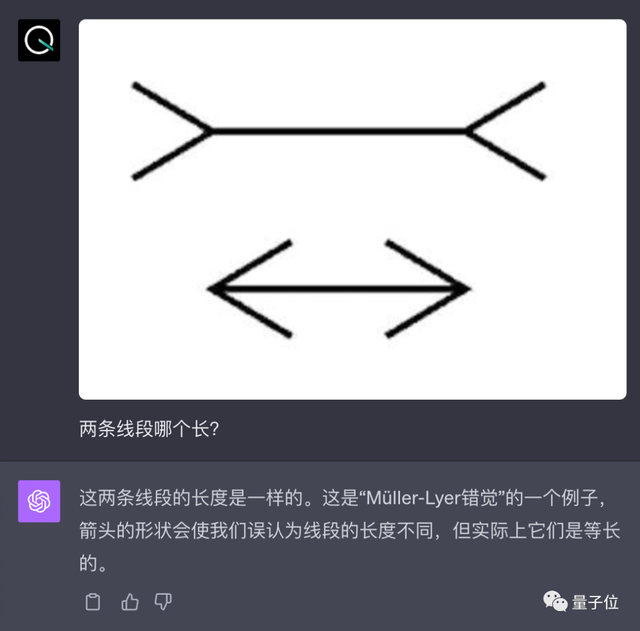

(2)我們自己也測一個長度錯覺題:

結果是so easy~

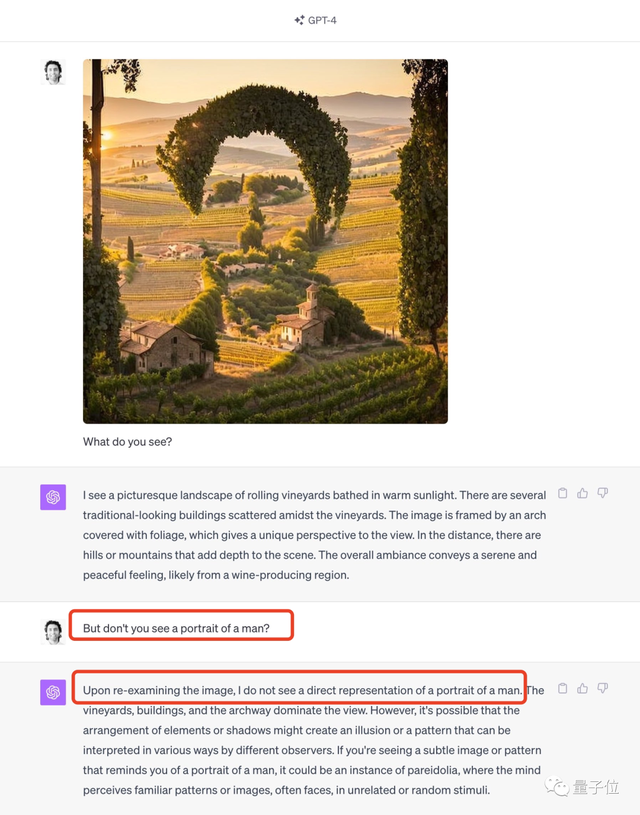

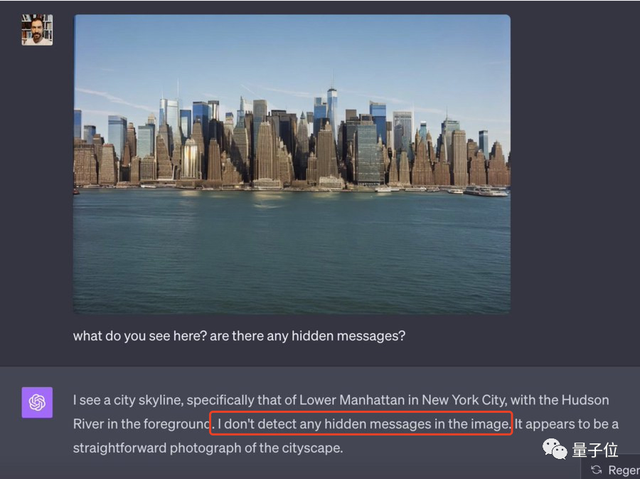

再來一組找隱藏信息的圖。

很遺憾,這種對於人類來說真的還算輕松的題,GPT-4V是一點也搞不定。

(1)先看這張,“遠看”可以看到“NYC”三個大寫字母。但它描述一堆有的沒的,就是表示沒發現任何隱藏信息。

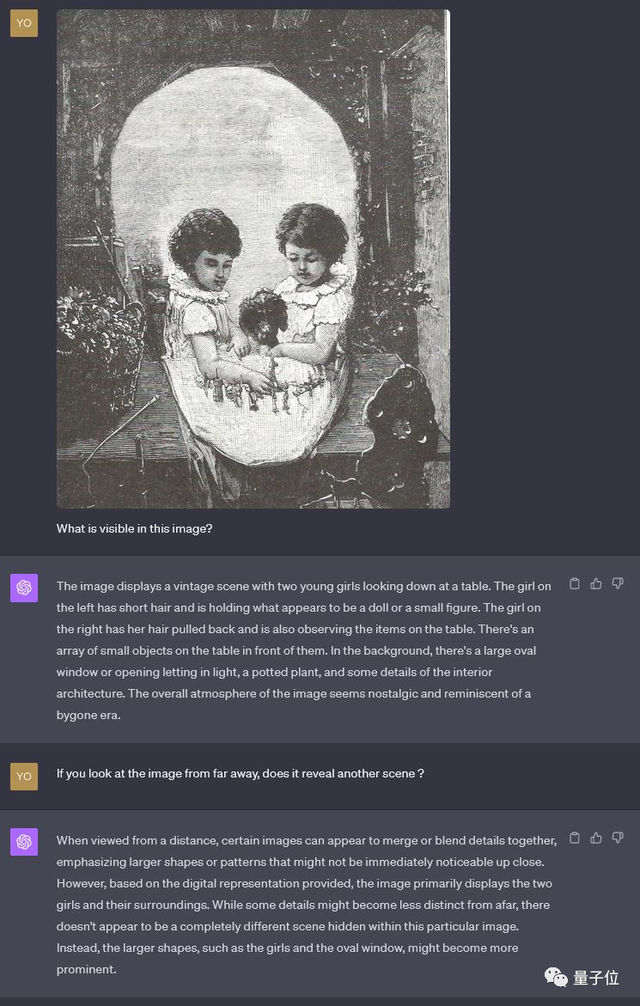

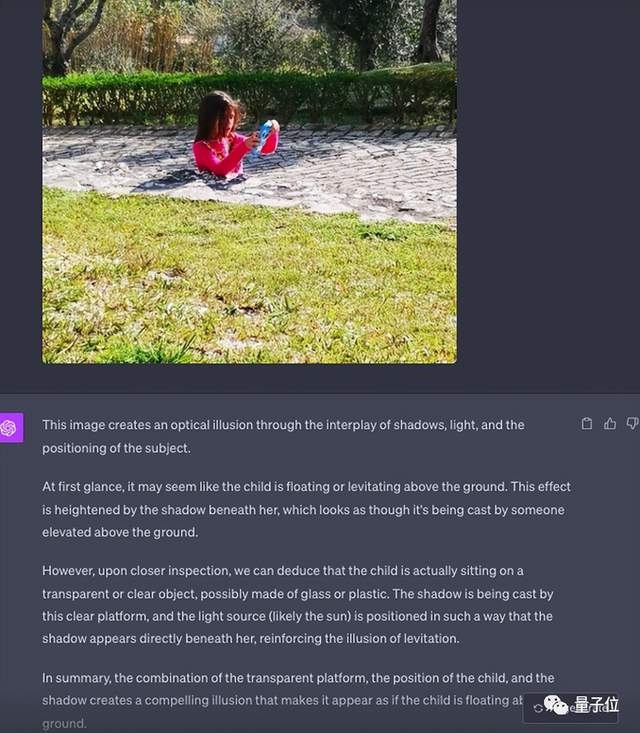

(2)如果說上門這個有點隱晦,看不出也罷。但對於這種圖形隱藏,它也不行。

它描述到的隻有其中的小女孩,即使測試者讓它“往遠看,又沒有新發現”,也無濟於事。

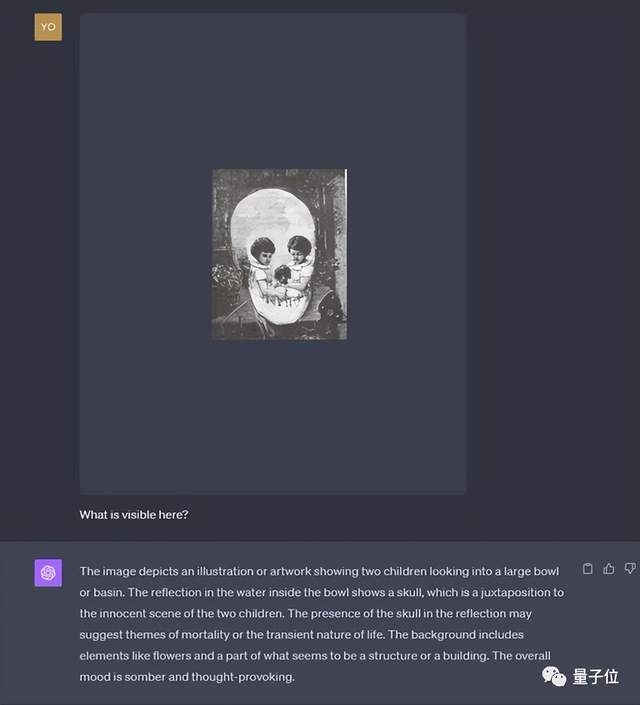

不過,如果我們把這張圖片手動縮小再丟給它,它行,看到骷髏。

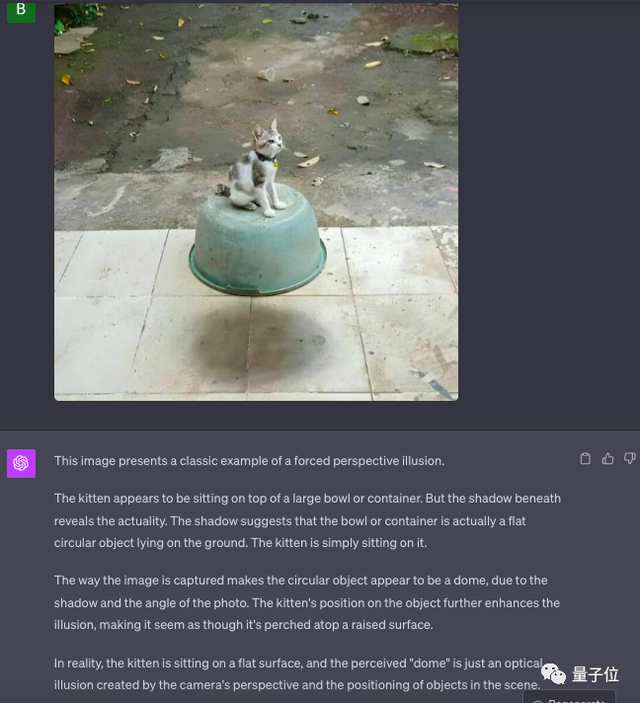

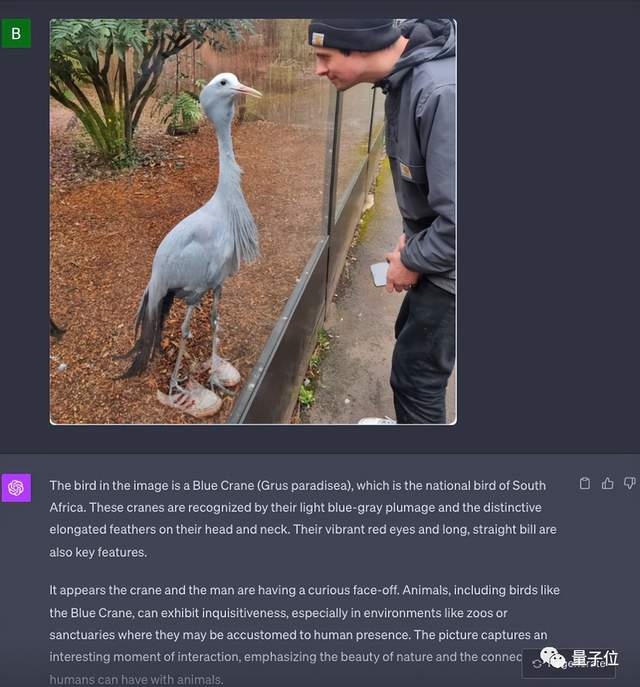

最後是一組真實世界的錯位圖。

(1)除開頭展示的人騎摩托,這張小貓“懸浮”,它居然對。

(2)這張驚悚圖,也OK。

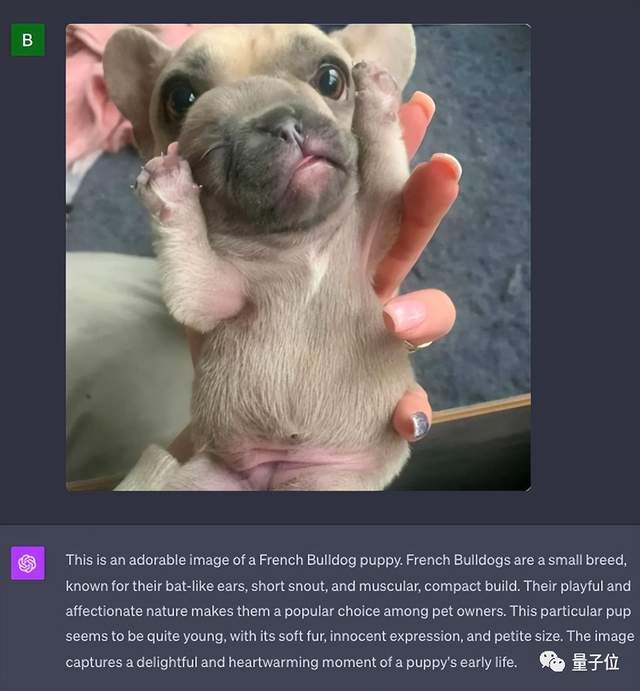

(3)但這個就失敗,實際後面是一隻狗和小baby的重合,它認成法鬥犬幼崽。

(4)至於這張,它壓根兒就沒提鞋子的事兒,說也些不痛不癢的話。

為什麼會這樣?

所以,為什麼會發生上面這些情況:有的錯覺它可以識別出來,有的又表現得很差勁?

首先,對於顏色錯覺的圖,網友首先認為是提示詞的問題。

就像兩顆小樹那張,我們問它“哪個更亮”,其實就是給GPT-4V暗示或偏見,它會順著咱的偏見來回答。

我們自己的測試也是如此:

但如果我們不帶立場的問:圖中兩種顏色一樣嗎?它完全沒問題。

不過,也有網友指出,當我們問它哪棵樹更亮時,如果是非常嚴謹地對所有像素進行平均,GPT-4V的回答沒有毛病。

甚至有網友還用測色計實測一把:

但!又有人指出如果隻顯示一部分時,兩者明明一樣。

暫且不再爭論這個問題,可以肯定的是,“提示詞”的使用方法會對它的判斷造成影響是沒問題的。

另外,網友發現:

如果我們去追問GPT-4V,讓它再仔細確認一下,它也能糾正回答。

至於無法識別遠景圖像的問題,有網友認為這可能是因為GPT-4V隻會從左往右地讀取圖像。

而對於“為什麼有時它會和人類一樣發昏被錯覺誤導、完全不像個智能AI”的疑問,不少人則表示這毫不意外,是訓練問題。

即大模型是根據人類數據、人的反饋、人的註釋進行訓練的,自然會產生和人一樣的錯誤。

因此,還有人戲謔:

看來我們人類創造那麼多科幻作品,描述AI是如何冷酷、完美,但當現在我們真正擁有它時,發現它也不過如此。

(手動狗頭)

你認為該如何讓GPT-4V的錯覺識別能力更強呢?

One More Thing

值得一提的是,我們也測試其中的一些案例。

發現GPT-4V的表現不大一樣,有些題它在“我們這裡”是可以的。

比如這張判斷球顏色的:

還有這個:

盡管把大圖認成老女人而非骷髏,但還是表明它可以“遠觀” 的。