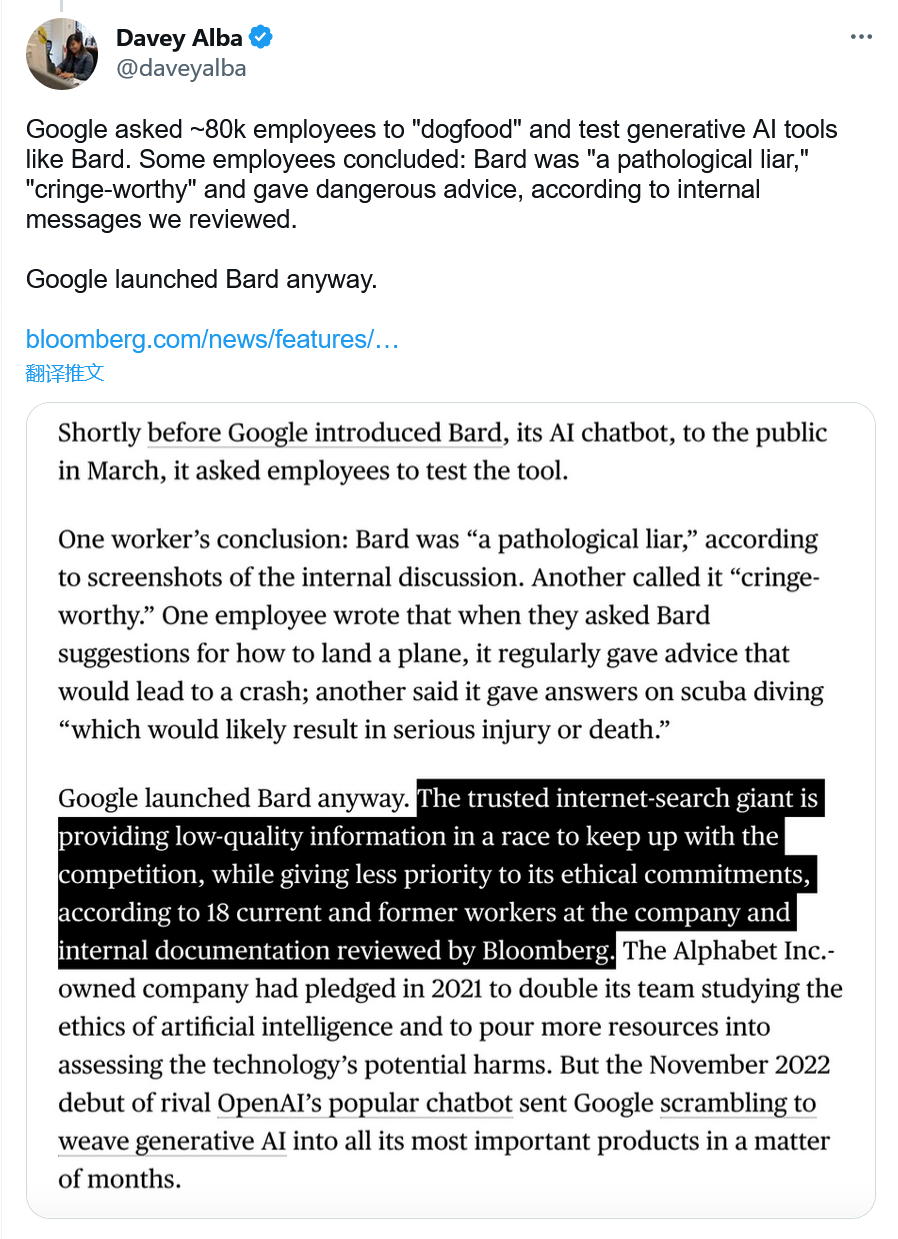

Google員工在內部信息中反復批評該公司的聊天機器人Bard,給該系統貼上"病態說謊者"的標簽,並懇求該公司不要推出該系統。彭博社的一份報道引用與18名現任和前任Google員工的討論,以及內部信息的截圖。

在這些內部討論中,一名員工指出Bard如何經常給用戶提供危險的建議,無論是關於如何降落飛機還是潛水的話題。另一名員工說:"Bard比廢物還糟糕:請不要發佈它。"彭博社說,該公司甚至"否決一個內部安全小組提交的風險評估",說該系統還沒有準備好用於普遍使用。無論如何,Google在3月開放對這個"實驗性"機器人的早期訪問。

彭博社的報告表明,Google為追趕微軟和OpenAI等對手,顯然已經把道德問題放在一邊。該公司經常吹噓其在人工智能方面的安全和道德工作,但長期以來一直被批評為以商業為優先。

2020年底和2021年初,該公司解雇兩名研究人員 - 蒂姆尼特·格佈魯和瑪格麗特·米切爾,因為他們撰寫一篇研究論文,揭露支撐Bard等聊天機器人的人工智能語言系統中的缺陷。不過現在,隨著這些系統威脅到Google的搜索業務模式,該公司似乎更加註重業務而非安全。正如彭博社在引述現任和前任員工的證詞時所說,"這個值得信賴的互聯網搜索巨頭正在提供低質量的信息,以跟上競爭的步伐,同時不太重視其道德承諾。"

Google的其他員工以及更普遍的人工智能開發者會不同意這種觀點。一個常見的論點是,公開測試對於開發和保障這些系統是必要的,而且已知的由聊天機器人造成的傷害是最小的。是的,它們產生有毒的文本,並提供誤導性的信息,但網絡上無數的其他來源也是如此。Google的競爭對手如微軟和OpenAI也可以說是和Google一樣的妥協,唯一不同的是,他們不是搜索業務的領導者,損失更少。

Google的發言人佈萊恩-加佈裡埃爾(Brian Gabriel)告訴彭博社,人工智能道德仍然是該公司的首要任務。"我們正在繼續投資那些致力於將我們的人工智能原則應用於我們的技術的團隊。"

在我們將Bard與微軟的必應聊天機器人和OpenAI的ChatGPT進行比較的測試中,我們發現Google的系統在實用性和準確性方面一直不如其競爭對手。