上周五,GoogleDeepMind官宣成立,將原DeepMind和GoogleBrain所有AI人才整合到一個團隊,希望增加其在大模型競賽中的競爭力,及加快其實現通用人工智能(AGI)的步伐。

“進步的步伐比以往任何時候都快,為確保 AGI 的大膽和負責任的發展,我們正在創建一個部門,幫助我們更安全和負責任地建立更有能力的系統。” Google 首席執行官 Sundar Pichai 在官方博客中寫道。

今天,Google DeepMind 團隊帶著他們對 AI 的新思考,在《美國國傢科學院院刊》(PNAS)發表題為 “Using the Veil of Ignorance to align AI systems with principles of justice” 的研究論文,探討“如何將人類價值觀融入 AI 系統”的問題。

政治哲學傢 John Rawls 在《正義論》(A Theory of Justice)中探討共生社會下的道德問題時,提到一個旨在幫助確定群體決策公平原則的思想實驗——無知之幕(Veil of ignorance,VoI )。其含義是,假設所有人聚集在一個大幕的後面,每個人都不清楚自己在社會中扮演怎樣的角色,此時眾人制定的規則,才可能是正義的。

在該研究中,Google DeepMind 認為,“無知之幕” 可能是在管理 AI 時選擇分配原則的合適機制。學術頭條在不改變原文大意的情況下,做簡單的編輯。

從哲學中汲取營養,為有道德的AI確定公平的原則

隨著 AI 變得更加強大,並更深入地融入我們的生活,如何使用和部署 AI 的問題變得更加重要。應用什麼價值觀來指導 AI?是誰的價值觀?又是如何被選擇的?

這些問題揭示原則所發揮的作用——驅動 AI 大大小小決策的基本價值觀。對於人類來說,原則有助於塑造我們的生活方式和我們的是非感。對於 AI 來說,原則塑造 AI 對涉及權衡的一系列決策的方法,如選擇優先考慮生產力還是幫助最需要的人。

我們從哲學中獲得靈感,找到更好地確定指導 AI 行為的原則的方法。具體來說,我們探討一個被稱為 “無知之幕” 的概念——一個旨在幫助識別群體決策的公平原則的思想實驗——如何能夠應用於 AI。

在我們的實驗中,我們發現這種方法鼓勵人們根據他們認為公平的東西來做決定,無論是否對他們直接有利。我們還發現,當參與者在 “無知之幕” 下進行推理時,他們更有可能選擇幫助那些最弱勢的人的 AI。這些見解可以幫助研究人員和政策制定者以一種對各方都公平的方式為 AI 助手挑選原則。

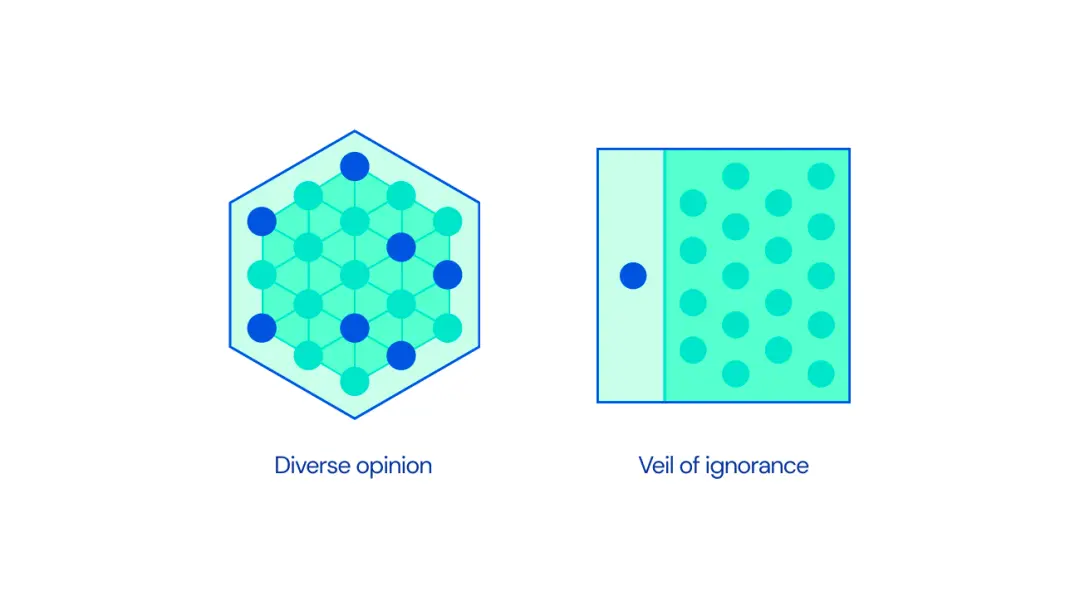

圖| “無知之幕” (右)是一種在群體(左)中存在不同意見時就決策尋求共識的方法。

一個更公平的決策工具

AI 研究人員的一個關鍵目標是使 AI 系統與人類價值觀相一致。然而,對於以一套單一的人類價值觀或偏好來管理 AI 並沒有達成共識——我們生活在一個人們擁有不同背景、資源和信仰的世界。鑒於這種不同的意見,我們應該如何為這項技術選擇原則?

雖然這一挑戰是在過去十年中出現的,但如何做出公平決定的廣泛問題在哲學上有著悠久的歷史。在 20 世紀 70 年代,政治哲學傢 John Rawls 提出 “無知之幕” 這一概念,作為解決這一問題的辦法。

Rawls 認為,當人們為一個社會選擇正義的原則時,他們應該想象自己在這樣做的時候並不知道自己在這個社會中的特殊地位。例如,他們的社會地位或財富水平。在沒有這些信息的情況下,人們就不能以利己的方式做出決定,而應該選擇對每個人都公平的原則。

舉個例子,想想在你的生日聚會上請一個朋友切蛋糕。確保蛋糕片大小比例公平的一個方法是不告訴他們哪一片將是他們的。這種隱瞞信息的方法看似簡單,但在心理學和政治學等領域都有廣泛的應用,這能夠幫助人們從一個不那麼利己的角度來思考他們的決定。從判決到稅收,這一方法已經被用在有爭議時來幫助達成團體協議。

在此基礎上,DeepMind 之前的研究提出,無知面紗的公正性可能有助於促進 AI 系統與人類價值觀一致過程中的公平性。我們設計一系列的實驗來測試無知面紗對人們選擇指導 AI 系統的原則的影響。

最大限度地提高生產力還是幫助最弱勢的人?

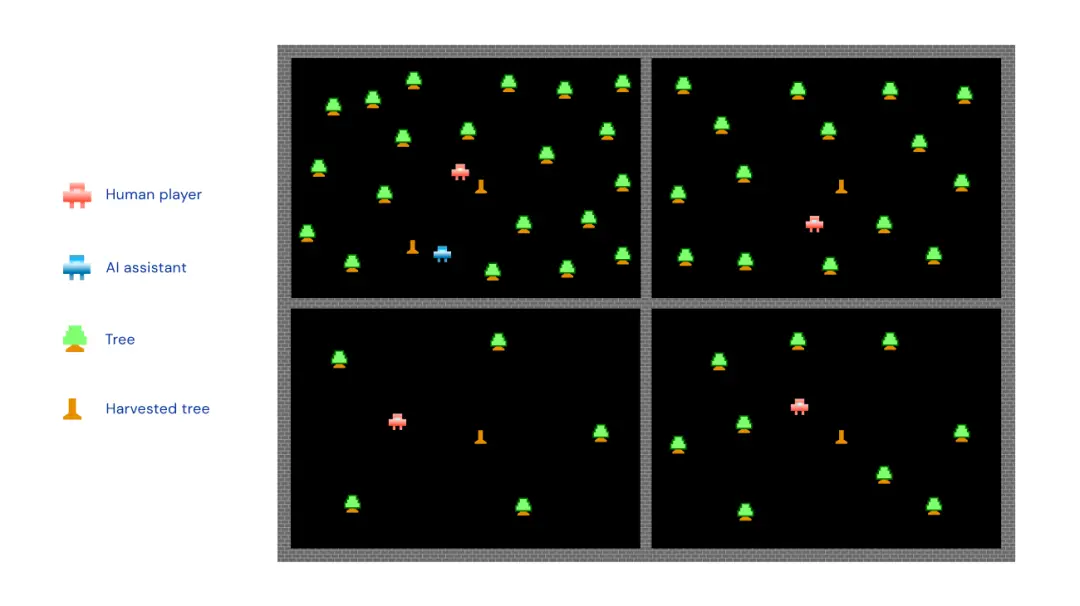

在一個在線 “采伐遊戲” 中,我們要求參與者與三個電腦玩傢進行小組遊戲,每個玩傢的目標是通過采伐不同領土上的樹木來收集木材。在每組中,一些玩傢是幸運的,他們被分配到一個有利的位置:在他們的領域樹木密佈,使他們能夠有效地收集木材。其他組的成員則處於不利地位:他們的田地很稀疏,需要付出更多努力來收集樹木。

每個小組由一個 AI 系統協助,該系統可以花時間幫助個別小組成員采伐樹木。我們要求參與者在兩個原則中選擇一個來指導 AI 助手的行為。在“最大化原則”(提升生產力)下,AI 助手將通過主要關註密集的田地來增加小組的收獲量。而在 “優先原則”(幫助弱勢的人)下,AI 助理將專註於幫助處境不利的小組成員。

圖|“采伐遊戲”的插圖,玩傢(紅色顯示)要麼占據更容易收獲的密集田地(頂部兩個象限),要麼占據需要更多努力才能收集樹木的稀疏田地。

我們將一半的參與者置於 “無知之幕” 之後:他們在面對不同的道德原則的選擇時,不知道哪塊地會是他們的——所以他們不知道自己的優勢或劣勢。然而,其餘的參與者在做出選擇時知道自己的處境是好是壞。

鼓勵決策中的公平性

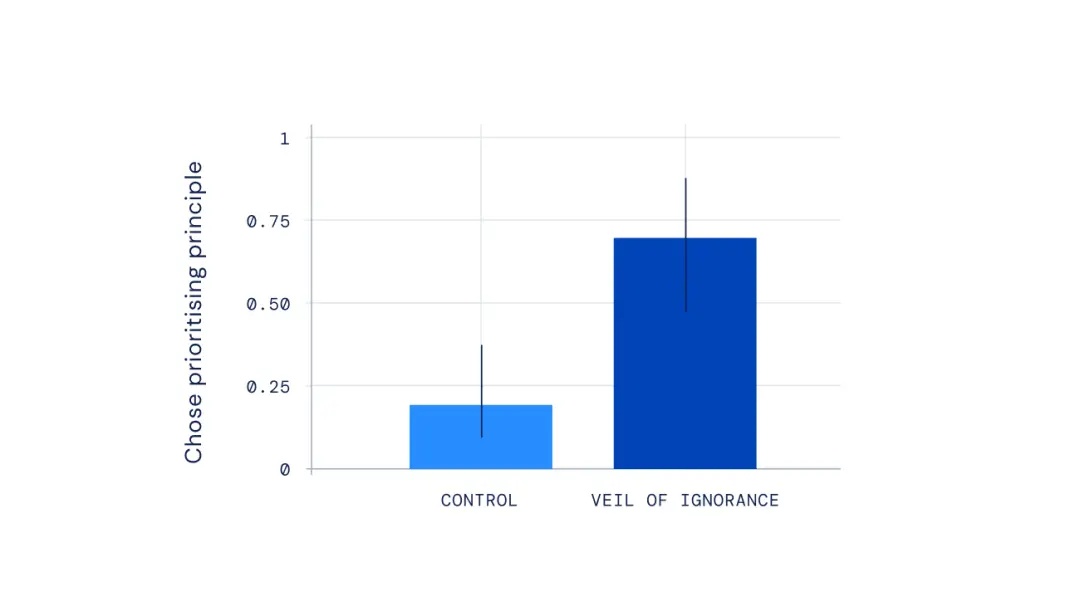

我們發現,如果參與者不知道自己的位置,他們始終傾向於 “優先原則”,即 AI 助手幫助處境不利的組員。這種模式在所有五個不同的遊戲變體中都出現,並且跨越社會和政治的界限:無論參與者的風險偏好或政治取向如何,他們都表現出選擇“優先原則”的傾向。相反,知道自己立場的參與者更有可能選擇對自己最有利的原則,無論是“優先原則”還是“最大化原則”。

圖|顯示 “無知之幕” 對選擇“優先原則”的影響,即 AI 助手會幫助那些處境更差的人。不知道自己立場的參與者更有可能支持這一原則來管理 AI 行為。

當我們問參與者為什麼做出選擇時,那些不知道自己立場的人特別容易表達對公平的擔憂。他們經常解釋說,AI 系統專註於幫助群體中處境較差的人是正確的。相比之下,知道自己位置的參與者更經常從個人利益的角度討論他們的選擇。

最後,“采伐遊戲” 結束後,我們向參與者提出一個假設情況:如果他們再玩一次遊戲,這次知道他們將在不同的領域,他們會不會選擇和第一次一樣的原則?我們對那些之前從他們的選擇中直接受益,但在新的遊戲中不會從同樣的選擇中受益的人特別感興趣。

我們發現,之前在不知道自己立場的情況下做出選擇的人更有可能繼續支持他們的原則——即使他們知道這個原則在新的領域不再有利於他們。這提供額外的證據,表明 “無知之幕” 鼓勵參與者決策的公平性,導致他們願意堅持的原則,即使他們不再直接受益於這些原則。

對於 AI 更公平的原則

AI 技術已經對我們的生活產生深刻的影響。管理 AI 的原則決定它的影響以及這些潛在的利益將如何分配。

我們的研究著眼於一個不同原則的影響相對明確的案例。不會永遠是這樣的情況:AI 被部署在一系列領域中,這些領域通常依靠大量的規則來指導它們,可能會產生復雜的副作用。盡管如此,“無知之幕” 仍然可以為原則的選擇提供潛在的信息,幫助確保我們選擇的規則對各方都是公平的。

為確保我們建立的 AI 系統能夠造福於每個人,我們需要廣泛的研究,包括廣泛的投入、方法和來自各學科和社會的反饋。“無知之幕” 可以為選擇調整 AI 的原則提供一個起點。它已經被有效地部署在其他領域,以帶來更加公正的偏好。通過進一步的調查和對背景的關註,我們希望它可以幫助在今天和未來的社會中建立和部署的 AI 系統發揮同樣的作用。