一傢來自紐約的初創公司HumeAI發佈一款標榜為“第一個具有情商的對話式人工智能”的共情語音接口(EVI),並表示其能夠從用戶那裡檢測到53種不同的情緒。AI的下一個重大突破是理解情感嗎?HumeAI表示是的。3月27日,一傢名為HumeAI的新創公司宣佈,他們已經在一輪B輪融資中籌集5000萬美元。

這傢初創公司由前Google DeepMind研究員Alan Cowen共同創立並擔任CEO。

Hume AI與其他人工智能模型提供商和初創公司的區別在於,它專註於創建一款能夠理解人類情感、適當做出反應並向用戶傳達情感的人工智能助手。

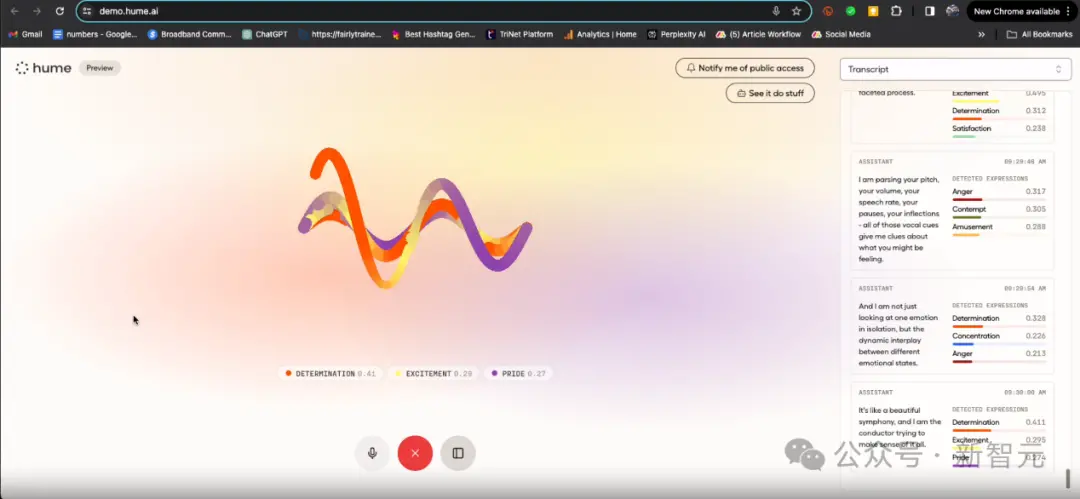

這款聊天機器人不僅基於文本,還使用語音對話作為其接口,通過聽取人類用戶的語調、音高、停頓等聲音特征來運作。

Hume AI同時發佈其名為“共情語音界面”(Empathic Voice Interface)的演示,隻需要使用帶有麥克風的設備,就可以與之進行互動。

為什麼AI需要理解情感

Hume AI的理論是,通過開發能夠更細致地理解和表達人類情感的AI模型,它可以更好地為服務用戶。

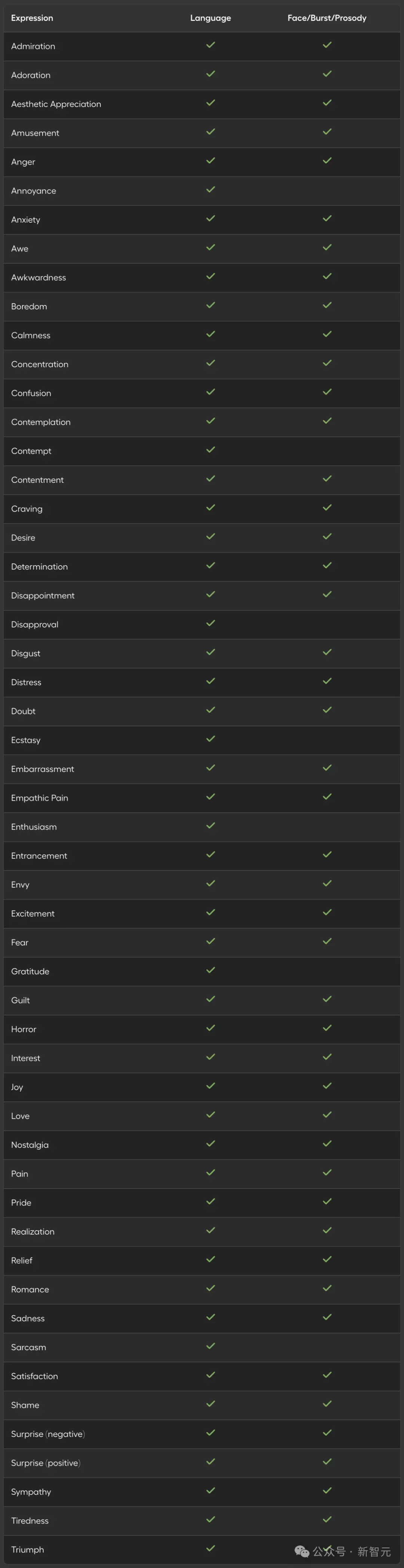

Hume AI不僅僅想要解用戶“快樂”、“悲傷”、“憤怒”、“害怕”等等通用的人類情緒,而是更微妙、通常是多維的情緒。

比如“欽佩”,“崇拜”,“入迷”,“諷刺”,“羞恥”等等,Hume AI在其網站上總共列出53種不同的情緒。

官網地址:https://dev.hume.ai/docs/expression-measurement-api/overview(上下滑動查看全部)

對此,Hume AI表示:

情感智能包括從行為中推斷意圖和偏好的能力。這正是AI界面試圖實現的核心目標:推斷用戶想要什麼並實現它。因此,在某種意義上,情感智能是AI界面的最重要的要求。

通過語音AI,你可以獲得更多關於用戶意圖和偏好的線索。

這使得我們的AI在預測人類偏好和結果、知道何時說話、知道該說什麼以及如何以正確的語氣說話方面變得更加出色。

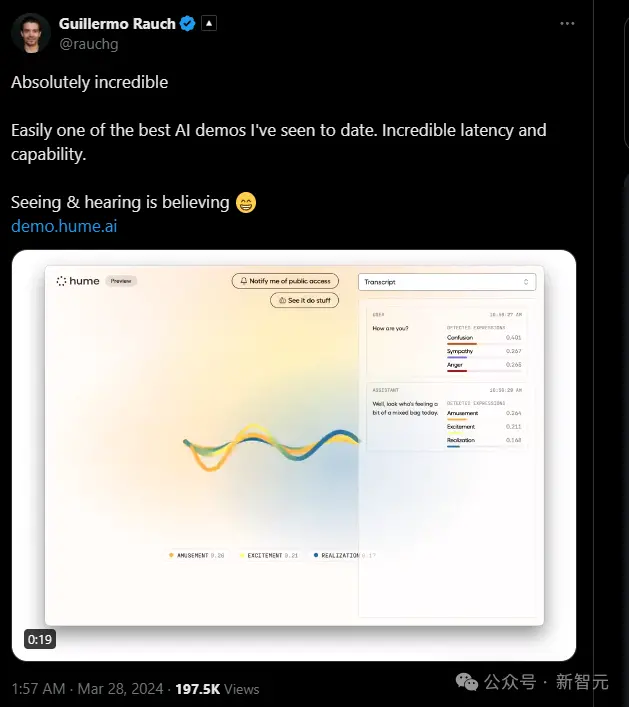

Hume AI演示之後,反響十分狂熱。

雲端和Web應用開發軟件公司Vercel的首席執行官Guillermo Rauch就發帖稱:“這是迄今為止我見過的最好的人工智能演示之一。”

如何從語音變化中檢測情緒

在其網站上,Hume指出:“這些模型是基於大規模、實驗控制的情感表達數據的人類強度評分上進行訓練的。”

這些數據來源於Cowen及其同事發表的兩篇科學研究論文:“Deep learning reveals what vocal bursts express in different cultures”和“Deep learning reveals what facial expressions mean to people in different cultures”。

第一項研究包括來自美國、中國、印度、南非和委內瑞拉的16,000名參與者,有意思的是,數據集裡面還有一部分是用來記錄“語音爆發”或非詞匯聲音,如笑聲和“嗯嗯”等。

第二項研究包括來自上述五個國傢以及埃塞俄比亞的5,833名參與者,他們在計算機上進行一項調查,在調查中他們分析來自4,659個面部表情數據庫的高達30個不同的“種子圖像”。

參與者被要求模仿他們在電腦上看到的面部表情,並從一個包含48種情緒的列表中,按照1-100的強度進行評定。

在互動中,Hume AI的EVI說道,Hume的團隊“收集有史以來最大、最多樣化的人類情感表達庫。我們談論的是來自世界各地的一百多萬參與者,參與各種各樣的現實生活互動。”

Hume AI利用這兩項研究的照片和參與者的音頻數據訓練自己的深度神經網絡。

這些數據還用於創建一個“語音韻律模型”(speech prosody model),用於測量語音的調子、節奏和音色,並整合到EVI中。

情感AI的應用和約束

Hume AI提供其EVI的API,允許用戶根據其獨特的數據集訓練自己的Hume AI模型。

同時還提供“表達測量API”(Expression Measurement API), 企業客戶可以使用該API構建應用程序。

在表達測量API中可以訪問的其他屬性包括理解面部表情、語音爆發和情感語言——後者測量“轉錄文本的情感語調,包括53個維度”。

EVI可以作為任何應用的界面。開發人員可以使用Hume AI的API構建個人AI助手、代理和可穿戴設備等等,產品可涵蓋從AI助手到健康管理、從教學輔導到客戶服務等各個領域。

但同時,人們可能會對Hume的EVI產生依賴或以一種不健康的方式沉迷於它的潛力,該技術也可能會被用於一些不好的用途,比如操縱、欺詐等等。

在直接被問及此可能性時,考恩提供以下聲明:

當人工智能利用我們的情感行為來達到某些目標(比如促進購買、提高參與度或培養習慣)時,它可能會學會操縱和利用我們的情感。

因此,開發人員應該將解用戶情感行為視為人工智能本身的目標,而不是將這些行為僅僅當作達到第三方目標的手段。

算法用於檢測情感線索應該服務於用戶健康和福祉的目標,包括對異常情況做出適當反應、保護用戶免受濫用,並促進用戶的情感認知和自主性。

該網站還包括一系列“不支持的用例”,例如操縱、欺騙、“優化減少幸福感”(如“心理戰爭或折磨”)以及“無限制的共情人工智能”。

但這不過泛泛而談,當AI真的有情感之後,如何用倫理、用法律去約束,人類還有很長的路要去探索。