Deepfake人工智能系統最險惡的功能之一是能夠復制一個人的聲音,即使隻是一段簡短的錄音。人們聲音的深度偽造版本以及偽造的視頻可以用來使其聽起來和看起來好像政客或名人說一些他們實際上從未說過的話。此外,還有一些情況是,人們接到詐騙電話,其中朋友或傢人的深度偽造聲音要求他們因某種緊急情況盡快匯款。此外,復制的聲音可用於繞過語音識別安全系統。

然而,一種名為 AntiFake 的新軟件工具可以幫助防止這種情況發生。

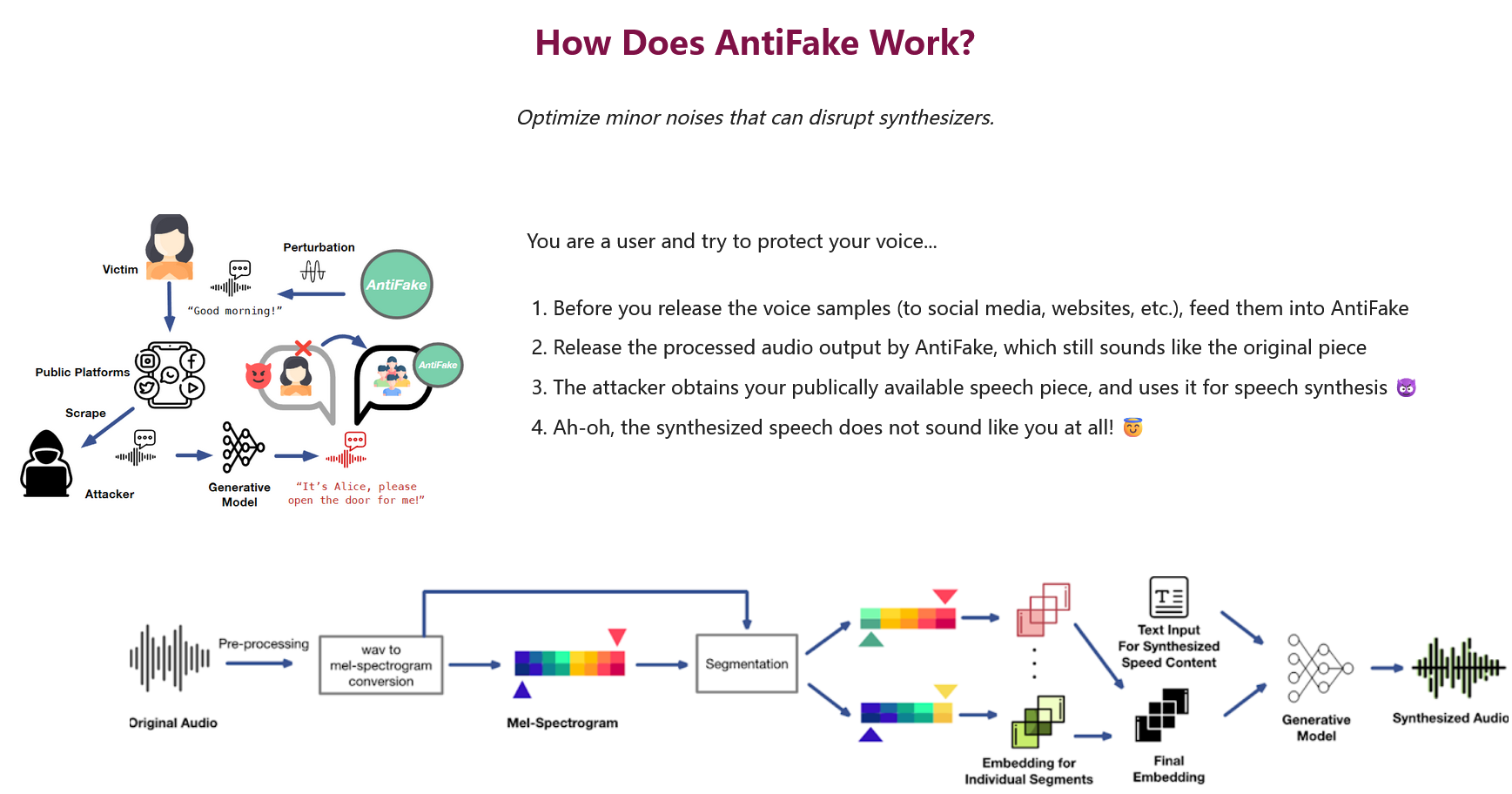

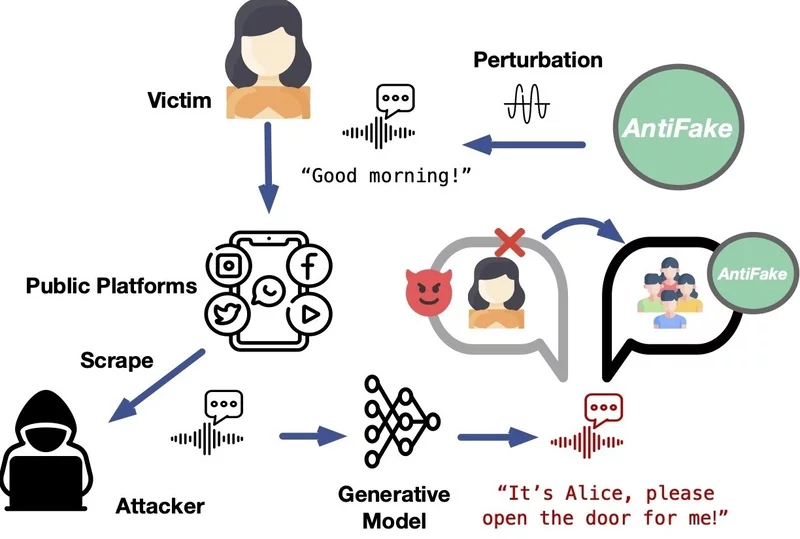

已經有技術可以確定所謂的聲音是否是深度偽造的,AntiFake 是最早阻止此類偽造聲音產生的系統之一。 簡而言之,它是通過讓人工智能系統更難讀取真人聲音錄音中的關鍵聲音特征來實現這一點。

“該工具使用一種對抗性人工智能技術,該技術最初是網絡犯罪分子工具箱的一部分,但現在我們反過來用它來防禦他們,”發明者、聖路易斯華盛頓大學計算機科學與工程助理教授張寧說。

“我們隻是稍微弄亂錄制的音頻信號,對其進行扭曲或擾動,使其對人類聽眾來說仍然聽起來不錯,但這與人工智能感知到的完全不同。”

這意味著,即使深度偽造是根據經過 AntiFake 修改的錄音創建的,它聽起來也不會像說話者的實際聲音。 迄今為止進行的測試表明,該技術在防止合成令人信服的深度贗品方面的有效性超過 95%。

張說:“雖然我不知道人工智能語音技術的下一步會是什麼——新的工具和功能一直在開發——但我確實認為我們利用對手的技術來對抗他們的策略將繼續有效。”

任何需要的人都可以免費獲得防偽代碼:

https://sites.google.com/view/yu2023antifake