也許你還記得,在去年六月,有一群中國人利用特效換臉,開始假裝俄羅斯人帶貨。從室內到戶外,從城市到農村,他們活躍在在每片能支棱起手機拍視頻開直播的土地上,操著一口帶有濃鬱方言味的普通話,在商品櫥窗裡上鏈接。他們的視頻和直播裡,沒有什麼狠活。總結起來就一句話,“我,俄羅斯人,喜歡中國,打錢”。

我本以為,隨著那篇報道的結束,中國人假冒毛子的故事就告一段落。

但我萬萬沒想到,在 2024 年,這個套路他 360 度大升級。

具體是咋回事呢?

這兩天,一個叫 Olga Loiek 的烏克蘭女孩發條視頻,說有個朋友給她發個鏈接,自己一看,人都傻。

好傢夥,我怎麼在中國咔咔帶上貨??

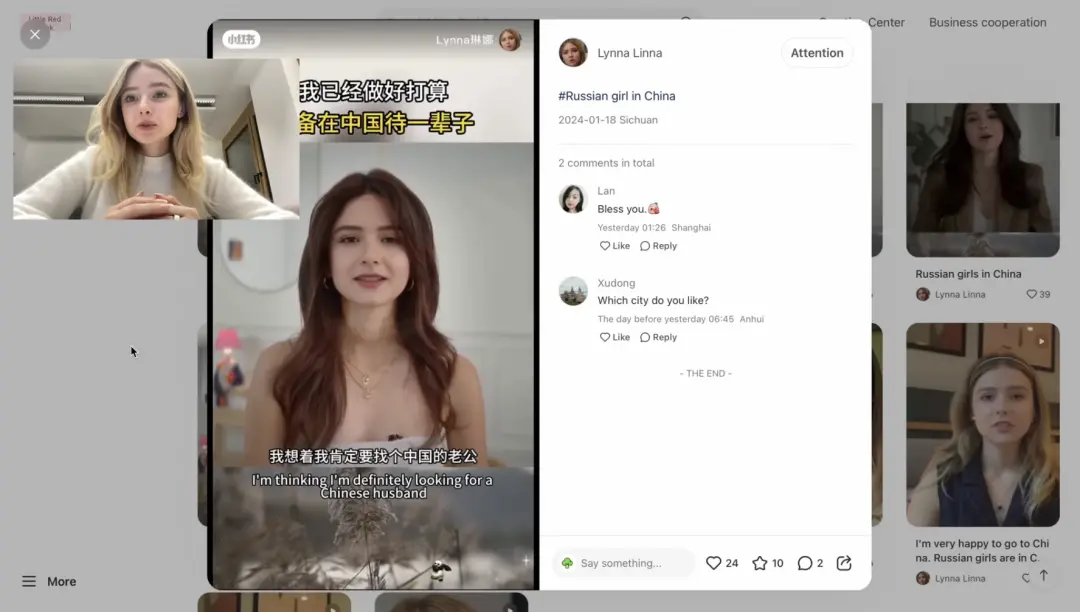

原來在小紅書上,有這樣一類賬號,天天就是一個長相完全一致的金發美女,變著法的講中俄友誼長存,三句離不開謝謝中國。視頻結尾,還會給你介紹下俄羅斯的美食。

而看視頻的老鐵們,自然也要照顧下大妹子的生意。

是的,成百上千萬中國觀眾看到的這張侃侃而談的 “ 臉龐 ” ,就是 Olga Loiek 。

反觀 Olga ,自己還沒在 YouTube 上賺到半毛錢呢。

而且更尷尬的是,臉被別人偷去用來帶貨不說,作為一個烏克蘭人,人設還是個俄羅斯人,帶得還都是人俄羅斯的土特產……這找誰說理去。

如果你沒法和這個女孩共情,不妨可以設想一下,一個美國人頂著你的臉,假裝自己是日本人,變著法吹日本。

然後他還利用你的臉,從其他美國人手裡,賺你這輩子都不一定能賺到的錢,在視頻評論區裡,觀眾們刷的都是 “ 你好日本,愛來自美國 ” 。

你氣不氣?

Olga Loiek 也不是唯一一個倒黴蛋,另一位來自瑞典的網紅拉納佈萊克利的臉,也被移花接木到中國人臉上。

在視頻裡, “ 她 ” 大談中國人的勤勞善良,並且嫁給中國老公,餘生在中國定居。

看完視頻的網友也不知道自己成即將被噶的韭菜,還在問她喜歡中國哪個城市。

在抽查幾個被 Olga Loiek 展示的賬號之後,我發現這些假冒外國人的中國賬號,有些已經在各大平臺註銷掉,但還有一些依舊逍遙法外。

可世上隻有千日做賊,哪有千日防賊。

AI 技術的發展速度,明顯比人類目前的應對速度要快。

在一年前, AI 技術還是被網友嘲笑的對象,網友看也隻會覺得這輩子的恐怖谷效應都犯完。

然而現在, AI 技術已經可以產生以假亂真的效果。

變化總是在悄無聲息中進行,在 AI 技術日漸進步的今天,眼睛和耳朵,正在逐漸失去辨別能力。

人的知覺,正在信息時代的沖擊下 “ 被退化 ” 。

看到這,估計很多差友會覺得這些事都離自己太遠,比如那個假冒的烏克蘭女孩,懂行的一看就知道,完全騙不到自己啊?

那你再試試這個呢?

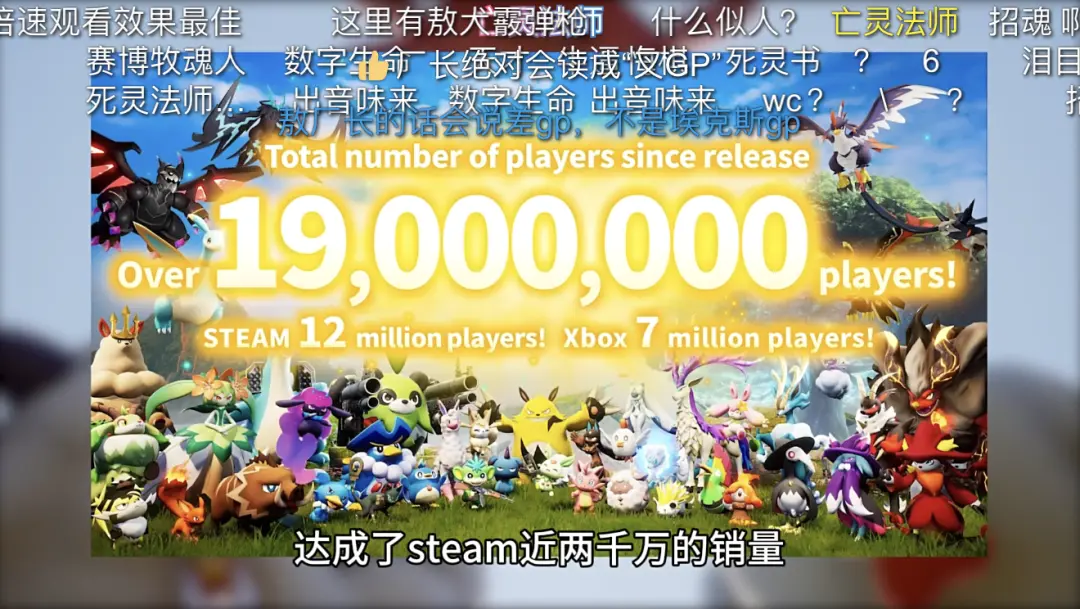

如果你比較關註遊戲雜談,那你可能還記得一個叫做敖廠長的視頻博主,他因為幾波輿論潮,基本敗完自己的口碑。

在去年,他先後停止 B 站和抖音的更新,悄無聲息的從網友的關註列表裡消失。

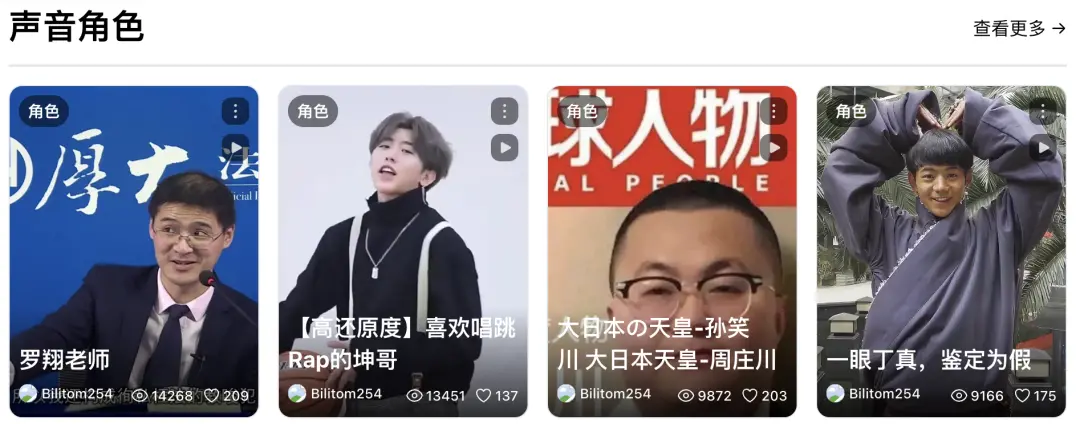

可就在前兩天,一位 B 站 UP 主用自研 AI 文本轉語音技術,搭配上他原有的文案和剪輯風格,愣是復刻一整個 UP 主敖廠長出來,給我看恍惚。

彈幕裡都在刷 “ 亡靈法師 ”“ 招魂成功 ” 。

在這個 UP 主頁貼出的網址中,還能找到更多奇奇怪怪的 AI 音聲,比如丁真、科比、孫笑川,以及一些知道這個網站八成要發律師函的明星們。

那麼,使用 AI 生成一個人的音聲,要搜集多少真人的聲音呢?

UP 主在視頻介紹中,給出的答案是:5 秒。

沒錯,你隻要說 5 秒鐘的話,你的聲音就可能已經被克隆。

如果以上的技術,能夠用在發展生產力,推動社會進步上,那勉強還能算是最好的結局。

但你要知道,現在的 AI 技術,已經越來越下沉。

第一天出個厲害的 AI 軟件,第二天使用教程就有博主給你發抖音,簡直就是手把手教學,從入坑到精通給你安排的明明白白。

不可否認,這是一件好事,可它也把人心底的陰暗面一點點放大,最後形成公共事件。

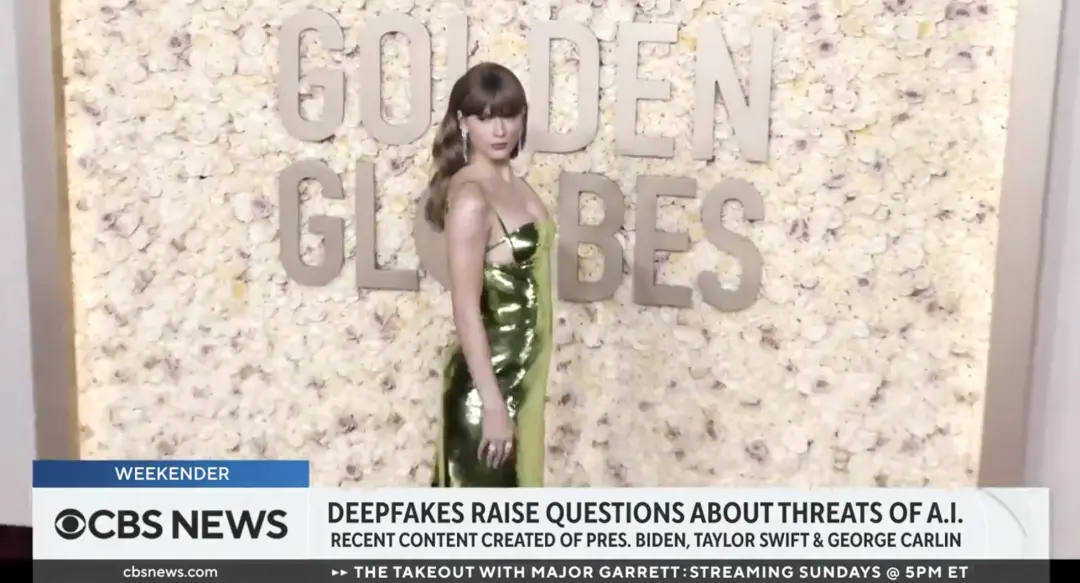

前幾天, AI 生成的泰勒斯威夫特虛假不雅照片,在整個網絡上瘋傳,甚至驚動美國白宮。

白宮新聞發言人卡裡娜 · 讓 - 皮埃爾警告 AI 生成照片的傳播 “ 令人擔憂 ” ,並敦促社交媒體公司防止此類錯誤信息的傳播。

泰勒這事為啥這麼爆炸?畢竟早在 PS 時代,就有很多女性飽受換臉的困擾對吧?

但在 AI 時代,照片裡的所有細節都可以被精心定制。

泰勒這次,就是因為交一個橄欖球星男朋友,被生成出在橄欖球更衣室裡的照片……

換誰不急眼?

後來也是由於類似的圖片過多,Twitter一度封鎖對斯威夫特的相關搜索。

為什麼全美國因為這事都開始變得神經兮兮,因為大傢都清楚,今天是泰勒,明天可能就是自己。

而且 AI 幹的壞事,也不隻是下三路,它的能量比你想的龐大。

在中國香港,發生過一起 AI“ 深度偽造 ” 詐騙案。

詐騙者就是通過 AI 技術,把網上搜集到的跨國公司總部高層的聲音和面貌,替換到自己身上,然後,簡簡單單從該公司的香港分公司騙走 2 億港元,甚至,公司財務連老板的人臉和聲音都沒看出來有啥異常。

你以為 AI 也就到這種程度嗎?

別忘, 2022 年,烏克蘭總統澤連斯基 “ 呼籲烏克蘭士兵放下武器投降 ” 的視頻在網上傳播。

這條十分整蠱的視頻,逼到烏克蘭國防部都要站出來聲明 “ 這是不可能的 ” 。

由此可見,從個人到團體,甚至是國傢之間的戰爭,每個能鉆的空子,都成為 AI 的突破口。

更可怕是,到目前為止,還沒有一個特別好的招兒能防讓住人用 AI 幹壞事。

網絡安全業內人士,i春秋的朋友小傲( 化名 )就告訴世超,反 AI 犯罪的難點主要有兩方面,一個是技術層面,一個是經濟層面。

在技術層面上, AI 生成內容的識別難度大,特別是 AI 越發展,肉眼能識別出來的概率也越小,這種時候就隻能上機器。

而在經濟層面上,用 AI 來犯罪並不是難事也不需要花什麼錢,但用 AI 來反 AI 的成本就高,你得砸錢出力去搞研究。

現階段,國內外有不少監管機構和公司在想法子拴住 AI ,去年公安部就端個用 AI 寫勒索病毒的團夥。

市面上,也有不少檢測 AI 生成內容的工具,但效果還不好說。

像 OpenAI 之前就推出過一款文本檢測工具,但因為檢測錯誤率太高偷偷給下架……

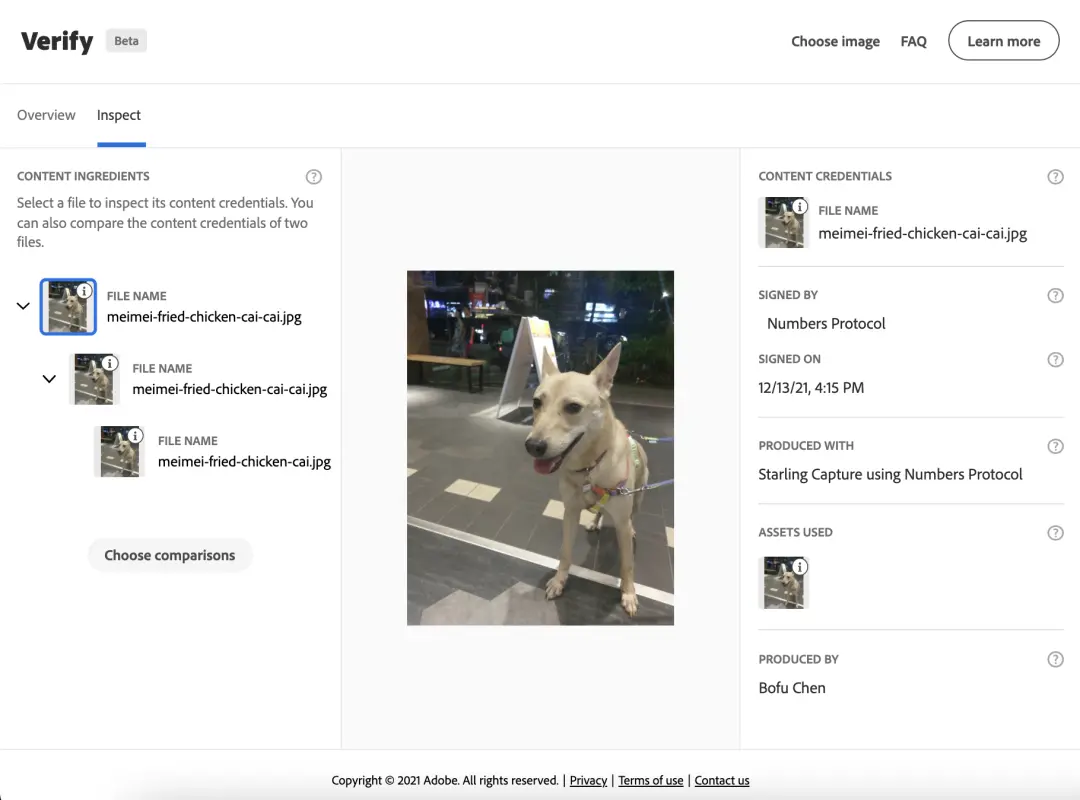

兩年前,微軟還有 BBC 等幾傢科技公司和媒體一起合作,成立個內容來源和真實性聯盟 ( C2PA ) 。

有 C2PA 協議之後,內容是誰創作的,歷史的修改記錄,都會被記錄下來。就相當於給生成的內容,打上一層看不見的水印。

但用小傲的話來說, C2PA 這玩意屬於防君子不防小人,大廠守規矩,不代表很多開源調出來的小模型,也會遵守協議。

而且, C2PA 現在還有不少 Bug ,像一截圖水印就沒,要生效也得好幾個平臺都使用協議才行。

所以很殘酷的一個現實是,現階段咱們沒法兒杜絕 AI 幹壞事。

關鍵在於, AI 技術發展得實在是太快, AI 生成的內容越來越逼真,生成的門檻卻越來越低,就像 Sora 問世後,大傢都在說 “ 現實,不存在 ” 。

不可否認,之後的立法、反 AI 技術肯定會跟上,但這種敵在暗我在明的情況,監管就很被動。

這就像一場貓鼠遊戲, AI 知道規則就會繞過去,人類再設置新的規則,這場遊戲,或許永無止境。

我們能做的,除多加分辨,就隻剩下下載國傢反詐中心 App 。