資深機器人專傢EricJang不久前曾預言:“ChatGPT曾在一夜之間出現。我認為,有智慧的機器人技術也將如此。”他或許說對。北京時間3月13日深夜,一段人形機器人的視頻開始在X上熱傳。之前從未展示過機器人方向能力的OpenAI,在與投資公司的人形機器人的合作中,第一次展示自己的機器人智能能力。

Figure,OpenAI 投資的機器人公司,上傳這段視頻。在視頻中,Figure 的人形機器人,可以完全與人類流暢對話,理解人類的意圖,同時還能理解人的自然語言指令進行抓取和放置,並解釋自己為什麼這麼做。

而其背後,就是 OpenAI 為其配置的智能大腦。

在過去一年的具身智能進展中,或許你曾經看過類似的機器人自主決策、拿取物品的展示,但在這段視頻中,Figure 人形機器人的對話流暢度、展現出的智能感,接近人類操作速度的動作流暢性,絕對都是第一流的。

Figure 還特意強調,整段視頻沒有任何加速,也沒有任何剪輯,是一鏡到底拍攝的。同時,機器人是在完全自主的情況下進行的行為,沒有任何遠程操縱——似乎在暗暗諷刺前段時間爆火的展現酷炫機械能力,但是沒有太多智能程度的斯坦福炒菜機器人。

比起機器人的智能表現,更可怖的是,這隻是 OpenAI 小試牛刀的結果——從 OpenAI 宣佈與 Figure 共同合作推進人形機器人領域的前沿,到這個視頻的發佈,隻有短短的十三天。

此次 Figure 人形機器人背後的智能,來自端到端的大語言-視覺模型,這是具身智能領域目前非常前沿的領域。去年極客公園報道過Google在類似領域的進展。Google做出的端到端機器人控制模型,被一些行業內的人士,譽為機器人大模型的 GPT-3 時刻。

而當時,Google的機器人模型,還隻能根據對話來做一些抓取,並不能與人類對話,也不能向人類解釋自己為什麼會這麼做。而Google自身,從 Everyday Robotics 開始,已經有五年以上的機器人研究經驗。

而 Figure 本身,成立於 2022 年。從OpenAI 宣佈介入與之合作,到今天它們共同推出一個能夠自主對話和決策的機器人,隻有 13 天。

機器人智能的發展,顯然正在加速。

01. 端到端大模型驅動,機器人的速度已經接近人類速度

Figure 的創始人 Brett Adcock 和 AI 團隊的負責人 Corey Lynch 在 X 上解釋此次視頻中機器人互動背後的原理。

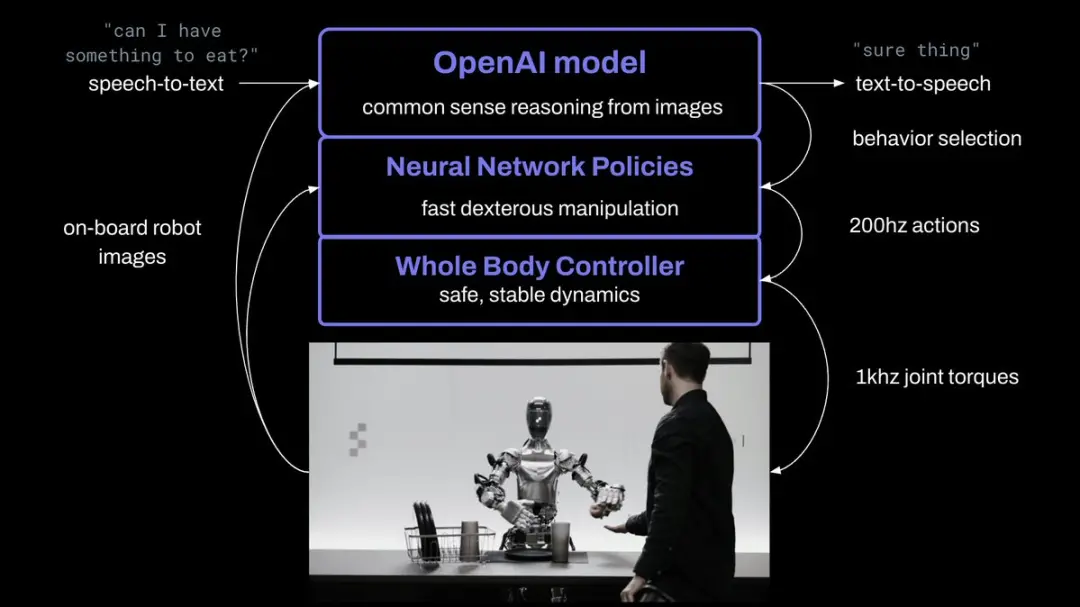

此次的突破,由 OpenAI 與 Figure 共同做出。OpenAI 提供負責提供視覺推理和語言理解,而 Figure 的神經網絡提供快速、低水平、靈巧的機器人動作。

機器人所做出的所有行為都是出於已經學習過,內化的能力,而不是來自遠程操作。

研究人員將機器人攝像頭中的圖像輸入,和機載麥克風捕獲的語音中的文本轉錄到由 OpenAI 訓練的,可以理解圖像和文本的多模態模型(VLM)中,由該模型處理對話的整個歷史記錄,得出語言響應,然後通過文本到語音的方式將其回復給人類。

同樣的模型,也負責決定在機器人上運行哪些學習的閉環行為來完成給定的命令,將特定的神經網絡權重加載到 GPU 上並執行策略。

這也是為什麼這個機器人,屬於“端到端”的機器人控制。從語言輸入開始,模型接管一切處理,直接輸出語言和行為結果,而不是中間輸出一些結果,再加載其他程序處理這些結果。

Figure 的機載攝像頭以 10hz 的頻率拍攝圖像,然後神經網絡以 200hz 輸出 24 個自由度動作。

Figure 的創始人提到,這代表機器人的速度已經有顯著提高,開始接近人類的速度。

Corey Lynch 的 X

OpenAI 的模型的多模態能力,是機器人可以與世界交互的關鍵,我們能夠從視頻中展示中看到許多類似的瞬間,比如:

描述一下它的周圍環境。

做出決定時使用常識推理。例如,“桌子上的盤子和杯子等餐具接下來很可能會進入晾衣架”。

將“我餓”等模棱兩可的高級請求轉化為一些適合上下文的行為,例如“遞給對方一個蘋果”。

用簡單的英語描述*為什麼*它會執行特定的操作。例如,“這是我可以從桌子上為您提供的唯一可食用的物品”。

而模型能力的強大,使其還能夠擁有短期記憶,比如視頻中展示的“你能把它們放在那裡嗎?”“它們”指的是什麼?“那裡”又在哪裡?正確回答需要反思記憶的能力。

而具體的雙手動作,可以分成兩步來理解:

首先,互聯網預訓練模型對圖像和文本進行常識推理,以得出高級計劃。如視頻中展示的:Figure 的人形機器人快速形成兩個計劃:1)將杯子放在碗碟架上,2)將盤子放在碗碟架上。

其次,大模型以 200hz 的頻率生成的 24-DOF 動作(手腕姿勢和手指關節角度),充當高速“設定點(setpoint)”,供更高速率的全身控制器跟蹤。全身控制器確保安全、穩定的動力,如保持平衡。

所有行為均由神經網絡視覺運動 Transformer 策略驅動,將像素直接映射到動作。

02.從 ChatGPT 到 Sora,再到機器人,OpenAI 想包攬“智能”這件事

2021 年夏天,OpenAI 悄悄關閉其機器人團隊,當時,OpenAI 曾宣佈無限期終止對機器人領域的探索,原因是缺乏訓練機器人使用人工智能移動和推理所需的數據,導致研發受到阻礙。

但顯然,OpenAI 並沒有放下對這個領域的關註。

2023 年 3 月,正在一年前,極客公園報道 OpenAI 投資來自挪威的機器人制造商 1X Technologies。其副總裁正是我在文初提到的,認為具身智能將會突然到來的 Eric Jang。

而無獨有偶,1X Technologies 的技術方向,也是端到端的神經網絡對於機器人的控制。

而今年 3 月初,OpenAI 和其他投資人一起,參與 Figure 的 B 輪融資,使其成立兩年,就達到 26 億美金估值。

也正是在這一輪融資之後,OpenAI 宣佈與 Figure 的合作。

Figure 的創始人 Brett Adcock,是個“擅長組局”的連續創業者,整個職業生涯中創立過至少 7 傢公司,其中一傢以 27 億美元的估值上市,一傢被 1.1 億美元的價格收購。

創建公司後,他招募到研究科學傢 Jerry Pratt 擔任首席技術官,前波士頓動力/蘋果工程師 Michael Rose 擔任機器人控制主管。此次進行分享的 AI 團隊負責人 Corey Lynch,則原本是 Google Deepmind 的 AI 研究員。

Figure 宣佈自己在電機、固件、熱量、電子產品、中間件操作系統、電池系統、執行器傳感器、機械與結構方面,都招募硬核的設計人才。

公司的確進展很快。在與 OpenAI 合作之前,已經做出不少成績。2024 年 1 月,Figure 01(Figure 的第一款人形機器人) 學會做咖啡,公司稱,這背後引入端到端神經網絡,機器人學會自己糾正錯誤,訓練時長為 10 小時。

Figure 01 引入 AI 學會做咖啡

2 月,公司對外展示 Figure 01 的最新進展,在視頻裡,這個機器人已經學會搬箱子,並運送到傳送帶上,但速度隻有人類的 16.7%。

甚至在商業化上,也已經邁出第一步:Figure 宣佈與寶馬制造公司簽署商業協議,將 AI 和機器人技術整合到汽車生產中,部署在寶馬位於南卡羅來納州斯巴達堡的制造工廠。

而在今天的視頻展示推文中,Figure 宣佈其目標是訓練一個世界模型,最終能夠賣出十億個級別的模型驅動的人形機器人。

不過,盡管OpenAI與 Figure的合作進展順暢,但看起來 OpenAI 並未把寶壓在一傢機器人公司。

北京時間 3 月 13 日,來自Google研究團隊、加州大學伯克利分校、斯坦福大學教授等一群研究者新成立的一傢機器人 AI 公司 Physical Intelligence,被彭博社爆料也拿到 OpenAI 的融資。

毫無意外,該公司,也是研究未來能夠成為通用機器人系統的人工智能。

多頭下註機器人領域,13 天合作做出領先的機器人大模型,OpenAI 在機器人領域意圖為何,引人關註。

智能人形機器人,未來不止看馬斯克的。