近年來,人工智能(AI)技術在科學研究領域中的應用與影響日益顯著。從生物醫學、材料學、到天文學等學科,AI4Science正改變著科學研究的方式,加速科學研究。AI通過提供大規模數據分析、模擬實驗環境、優化研究過程等功能,為科學傢們提供前所未有的支持和幫助,也確實將科學研究推向一個新的階段。

然而,AI 在為科研帶來更多可能性的同時,也引發許多問題。

來自耶魯大學和普林斯頓大學的研究團隊認為,在科學研究中,AI 可能會造成知識生產的單一性,即科學的單一文化(scientific monocultures)。

具體來說,在這種文化中,某些類型的方法、問題和觀點主導其他方法,使科學缺乏創新性,更容易出錯。

同時,AI 提出的解決方案也可能掩蓋我們的認知局限性,使我們容易產生一種錯覺,即我們認為自己對世界的解比實際情況要多。

因此,科學傢需要審慎考慮 AI 在科學研究中的潛在影響,從而負責任地進行知識生產。

相關研究論文以“Artificial intelligence and illusions of understanding in scientific research”為題,已發表在科學期刊 Nature 上。

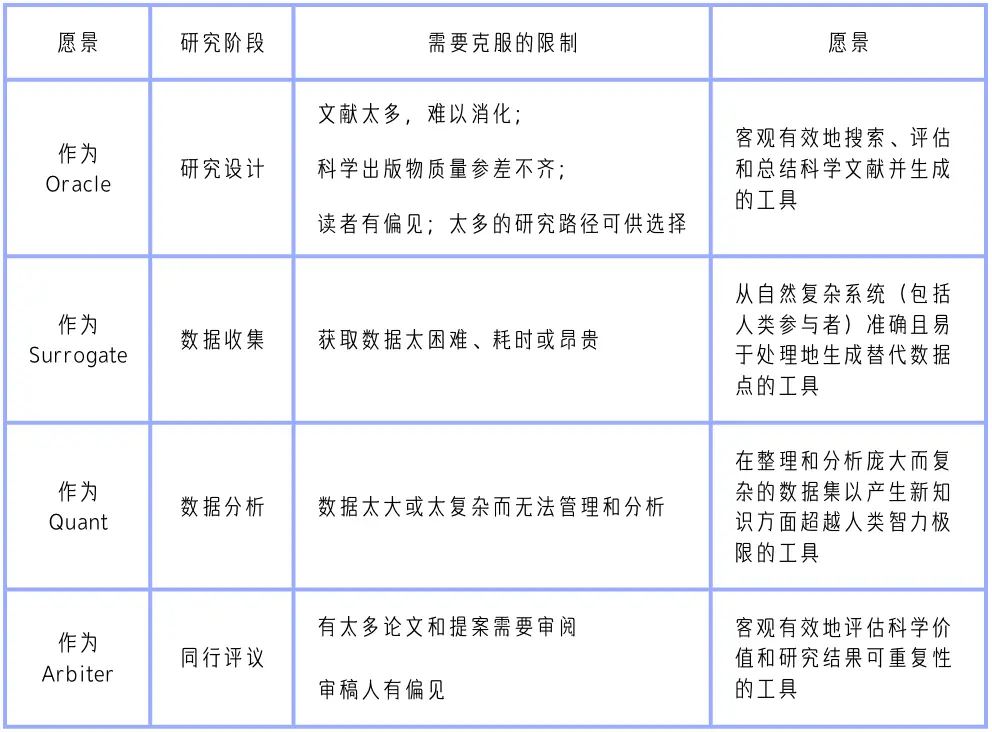

該論文從大量與 AI4Science 相關的文獻中,提煉出 AI 的四大應用願景——智囊團(Oracles)、代理人(Surrogates)、量化分析師(Quants)和裁決者(Arbiters),並分別討論 AI 在科學研究中的應用和影響。

表|科學研究中的 AI 願景。通過分析最近有關 AI 改善跨科學學科知識生產潛力的出版物,得出以上四種類型。納入的論文要麼使用“AI”這個通用短語,要麼提到 AI 概念之下的特定方法,最常見的是機器學習、自然語言處理和大型語言模型。該表總結願景如何響應不同的研究階段,以及對科學能力和效率的感知限制。

人類科學傢為何信任AI?

近年來,AI 在科學研究中的應用日益廣泛,其提供的解決方案被認為能夠徹底改變科學研究方法。

但 AI 何以獲得科學傢的信任呢?

首先,AI 工具不僅被視為工具,更被看作是研究中的合作者,能夠提供超越人類限制的解決方案和見解。這種認知增強科學傢對 AI 的信任,因為他們將這些工具視為知識生產中的夥伴。

其次,AI 工具被認為具有增強其可信度的特質,如客觀性、深度理解能力以及提供令人滿意的解釋能力。這種描繪使得 AI 工具在某些情況下比人類更值得信賴。

第三,AI 工具提供的解決方案符合人們對簡單、廣泛、簡化和量化解釋的偏好,進而增強對理解的感知。

然而,將 AI 整合到科學研究中也存在認知風險,尤其是認知理解的錯覺形式。

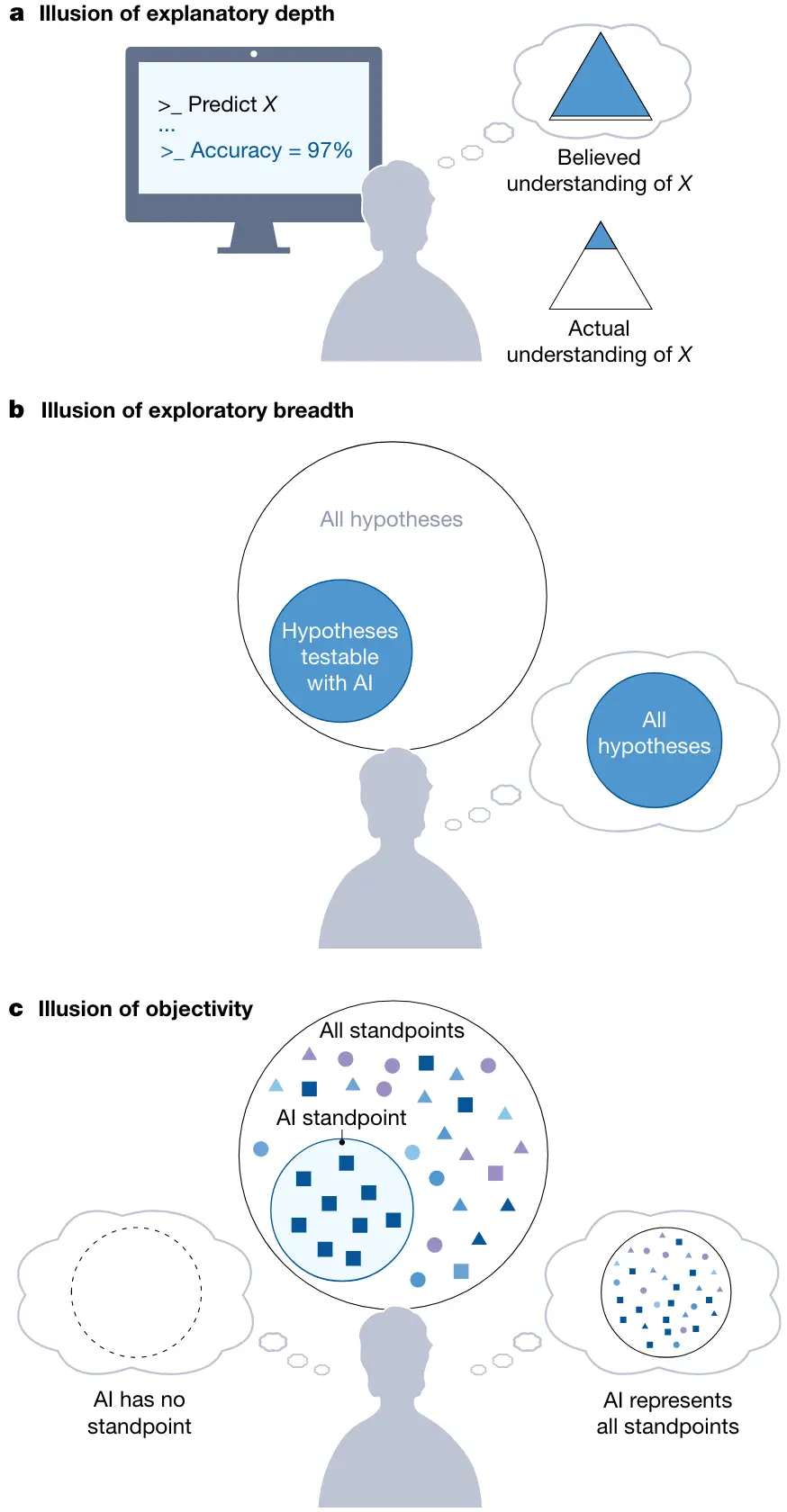

圖|AI 驅動的科學研究中的理解錯覺。

如上圖 a 所示,使用 AI 工具進行研究的科學傢可能會產生解釋深度的錯覺。在示例中,一位科學傢使用 AI Quant 對現象 (X) 進行建模,並相信他們對 X 的理解比實際更深入。

在圖 b 中,在單一的認知文化中,科學傢很容易產生探索廣度的錯覺,他們錯誤地認為自己正在探索所有可檢驗假設的空間,而實際上他們正在探索可以用 AI 工具檢驗的更狹窄的假設空間。

另外,如圖 c,在知識者單一文化中,科學傢很容易產生客觀性錯覺,他們錯誤地認為 AI 工具沒有立場或能夠代表所有可能的立場使用人類參與者進行研究的替代者),而 AI 工具實際上嵌入訓練數據和開發人員的觀點。認知理解的錯覺發生在個體高估自己的理解程度時,將 AI 工具或其他社區成員的知識和能力誤認為自己的。這種現象可能導致科學論斷中的錯誤和過度樂觀,特別是當 AI 工具在專傢領域之外使用時。

AI4Science的未來,一切向好嗎?

由於 AI 工具看似可信且承諾提升研究的質量和數量,因此依賴這些工具的研究可能會大幅增加。目前,關於 AI 的引用在出版物和專利中在逐漸增多,並且使用 AI 工具的論文在學科內外的引用都呈現出增加的趨勢。

如果這個趨勢持續發展,那麼當 AI 輔助研究逐漸主導知識生產,會有哪些認知風險?

文中給出一個觀點:科學可能會形成單一文化。

作者用一個類比來說明這一點:在農業中,單一文化是一種在同一片土地上隻種植一種作物的做法。這種做法提高效率,但也使作物更容易受到害蟲和疾病的侵害。

文章認為,AI 工具所提供的效率可以促進科學單一文化的發展,其中某些形式的知識生產主導其他所有形式。它們可以通過兩種不同但相輔相成的方式實現。

首先,通過優先考慮最適合 AI 輔助的問題和方法(知識生產的單一文化)。

其次,通過優先考慮 AI 能夠表達的觀點類型(知識所有者的單一文化)。

就像植物單一文化更容易受到害蟲和疾病的侵害一樣,科學單一文化使我們對世界的理解更容易出現錯誤、偏見和錯失創新的機會。

當新工具和技術產生時,科學傢總是傾向於迅速利用它們的優勢。然而,AI 工具被預測將在各個領域得到廣泛應用,成為超級合作者融入到知識社區中,這樣的風險可能會變得尤其嚴重。

除威脅科學的蓬勃發展外,知識生產的單一文化還會產生認知理解錯覺。在這些錯覺中,科學傢錯誤地認為,AI 工具推進人類對科學的理解,而不是意識到,這些工具實際上縮小科學知識生產的范圍。

解風險,是應對風險的關鍵一步。為減輕 AI 在知識生產中應用的風險,人類需要增強對科學單一文化的認知風險的理解,以及對認知錯覺的感知。

事實上,AI 在科學中的應用確實讓所有人興奮,比如 AI 化學傢加速催化研究(點擊查看詳情),生成式 AI 助力碳捕集(點擊查看詳情)等等。

然而,在 AI4Science 走得更遠之前,科學傢們必須考慮到 AI 的技術限制和潛力,以及它對科學知識生產社會實踐的影響。

AI 輔助科學研究也許預示著這樣一個未來,其中不僅參與者缺乏多樣性,而且追求的研究主題也缺乏多樣性。它們還引發認知理解的錯覺,阻止我們意識到我們的視野已經變窄。

盡管 AI 在科學中的廣泛應用是不可避免的,但科學傢,除進行知識生產外,還有責任決定事物的發展方式。

論文鏈接:

https://www.nature.com/articles/s41586-024-07146-0