人工智能的炒作還是很熱,仿佛全自動駕駛和比人聰明的人工智能就是幾年內的事情。但訓練數據集擴大帶來的回報正在遞減,而用所述數據集所需的算力(能源、成本)又呈指數級增長,再加上更高效的解決方案還沒有出現或進入實用階段,未來幾年人工智能的發展將面臨天花板,別總想著指數發展。

過去幾個月,對人工智能的炒作已經到瘋狂的地步。什麼特斯拉在一兩年內就要實現全自動駕駛,人工智能明年將會變得比人類更聰明,到 2040 年會有十億臺人工智能機器人取代人類工人,這些還隻是埃隆·馬斯克今年迄今為止對人工智能許下的海口之一。整個人工智能圈都充斥著這樣的預測和承諾,給人感覺人工智能的發展已走上不可阻擋的指數軌跡曲線上,已經到我們人類根本無法阻止的地步。但是事實並非如此。要我說,人工智能正開始觸碰到收益遞減的發展天花板,從而令這些誇張的承諾變成一張廢紙。下面我會解釋的。

要想理解這個問題,我們得先解一點人工智能的基本工作原理。現代人工智能運用的是深度學習算法與人工神經網絡,借此來發現數據當中的趨勢。然後,人工智能就可以根據這些數據推斷或沿著同一趨勢線生成新的數據。這首先需要“訓練”人工智能,將大量數據喂給它進行分析,讓它去發現這些趨勢。之後,你就可以拋問題給人工智能來獲得輸出。這個基本概念為計算機視覺、自動駕駛汽車、聊天機器人以及生成式人工智能提供動力。這個解釋有點簡化,但現在我們隻需要解這些就夠。

過去幾年,人工智能的能力有顯著增強。這部分要歸功於有更好的編程和算法。但 90% 要歸功於用更大的數據集對人工智能進行訓練。從而使得人工智能可以更準確地解數據趨勢,從而更準確地生成結果。但有個問題:我們正目睹相對於所需的數據和算力,訓練人工智能帶來的回報正在急劇遞減。

我們先從數據講起。假設我們開發一個簡單的計算機視覺人工智能,它可以識別出狗和貓,我們已經用 100 隻狗和貓的圖像和視頻對其進行訓練,它可以在 60% 的時間內正確識別這些動物。如果我們將訓練的圖像和視頻數量增加一倍,達到 200 個,其識別率就會提高,但隻能略微提高到 65% 左右。如果我們再次將訓練圖像和視頻增加一倍,達到 400 個,那麼其改進將更加微乎其微,隻能達到 67.5% 左右。

這其中的部分原因在於,如果你手頭的數據集比較小時,相對於較大的數據集,往裡面添加一張新的訓練圖像,所提供的新數據會更多。不過,這也是因為人工智能處理小的數據集可以迅速建立新的連接與趨勢,因為它隻需找到適用於幾個示例的趨勢即可。但隨著數據集的增長,找到對整個數據集都適用的新趨勢和連接變得越來越難。這些來自較更大數據集的新趨勢和連接讓人工智能變得更好、能力更強。因此,隨著訓練人工智能的收益遞減,我們看到將人工智能改進到一定程度所需要的訓練數據量急劇增加。

但這裡面還有一個問題。訓練人工智能對算力的需求非常大。人工智能必須將每個單獨的數據點與數據集所有其他數據點進行比較,這樣才能找到它們的關聯和趨勢。這意味著,每往人工智能訓練數據庫添加一位數據,用這個數據庫訓練人工智能所需的計算工作量都會呈指數級增長。因此,就算你有能力獲取到訓練這些不斷改進的人工智能所需的大量數據,它所需的物理計算能力和能源最終也會增長到難以為繼的地步。

可悲的是,有證據表明,我們現在正處在這樣一個階段:一方面訓練數據集擴大帶來的回報在遞減,一方面用所述數據集所需的算力又呈指數級增長,這些都會給人工智能的發展制造剛性的上限。

就拿 OpenAI 的旗艦人工智能產品 ChatGPT4 來說吧,但它相對於 ChatGPT3 的改進要小於 ChatGPT3 相對於 ChatGPT2 的改進,盡管它的準確率提高,但仍然存在跟 ChatGPT3 一樣的幻覺與缺乏理解的問題。雖說OpenAI 對自己的人工智能開發方式守口如瓶,但專傢調查發現,ChatGPT3 使用的訓練數據集比 ChatGPT2 大 78 倍,而ChatGPT4 所用的數據集比 ChatGPT3 要大 571 倍!可是,盡管訓練數據集的大小有顯著提升, 但ChatGPT4 仍然存在重大缺陷,大大限制它的使用場景。比方說,還是不能信任它能寫出任何以事實為基礎的東西,因為它仍然在編造事實。

有人估計 ChatGPT4 的原始訓練數據集有 45 TB 的純文本。這意味著,下一次迭代要想取得 ChatGPT4 相對於 ChatGPT3 那樣的巨大進步,訓練數據集需要達數萬 TB 之巨 。即便采用OpenAI 存疑的方法,獲取和準備如此大量的純文本數據也很不切實際。然而,就算真用這個數據集來訓練人工智能也可能要消耗大量能源,大到這種成本令人工智能變得完全不可行的地步,那怕你是一傢非營利組織也不可行。

這麼說並不誇張。 OpenAI 首席執行官山姆·阿爾特曼 (Sam Altman) 九層公開表示,先進的人工智能要想變得可行,需要能源技術取得突破,比如核聚變。可悲的是,就算我們確實實現核聚變,在本世紀乃至下世紀這種技術也不太可能比我們目前的能源便宜。事實上,任何形式的能源都不會比我們目前所擁有的能源便宜得多。因此,針對人工智能能源問題提出的解決方案具有很大的誤導性。

這個觀點得到一些非常嚴肅的研究的支持。馬薩諸塞大學阿默斯特分校曾做過一項研究,他們分析將圖像識別人工智能性能提高到準確率達 95% 以上所需的計算和能源成本。研究發現,訓練這樣一個模型將需要花費 1000 億美元,其所產生的碳排放量相當於紐約市一個月的碳排放量。請記住,這是針對仍有 5% 的時間會出現災難性錯誤的人工智能而言的。該研究還強調,將準確率提高到 99% 需要的成本和碳排放還會成倍增加。

這就是為什麼特斯拉永遠不會用當前的方式開發全自動駕駛汽車的原因所在。他們的Autopilot和FSD隻能通過這種人工智能計算機視覺來感知周圍的世界,而FSD要想實現全自動駕駛,其圖像識別精度需要接近100%的準確度。正如那項研究所表明那樣,要想讓特斯拉的人工智能變得那麼好,其所需要的資金也許遠非特斯拉能負擔得起。

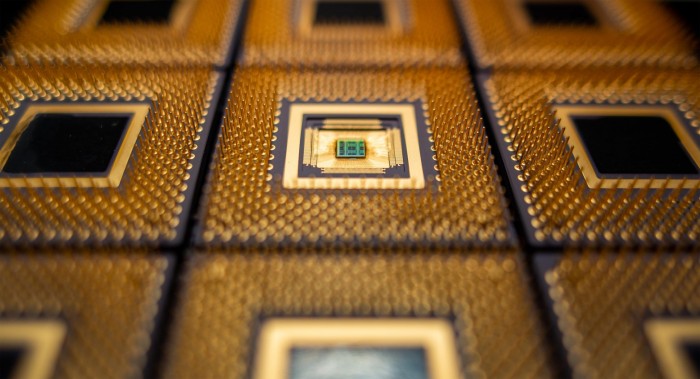

換句話說,除非人工智能行業能夠找到一種更高效的方法來提高訓練人工智能以及計算負載的效率,否則就無法突破這個限制,然後人工智能的發展就將完全停滯。目前可能的解決方案即將出現,比方說結合模擬與量子技術的更高效的人工智能硬件,以及需要訓練數據集個更小的新的人工智能架構。不過,這些概念仍處在起步階段,距離應用到現實世界可能還需要幾十年的時間。

簡而言之,大傢得有個心理準備,未來幾年人工智能的發展肯能會大幅低於預期。