AI孫燕姿這麼快翻唱這麼多首歌,到底是咋實現的?關鍵在於一個開源項目。最近,這波AI翻唱趨勢大火,不僅是AI孫燕姿唱的歌越來越多,AI歌手的范圍也在擴大,就連制作教程都層出不窮。

而如果在各大教程中溜達一圈後就會發現,其中的關鍵秘訣,還是要靠一個名為so-vits-svc的開源項目。

它提供一種音色替換的辦法,項目在今年3月發佈。

貢獻成員應該大部分都來自國內,其中貢獻量最高的還是一位玩明日方舟的廣西老表。

如今,項目已經停止更新,但是星標數量還在蹭蹭上漲,目前已經到8.4K。

所以它到底實現哪些技術能引爆這波趨勢?

一起來看。

多虧一個開源項目

這個項目名叫SoftVC VITS Singing Voice Conversion(歌聲轉換)。

它提供一種音色轉換算法,采用SoftVC內容編碼器提取源音頻語音特征,然後將矢量直接輸入VITS,中間不轉換成文本,從而保留音高和語調。

此外,還將聲碼器改為NSF HiFiGAN,可以解決聲音中斷的問題。

具體分為以下幾步:

預訓練模型

準備數據集

預處理

訓練

推理

其中,預訓練模型這步是關鍵之一,因為項目本身不提供任何音色的音頻訓練模型,所以如果你想要做一個新的AI歌手出來,需要自己訓練模型。

而預訓練模型的第一步,是準備幹聲,也就是無音樂的純人聲。

很多博主使用的工具都是UVR_v5.5.0。

Twitter博主@歸藏介紹說,在處理前最好把聲音格式轉成WAV格式,因為So-VITS-SVC 4.0隻認這個格式,方便後面處理。

想要效果好一些,需要處理兩次背景音,每次的設置不同,能最大限度提高幹聲質量。

得到處理好的音頻後,需要進行一些預處理操作。

比如音頻太長容易爆顯存,需要對音頻切片,推薦5-15秒或者再長一點也OK。

然後要重新采樣到44100Hz和單聲道,並自動將數據集劃分為訓練集和驗證集,生成配置文件。再生成Hubert和f0。

接下來就能開始訓練和推理。

具體的步驟可以移步GitHub項目頁查看(指路文末)。

值得一提的是,這個項目在今年3月上線,目前貢獻者有25位。從貢獻用戶的簡介來看,很多應該都來自國內。

據說項目剛上線時也有不少漏洞並且需要編程,但是後面幾乎每一天都有人在更新和修補,現在的使用門檻已經降低不少。

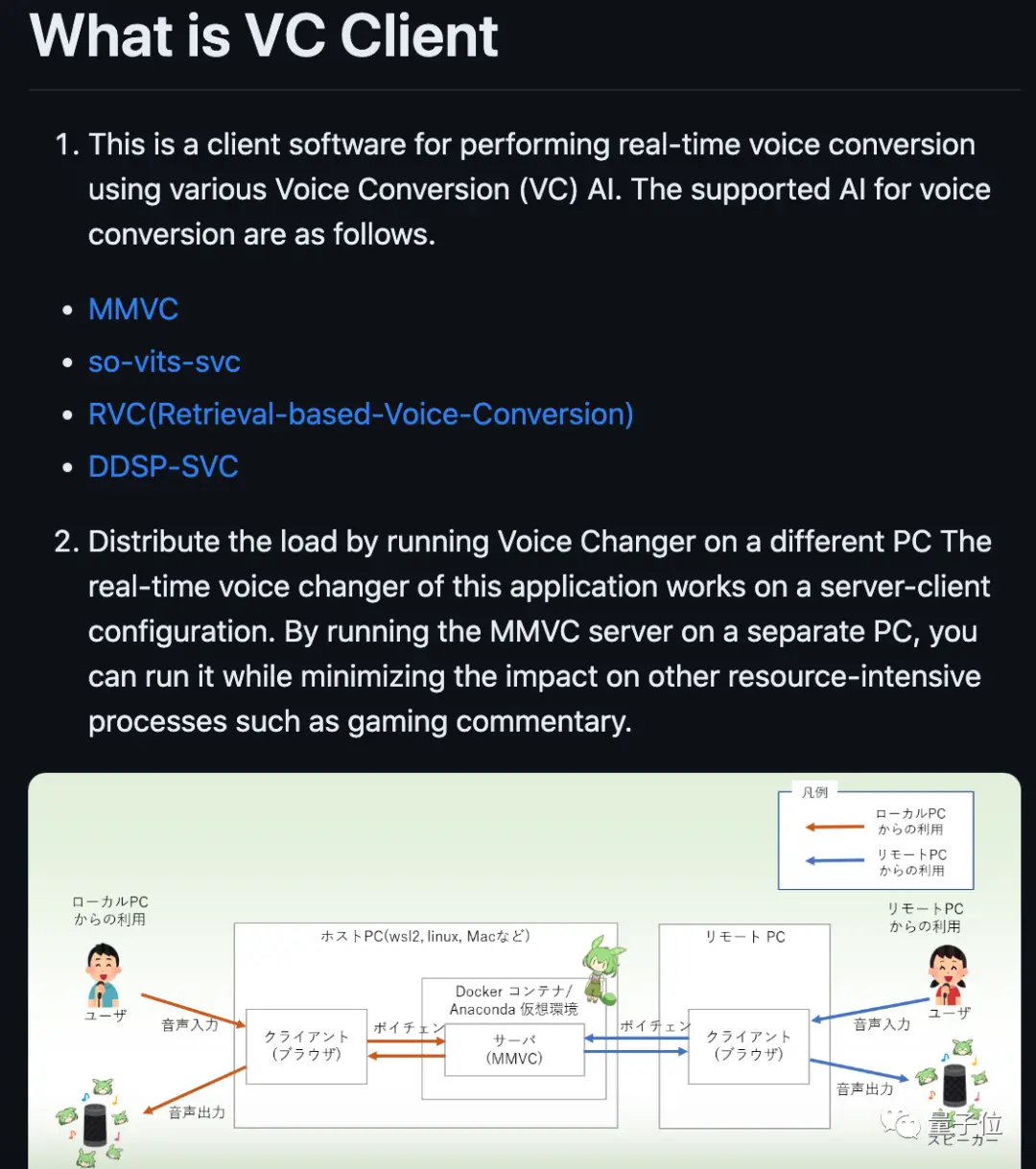

目前項目已經停止更新,但還是有一些開發者創建新的分支,比如有人做出支持實時轉換的客戶端。

項目貢獻量最多的一位開發者是Miuzarte,從簡介地址判斷應該來自廣西。

隨著想要上手使用的人越來越多,也有不少博主推出上手難度更低、更詳細的食用指南。

歸藏推薦的方法是使用整合包來推理(使用模型)和訓練,還有B站的Jack-Cui展示Windows下的步驟指南。

需要註意的是,模型訓練對顯卡要求還是比較高的,顯存小於6G容易出現各類問題。

Jack-Cui建議使用N卡,他用RTX 2060 S,訓練自己的模型大概用14個小時。

訓練數據也同樣關鍵,越多高質量音頻,就意味著最後效果可以越好。

還是會擔心版權問題

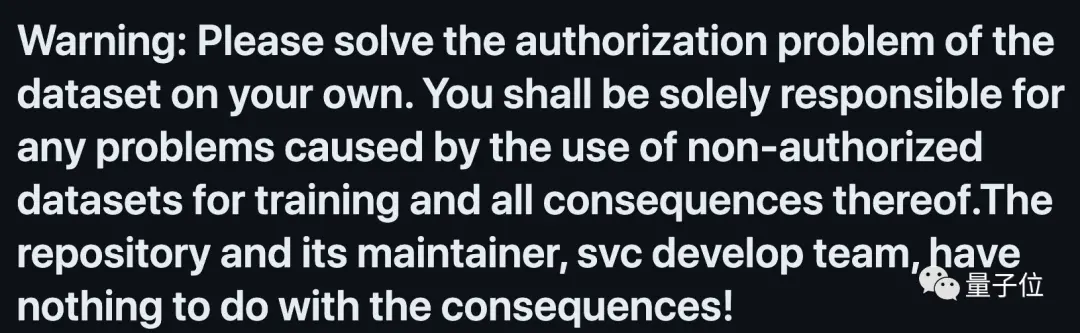

值得一提的是,在so-vits-svc的項目主頁上,著重強調版權問題。

警告:請自行解決數據集的授權問題。因使用未經授權的數據集進行培訓而產生的任何問題及其一切後果,由您自行承擔責任。存儲庫及其維護者、svc開發團隊,與生成結果無關!

這和AI畫畫爆火時有點相似。

因為AI生成內容的最初數據取材於人類作品,在版權方面的爭論不絕於耳。

而且隨著AI作品盛行,已經有版權方出手下架平臺上的視頻。

據解,一首AI合成的《Heart on My Sleeve》在油管和Tik Tok上爆火,它合成Drake和Weekend演唱的版本。

但隨後,Drake和Weekend的唱片公司環球音樂將這個視頻從平臺上下架,並在聲明裡向潛在的仿冒者發問,“是要站在藝術傢、粉絲和人類創造性表達的一邊,還是站在Deepfake、欺詐和拒付藝術傢賠償的一邊?”

此外,歌手Drake也在ins上對AI合成翻唱歌曲表達不滿。

而另一邊,也有人選擇擁抱這項技術。

加拿大歌手Grimes表示,她願意讓別人使用自己的聲音合成歌曲,但是要給她一半版權費。