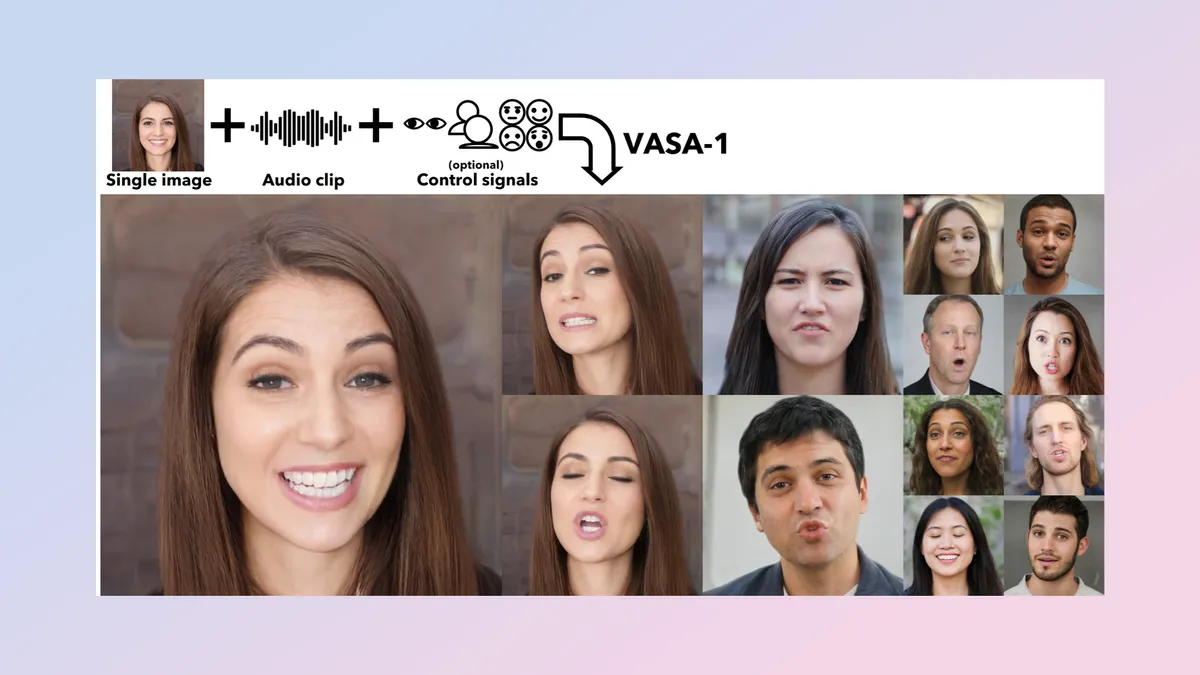

微軟公司的一篇新的人工智能研究論文展望未來:上傳一張照片和你的聲音樣本,然後創建一個活靈活現的會說話的人頭像。這種名叫VASA-1的人工智能模型可接收單張人像照片和音頻文件,並將其轉換成超逼真的人臉視頻,包括唇語同步、逼真的面部特征和頭部動作。

該模型目前隻是研究預覽版,微軟研究團隊以外的任何人都無法試用,但演示視頻看起來令人印象深刻。

Runway 和 NVIDIA 已經推出類似的唇部同步和頭部運動技術,但這種技術的質量和逼真度似乎要高得多,可以減少嘴部偽影。這種音頻驅動動畫的方法也與Google研究院最近推出的VLOGGER 人工智能模型類似。

VASA-1 如何工作?

微軟表示,這是一個新的框架,用於創建栩栩如生的會說話的人臉,專門用於虛擬人物的動畫制作。示例中的所有人物都是合成的,是用 DALL-E 制作的,但如果它能為逼真的人工智能圖像制作動畫,那麼它也能為真實的照片制作動畫。

在演示中,我們看到人們說話時就像在被拍攝一樣,動作略顯生澀,但看起來非常自然。唇語同步令人印象深刻,動作自然,嘴部上下沒有其他工具中出現的假象。

VASA-1 最令人印象深刻的一點似乎是,它不需要正面朝上的人像圖像就能工作。

其中有面向不同方向拍攝的例子。該模型似乎還具有很強的控制能力,能夠將眼睛註視的方向、頭部距離甚至情緒作為輸入來引導生成。

VASA-1 的意義何在?

其中一個最明顯的應用案例就是遊戲中的高級唇語同步。如果能創造出具有自然唇部動作的人工智能驅動的 NPC,就能改變遊戲的沉浸感。

它還可用於為社交媒體視頻創建虛擬化身,HeyGen 和 Synthesia 等公司已經采用這種技術。另一個領域是基於人工智能的電影制作。如果能讓人工智能歌手看起來像在唱歌,就能制作出更逼真的音樂視頻。

盡管如此,該團隊表示,這隻是一次研究演示,並沒有公開發佈的計劃,甚至也不會提供給開發人員在產品中使用。

VASA-1 的效果如何?

讓研究人員感到驚訝的是,VASA-1 能夠完美地對歌曲進行歌詞嘴型同步,盡管訓練數據集中沒有使用音樂,但它仍能毫無問題地反映歌手的歌詞。它還能處理不同風格的圖像,包括蒙娜麗莎。

他們讓它以每秒 45 幀的速度創建 512x512 像素的圖像,使用桌面級 NVIDIA RTX 4090 GPU 可在大約 2 分鐘內完成。

雖然他們說這隻是用於研究,但如果它不能進入公共領域,那就太可惜,即使隻是面向開發者,鑒於微軟在OpenAI中擁有巨大的股份,這甚至可能成為未來 Copilot Sora 集成的一部分。