對人工智能能夠完美再現一個人的聲音的一大擔憂是其潛在的欺詐行為。這種技術在過去幾個月裡取得巨大的進步,而且不出所料正在被犯罪分子濫用,他們可以欺騙聲音,讓主人的傢人相信這個人需要經濟幫助。

《華盛頓郵報》報道,一對70多歲的加拿大夫婦最近接到一個聽起來像他們孫子的電話,聲稱他在監獄裡,需要保釋金。他們從一傢銀行提取最多3000加元,準備從另一傢銀行提取同樣的金額時,經理告訴他們,他們被騙;原來,另一位客戶也接到類似的電話,並得知是假的。

另一對沒有這麼幸運的夫婦是本傑明·珀金的父母。他們接到一個律師的電話,說他們的兒子在一場車禍中殺死一名美國外交官,而珀金正在坐牢,需要錢來支付訴訟費。律師讓珀金接電話,珀金說他愛他們,並感謝這筆錢。

珀金說,這個聲音聽起來"足夠接近,讓我的父母真正相信他們確實在和我說話"。他的父母通過一個比特幣終端向詐騙者匯出15449美元,至今仍未能取回。

基於語音的騙局並不新鮮。聯邦貿易委員會的數據顯示,去年有36000份關於人們被假裝成朋友或傢人的犯罪分子詐騙的報告,其中超過5100起事件發生在電話中。

欺騙一個人的聲音曾經是一個復雜而漫長的過程,涉及到發現和收集數小時的音頻,而最終的結果並不總是很有說服力。然而,現在,人工智能工具已經使這一過程變得如此簡單,以至於騙子隻需要一個人說話的小片段,通常是從社交媒體賬戶上收集的,就可以準確地重現他們的聲音。

這種技術的一個例子是微軟公司在1月份宣佈的Vall-E工具。它建立在Meta公司2022年10月宣佈的一項名為EnCodec的技術基礎上,通過分析一個人的聲音,將信息分解為各個組成部分,並利用其訓練來合成該聲音在說不同短語時的聲音。即使隻聽三秒鐘的樣本,Vall-E也能復制出說話者的音色和情緒語調。在這個GitHub頁面上,可以看到它是多麼的令人信服。

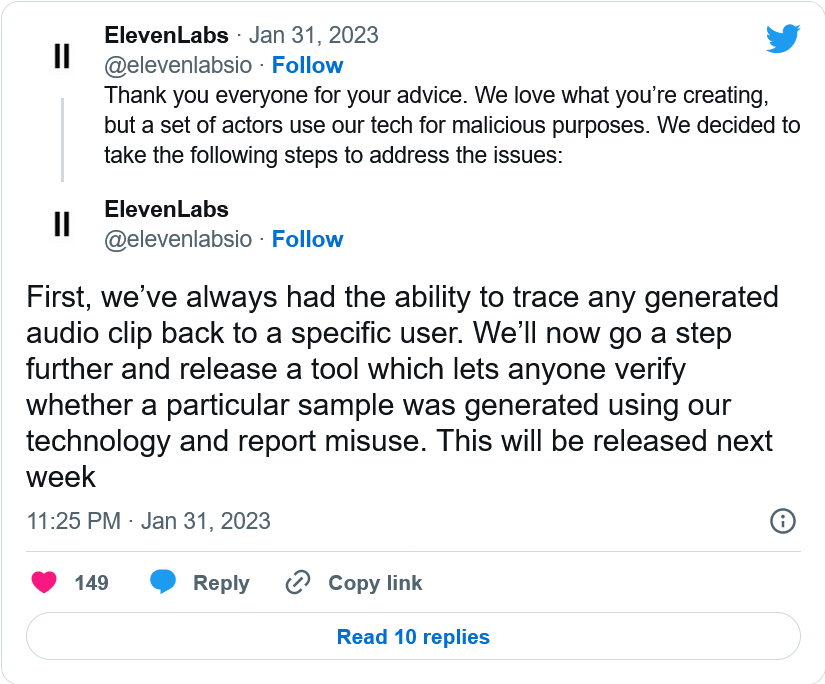

提供生成性人工智能語音工具的ElevenLabs最近在Twitter上表示,它看到"越來越多的語音克隆誤用案例"。這導致其VoiceLab程序的免費版本中刪除聲音克隆功能。