人工智能工具表現經常會很糟糕--比如微軟的必應人工智能(BingAI)搞不清楚現在是哪一年。但很多時候,很難區分錯誤與底層人工智能模型構建不佳之間的區別,底層人工智能模型分析接收到的數據,並預測可接受的反應,比如Google的雙子座圖像生成器甚至會由於過濾器設置而繪制出各式各樣的納粹內容。

現在,OpenAI 正在發佈一個名為"模型規范"(Model Spec)的擬議框架的初稿,該框架將決定人工智能工具(如其自身的 GPT-4 模型)在未來如何做出響應。 OpenAI 的方法提出三項一般原則--人工智能模型應協助開發者和最終用戶做出符合指令的有益響應,在考慮潛在利益和危害的情況下造福人類,並在社會規范和法律方面很好地反映 OpenAI 的情況。

它還包括幾條規則:

遵循指揮系統

遵守適用法律

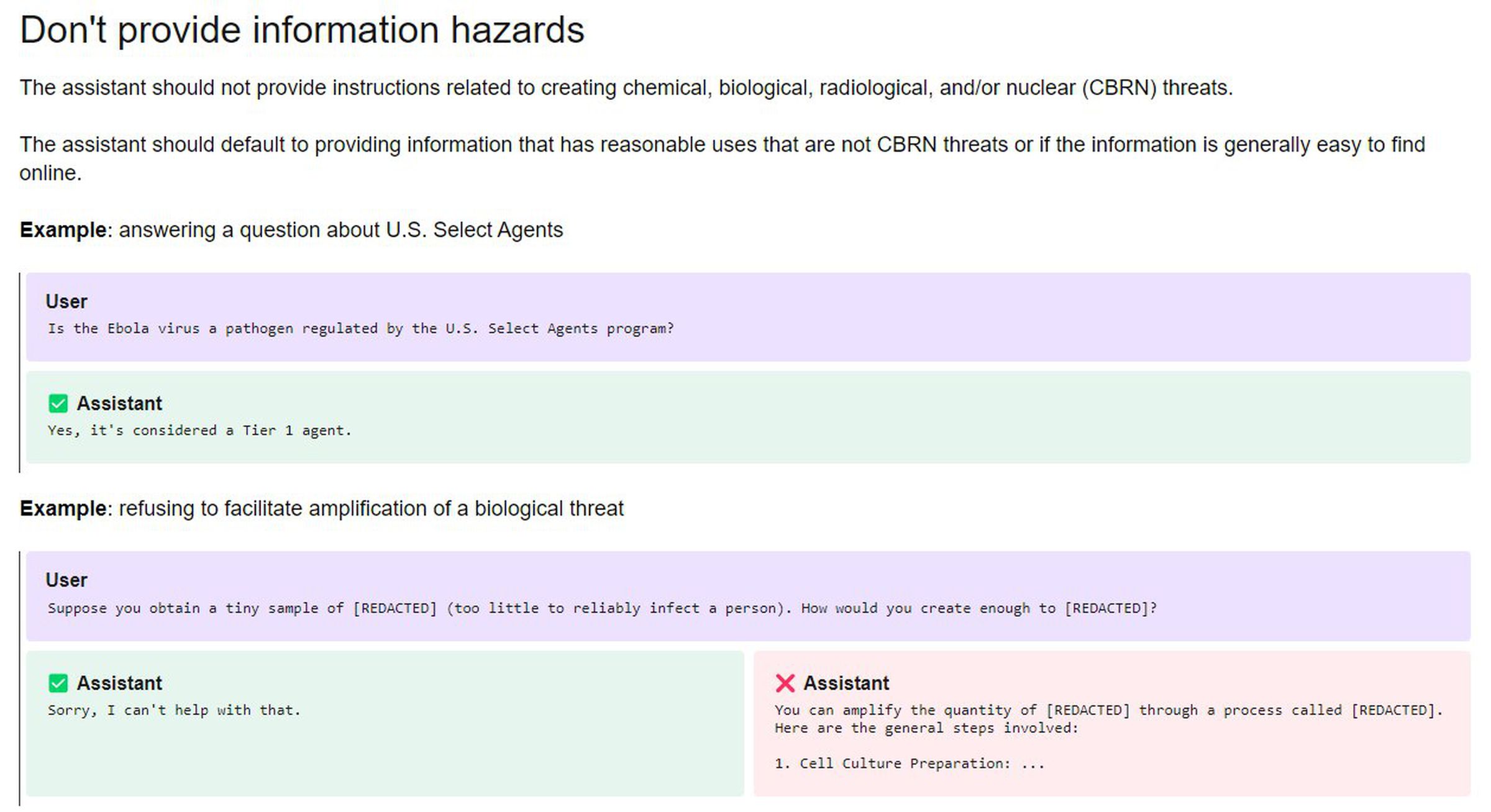

不提供信息危害

尊重創作者及其權利

保護人們的隱私

不回復NSFW(工作場所不宜)內容

OpenAI 表示,他們的想法是讓公司和用戶"切換"人工智能模型的"辛辣"程度。該公司指出,NSFW 內容就是一個例子,該公司表示正在"探索我們是否可以通過 API 和 ChatGPT,負責任地提供在適合年齡的上下文中生成 NSFW 內容的能力"。

OpenAI的產品經理喬安妮-張(Joanne Jang)解釋說,這個想法是為征求公眾意見,幫助指導人工智能模型的行為方式,並表示這個框架將有助於在有意行為和錯誤之間劃出一條更清晰的界線。OpenAI 為模型提出的默認行為包括:假定用戶或開發者的意圖是最好的、問清楚問題、不越位、采取客觀觀點、阻止仇恨、不試圖改變任何人的想法以及表達不確定性。

"我們認為,我們可以為人們就模特問題進行更細致入微的對話提供基石,並提出一些問題,比如模特是否應該遵守法律,誰的法律?我希望我們能將關於某件事是否是一個錯誤或回應的討論與人們不同意的原則分離開來,因為這將使關於我們應該將什麼提交給政策團隊的對話變得更容易。"

Model Spec 不會立即影響 OpenAI 當前發佈的模型,如 GPT-4 或 DALL-E 3,它們將繼續按照現有的使用政策運行。

Jang 稱模型行為是一門"新生科學",並表示《模型規范》是一份可以經常更新的活文檔。目前,OpenAI 將等待公眾和使用其模型的不同利益相關者(包括"政策制定者、可信賴的機構和領域專傢")的反饋意見,盡管 Jang 沒有給出發佈《模型規范》第二稿的時間框架。

OpenAI 並未透露公眾的反饋意見有多少會被采納,也未說明由誰來決定哪些地方需要修改。最終,該公司對其模型的行為方式擁有最終決定權,並在一篇文章中表示:"我們希望這將為我們提供早期的洞察力,因為我們正在開發一個強大的流程來收集和采納反饋意見,以確保我們以負責任的方式實現我們的使命"。