近日,來自麻省理工的研究團隊發表Ddog項目,隻需一幅眼鏡就可以控制四足機器人,幫助特殊人群重獲希望還記得之前的AI讀心術嗎?最近,“心想事成”的能力再次進化,——人類可以通過自己的想法直接控制機器人!

來自麻省理工的研究人員發表Ddog項目,通過自己開發的腦機接口(BCI)設備,控制波士頓動力的機器狗Spot。

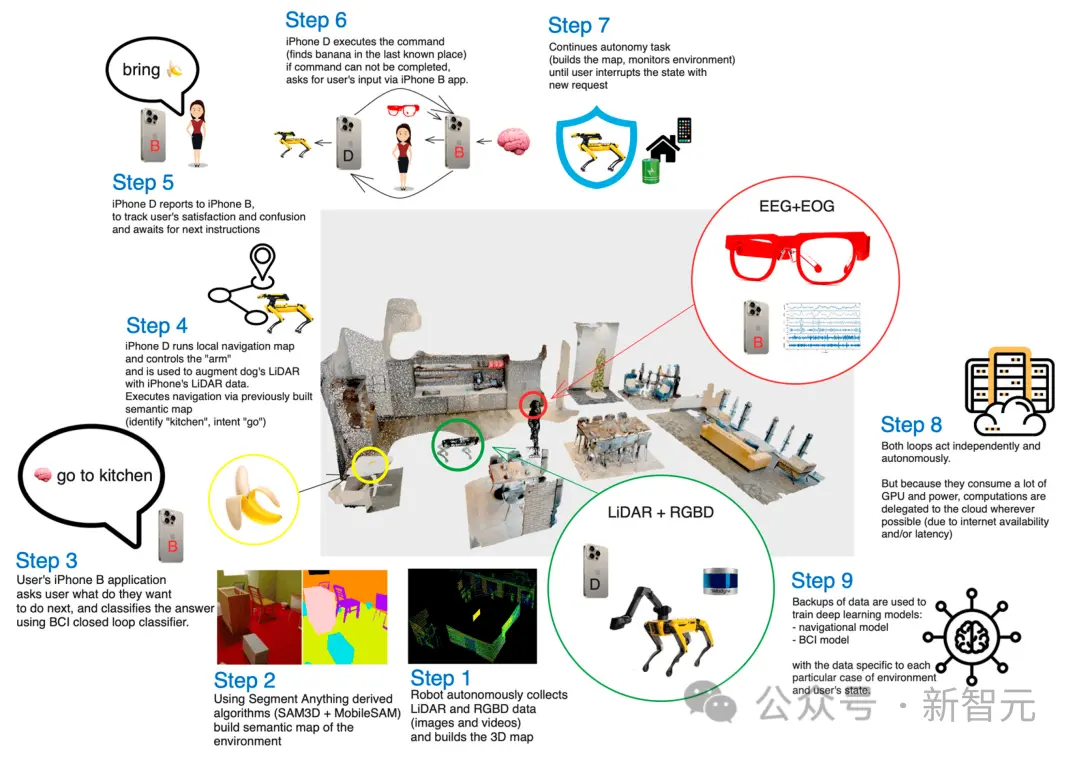

狗狗可以按照人類的想法,移動到特定區域、幫人拿東西、或者拍照等。

而且,相比於之前需要使用佈滿傳感器的頭套才能“讀心”,本次的腦機接口設備以一幅無線眼鏡(AttentivU)的形式出現!

視頻中展示的行為也許比較簡單,但這個系統的目的是將Spot改造為能夠為患有肌萎縮側索硬化癥(ALS)、腦癱或脊髓損傷等疾病的人士提供基本溝通工具。

整個系統的運行隻需要兩部iPhone和一副眼鏡,卻能給這些已經對生活失去希望的人帶去實際的幫助和關懷。

並且,我們將在相關的論文中看到,這個系統實際上建立在非常復雜的工程之上。

論文地址:https://doi.org/10.3390/s24010080

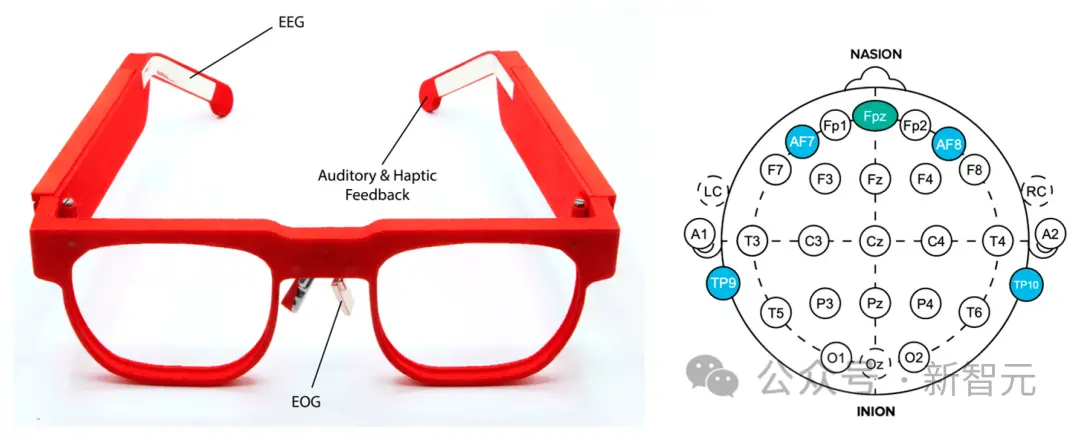

Ddog系統使用AttentivU作為腦機接口系統,傳感器嵌入到鏡框中,用來測量一個人的腦電圖 (EEG) 或大腦活動,以及眼電圖或眼球運動。

這項研究的基礎是MIT的Brain Switch,一種實時的閉環BCI,允許用戶與看護人進行非語言和實時的交流。

Ddog系統成功率為83.4%,並且,這是在個人助理用例中首次將無線、非視覺BCI系統與Spot集成。

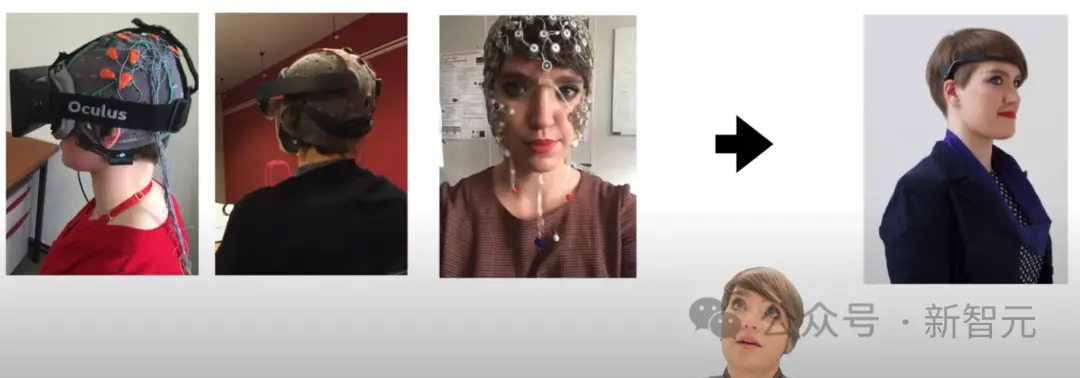

視頻中我們可以看到腦際接口設備的進化之路,以及開發者的一些思考。

在此之前,研究團隊就已經完成腦機接口與智能傢居的交互,而現在完成控制能夠移動和操作的機器人。

這些研究給特殊人群一絲光明,讓他們有活下去的希望,甚至未來可以生活得更好。

相比於章魚一樣的傳感器頭套,下面這個眼鏡確實酷多。

根據美國國傢罕見疾病組織的數據,目前美國有30000名ALS患者,且估計每年診斷出5000例新病例。此外,根據《腦癱指南》,大約有100萬美國人患有腦癱。

這些人中的許多人已經或最終將失去走路、穿衣、說話、寫作甚至呼吸的能力。

雖然確實存在通信輔助工具,但大多數是允許用戶使用計算機進行通信的眼睛凝視設備。允許用戶與周圍世界互動的系統並不多。

這種BCI四足機器人系統作為一個早期的原型,為現代個人助理機器人的未來發展鋪平道路。

希望在未來的迭代中,我們能看到更加驚人的能力。

腦控四足機器人

在這項工作中,研究人員探索無線和可穿戴BCI設備如何控制四足機器人——波士頓動力公司的Spot。

研究人員開發的設備通過嵌入眼鏡架中的電極測量用戶的腦電圖(EEG)和眼電圖(EOG)活動。

用戶在心中回答一系列問題(“是”或“否”),每個問答都對應一組預置的Spot操作。

比如提示Spot穿過一個房間,拿起一個對象(如一瓶水),然後為用戶取回它。

機器人與BCI

時至今日,腦電圖仍然是最實用和最適用的非侵入性腦機接口方法之一。

BCI系統可以使用內源性(自發)或外源性(誘發)信號進行控制。

在外源性腦機接口中,當一個人註意外部刺激(如視覺或聽覺線索)時,就會出現誘發信號。

這種方法的優點包括極簡的訓練以及高達60位/分鐘的高比特率,但這需要用戶始終關註刺激,從而限制其在現實生活中的適用性。而且,用戶在使用外源性BCI時會很快感到疲倦。

在內源性腦機接口中,控制信號獨立於任何外部刺激產生,可以由用戶按需完全執行。對於那些有感覺障礙的用戶來說,這提供一種更自然和直觀的交互方式,用戶可以自發地向系統發出命令。

不過這種方法通常需要更長的訓練時間,並且比特率較低。

使用腦機接口的機器人應用通常適用於需要幫助的人群,它們通常包括輪椅和外骨骼。

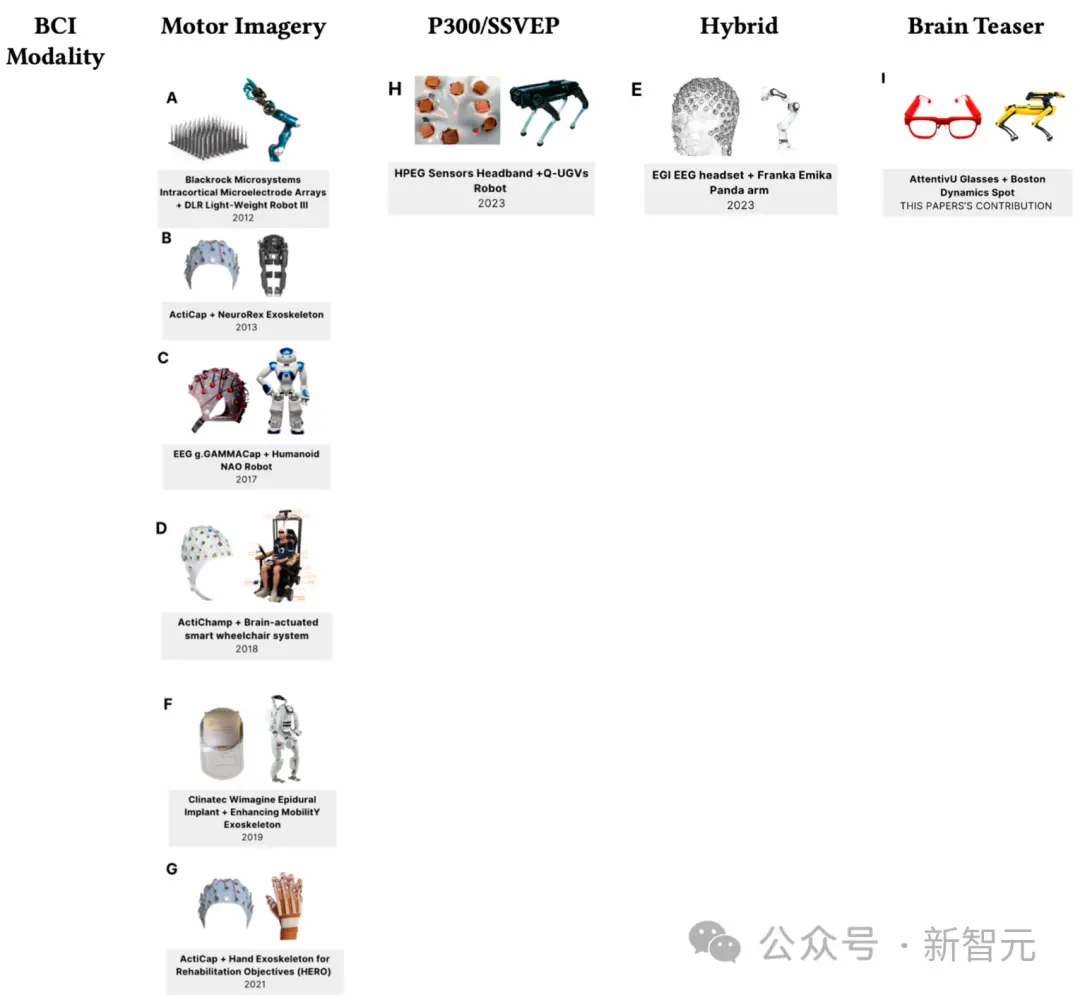

下圖展示截至2023年腦機接口和機器人技術的最新進展。

四足機器人通常用於在復雜的工作環境或國防應用中為用戶提供支持。

最著名的四足機器人之一是波士頓動力公司的Spot,它可以攜帶高達15公斤的有效載荷,並迭代繪制隧道等維護站點的地圖。房地產和采礦業也在采用Spot等四足機器人,幫助監控具有復雜物流的工作現場。

本文使用移動BCI解決方案控制的Spot機器人,並基於心算任務,總體架構命名為Ddog。

Ddog架構

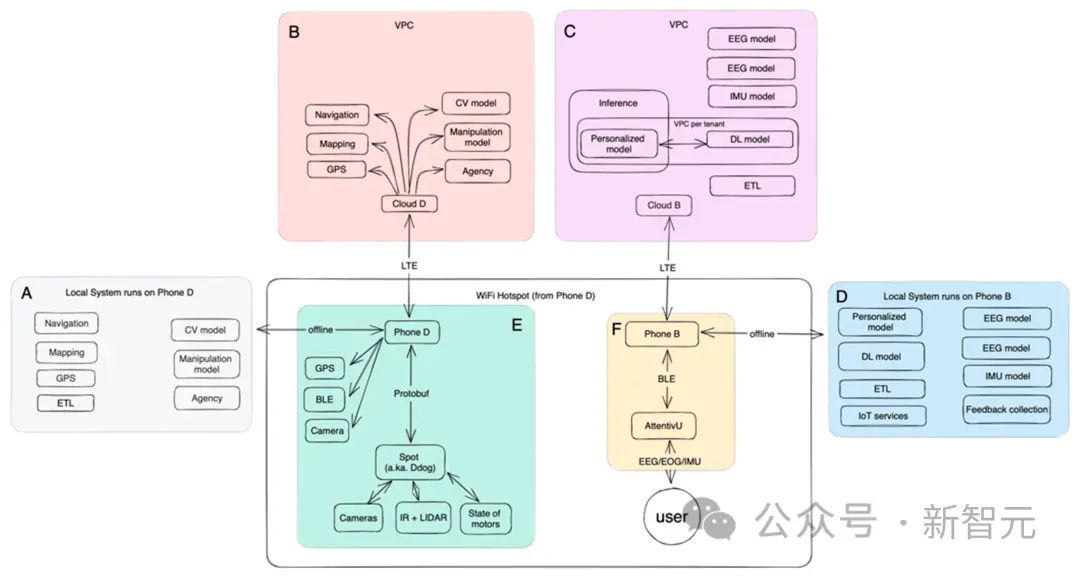

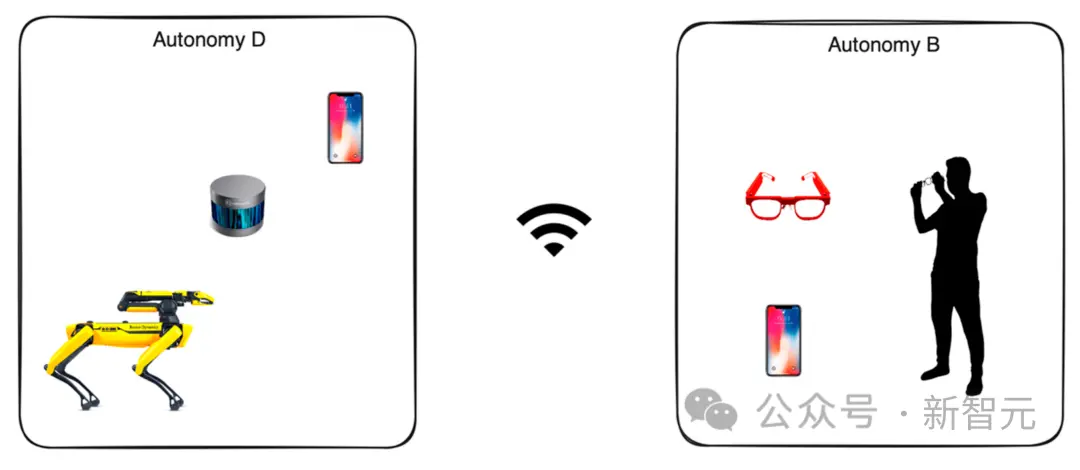

下圖展示Ddog的總體結構:

Ddog是一個自主應用程序,用戶能夠通過BCI的輸入控制Spot機器人,而應用程序使用語音向用戶及其護理人員提供反饋。

該系統設計為完全離線或完全在線工作。在線版本具有一組更高級的機器學習模型,以及更好的微調模型,對於本地設備也更省電。

整個系統為真實場景而設計,並允許對大多數零件進行快速迭代。

在客戶端,用戶通過移動應用程序與腦機接口設備(AttentivU)進行交互,該應用程序使用低功耗藍牙(BLE)協議與設備進行通信。

用戶的移動設備與另一部控制Spot機器人的手機進行通信,以實現代理、操縱、導航,最終為用戶提供幫助。

手機之間的通信可以通過Wi-Fi或移動網絡。負責控制的手機建立一個Wi-Fi熱點,Ddog和用戶的手機都連接到這個熱點。使用在線模式時,還可以連接到雲上運行的模型。

服務端

服務器端使用Kubernetes(K8S)集群,每個集群都部署在自己的Virtual Private Cloud(VPC)中。

雲在專用VPC內工作,通常部署在更靠近最終用戶的同一可用區中,使每個服務的響應延遲最小化。

集群中的每個容器都設計為單一用途(微服務架構),每個服務都是一個正在運行的AI模型,它們的任務包括:導航、映射、計算機視覺、操縱、定位和代理。

映射:從不同來源收集有關機器人周圍環境信息的服務。它映射靜態的不可移動數據(一棵樹、一棟建築物、一堵墻),但也收集隨時間變化的動態數據(一輛車、一個人)。

導航:基於在先前服務中收集和擴充的地圖數據,導航服務負責在空間和時間上構建A點和B點之間的路徑。它還負責構建替代路線,以及估計所需的時間。

計算機視覺:從機器人攝像頭收集視覺數據,並利用手機的數據增強,生成空間和時間表示。此服務還嘗試分割每個視覺點並識別對象。

雲負責訓練與BCI相關的模型,包括腦電圖(EEG)、眼電圖(EOG)和慣性測量單元(IMU)。

部署在手機上的離線模型運行數據收集和聚合,同時也使用TensorFlow的移動端模型(針對更小的RAM和基於ARM的CPU進行優化)進行實時推理。

視覺和操作

用於部署分割模型的原始版本是利用LIDAR數據的單個TensorFlow 3D模型。之後,作者將其擴展到少樣本模型,並通過運行神經輻射場(NeRF)和RGBD數據的補充模型進行增強。

Ddog收集的原始數據是從五個攝像頭匯總而來的。每個攝像頭都可以提供灰度、魚眼、深度和紅外數據。手臂的夾持器內部還有第六個攝像頭,具有4K分辨率和LED功能,配合預訓練的TensorFlow模型檢測對象。

點雲由激光雷達數據以及由Ddog和手機的RGBD數據生成。數據采集完成後,通過單一坐標系進行歸一化處理,並與匯集所有成像和3D定位數據的全局狀態相匹配。

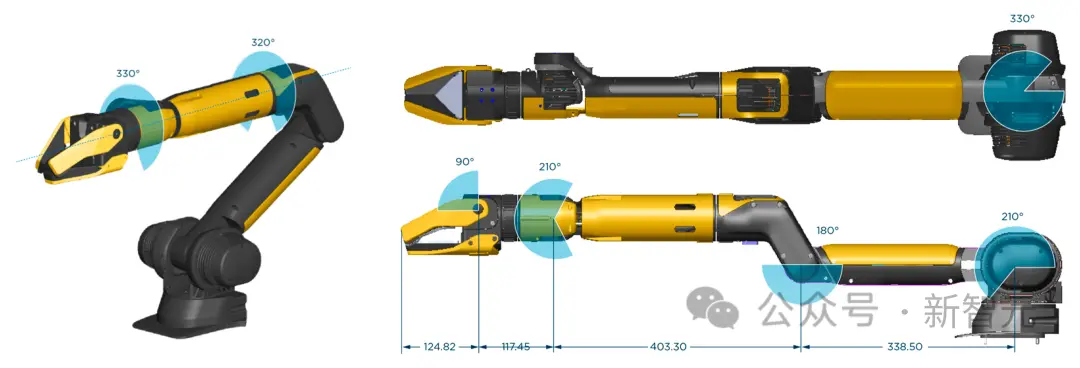

操作完全取決於安裝在 Ddog 上的機械臂夾持器的質量,下圖的夾具由波士頓動力公司制造。

實驗中將用例限制在與預定義位置中的對象進行基本交互。

作者繪制一個大的實驗室空間,將其設置為一個“公寓”,其中包含“廚房”區域(有一個裝有不同杯子和瓶子的托盤)、“客廳”區域(帶枕頭的小沙發和小咖啡桌), 和“窗口休息室”區域。

用例的數量在不斷增長,因此覆蓋大多數用例的唯一方法是部署一個系統以連續運行一段時間,並使用數據來優化此類序列和體驗。

AttentivU

腦電圖數據是從AttentivU設備收集的。AttentivU眼鏡的電極由天然銀制成,根據國際10-20電極放置系統,位於TP9和TP10位置。該眼鏡還包括位於鼻托的兩個EOG電極和一個位於Fpz位置的EEG參比電極。

這些傳感器可以提供所需的信息,並在需要時支持實時、閉環的幹預。

設備具有EEG和EOG兩種模式,可用於實時捕捉註意力、參與度、疲勞和認知負荷的信號。EEG已被用作清醒和睡眠之間過渡的神經生理學指標,

而EOG基於測量眼球運動過程中由於角膜-視網膜偶極子特性而誘導的生物電信號。研究表明,眼球運動與執行某些任務所需的記憶訪問類型相關,並且是視覺參與、註意力和嗜睡的良好衡量標準。

實驗

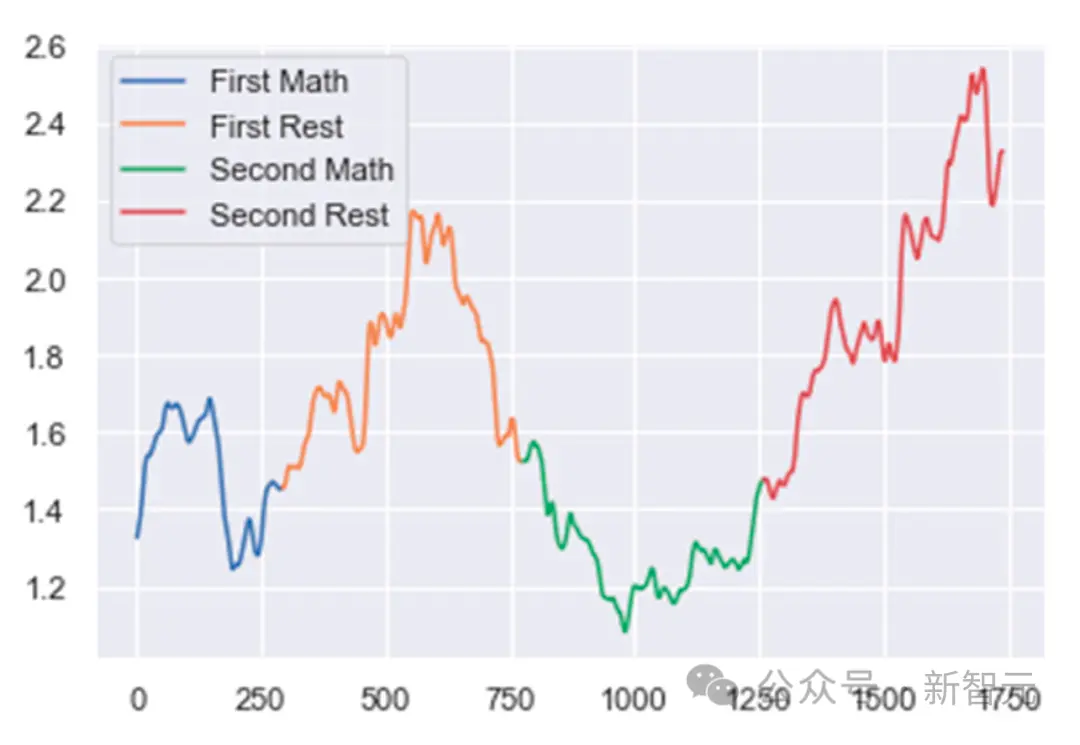

首先將腦電圖數據分成幾個窗口。將每個窗口定義為1秒長的EEG數據持續時間,與前一個窗口有75%的重疊。

然後是數據預處理和清理。使用50 Hz陷波濾波器和通帶為0.5 Hz至40 Hz的帶通濾波器的組合對數據進行濾波,以確保消除電力線噪聲和不需要的高頻。

接下來,作者創建偽影拒絕算法。如果兩個連續epoch之間的絕對功率差大於預定義的閾值,則拒絕某個epoch。

在分類的最後一步,作者混合使用不同的光譜波段功率比來跟蹤每個受試者基於任務的心理活動。對於 MA,該比率為(alpha/delta)。對於WA,該比值為(delta/low beta),對於ME,該比值為(delta/alpha)。

然後,使用變化點檢測算法來跟蹤這些比率的變化。這些比率的突然增加或減少表明用戶精神狀態發生變化。

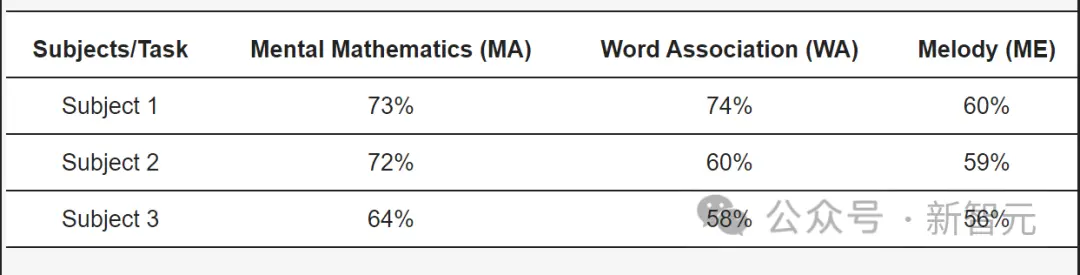

對於患有ALS的受試者,本文的模型在MA任務中達到73%的準確率,在WA任務中達到74%的準確率,在ME任務中達到60%的準確率。

參考資料:

https://www.therobotreport.com/ddog-mit-project-connects-brain-computer-interface-spot-robot/