Meta、OpenAI和微軟在本周三舉行的AMD投資者大會上,表示將使用AMD最新的人工智能芯片InstinctMI300X。此舉表明,科技界正在積極尋求昂貴的英偉達GPU的替代品。MI300X被業界寄予厚望,畢竟“天下苦英偉達久矣”,後者的旗艦GPU不僅價格高昂,而且供貨數量也相當有限。如果MI300X能夠得到大規模采用,有望降低開發人工智能模型的成本,對英偉達形成競爭壓力。

比英偉達的GPU快多少?

AMD表示,MI300X基於全新架構,性能有著顯著的提升。它的最大特點是擁有192GB的尖端高性能內存,即HBM3,這種內存傳輸數據的速度更快,可以容納更大的人工智能模型。

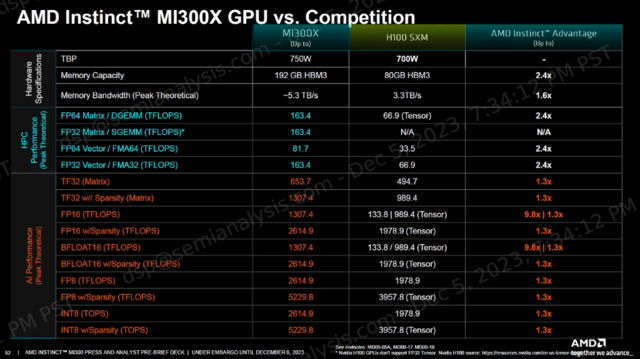

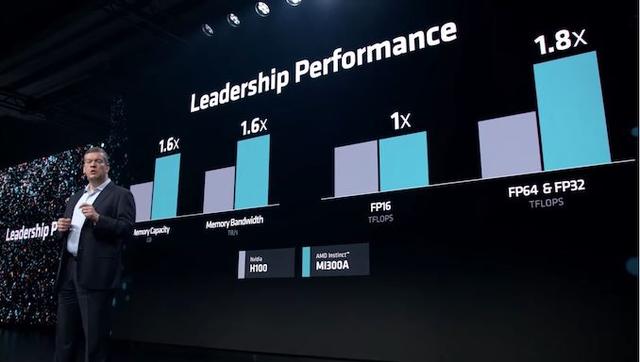

蘇姿豐直接將MI300X及其構建的系統與英偉達的(上代)旗艦GPU H100進行比較。

就基礎規格而言,MI300X的浮點運算速度比H100高30%,內存帶寬比H100高60%,內存容量更是H100的兩倍以上。

當然,MI300X對標的更多是英偉達最新的GPU H200,雖然規格上同樣領先,但MI300X對H200的優勢就沒那麼大,內存帶寬僅比後者多出個位數,容量比後者大近40%。

蘇姿豐認為:

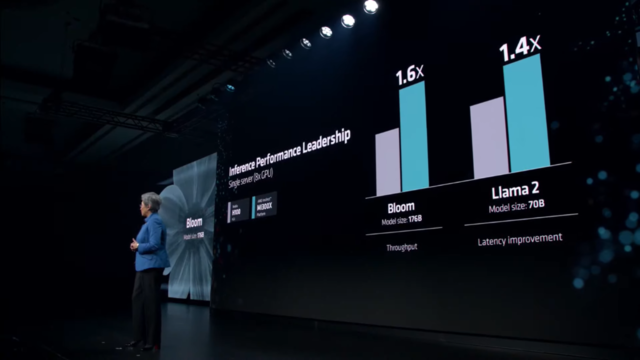

“這種性能可以直接轉化為更好的用戶體驗,當你向模型提問時,你希望它能更快地回答,尤其是當回答變得越來越復雜時。”

蘇姿豐:AMD不需要擊敗英偉達 第二名也可以過得很好

AMD面臨的主要問題是,那些一直依賴英偉達的公司是否會投入時間和金錢來增加另一傢GPU供應商。

蘇姿豐也承認,這些公司確實需要“付出努力”來轉向AMD芯片。

AMD周三告訴投資者和合作夥伴,公司已經改進對標英偉達CUDA的軟件套件ROCm。CUDA套件一直是AI開發者目前青睞英偉達的主要原因之一。

價格也很重要。AMD周三沒有透露MI300X的定價,但肯定會比英偉達的旗艦芯片更便宜,後者的單價在4萬美元左右。蘇姿豐表示,AMD的芯片必須比英偉達的購買和運營成本更低,才能說服客戶購買。

AMD還稱,已經和一些最需要GPU的大公司簽下MI300X的訂單。

Meta計劃把MI300XGPU用於人工智能推理任務,微軟首席技術官Kevin Scott也表示,公司會把MI300X部署在其雲計算服務Azure中,此外,甲骨文的雲計算服務也會使用MI300X。OpenAI也會在一款叫做Triton的軟件產品中使用AMD GPU.

根據研究公司Omidia的最新報告,Meta、微軟、甲骨文都是2023年英偉達H100 GPU的重要買傢。

AMD沒有給出MI300X的銷量預測,僅預計2024年數據中心GPU總收入約為20億美元。而英偉達僅最近一個季度的數據中心收入就超過140億美元,不過算上GPU之外的其他芯片。

展望未來,AMD認為,人工智能GPU的市場規模將攀升至4000億美元,比之前的預測翻一番。由此可見,人們對高端人工智能芯片的期望有多高、垂涎有多深。

蘇姿豐還對媒體坦然地說,AMD不需要擊敗英偉達,也能在市場上取得好成績。言下之意就是,第二名也可以活得很好。

她在談到AI芯片市場時表示:

“我認為可以明確地說,英偉達現在肯定是市場的領導者,我們相信,到2027年,這個市場的規模可能會達到4000多億美元。我們可以從中分得一杯羹。”