3月14日消息,零一萬物正式發佈Yi大模型API開放平臺,今天起為開發者提供通用Chat“Yi-34B-Chat-0205”、200k超長上下文“Yi-34B-Chat-200K”、多模態交互“Yi-VL-Plus”模型。

在全球多項權威評測榜單中,Yi 大模型表現優異,性能直追 GPT-4。此前,Yi 大模型 API已經小范圍開放內測,全球已有不少開發者申請使用,並普遍反饋效果超出預期。基於此,此次Yi 大模型 API 正式推出3款模型,給開發者更多驚喜。

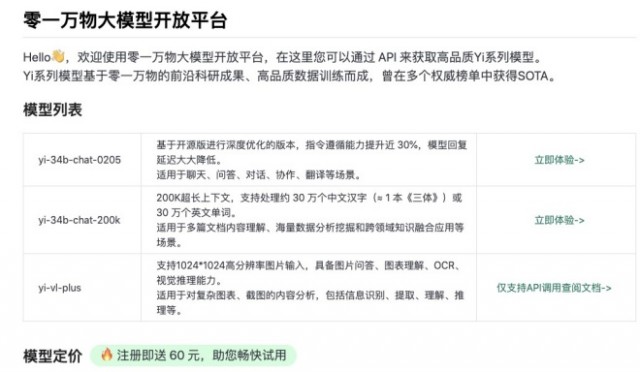

目前,Yi 大模型API名額限量開放中,新用戶贈送60元。Yi 大模型 API 與 OpenAI API 完全兼容,開發者隻需修改少量代碼,可以平滑遷移。

此次 Yi 大模型 API 開放平臺提供以下模型:

• Yi-34B-Chat-0205:支持通用聊天、問答、對話、寫作、翻譯等功能。

• Yi-34B-Chat-200K:200K 上下文,多文檔閱讀理解、超長知識庫構建小能手。

• Yi-VL-Plus: 多模態模型,支持文本、視覺多模態輸入,中文圖表體驗超過 GPT-4V。

零一萬物API開放平臺鏈接:https://platform.lingyiwanwu.com/

零一萬物Yi-34B-Chat-200K模型支持處理約 30 萬個中英文字符,適合用於多篇文檔內容理解、海量數據分析挖掘和跨領域知識融合等,在“大海撈針”測試中,Yi-34B-Chat-200K的性能提高10.5%,從89.3%提升到99.8%。

例如,金融分析師可以用Yi-34B-Chat-200K模型快速閱讀報告並預測市場趨勢、律師可以用它精準解讀法律條文、科研人員可以用它高效提取論文要點、文學愛好者可以用它快速掌握作品精髓等,應用場景非常廣泛。

Yi-34B-Chat-200K 對經典文學作品《呼嘯山莊》進行復雜角色和角色關系的歸納總結

零一萬物開發的多模態模型 Yi-VL-Plus,可支持文本、視覺多模態輸入,面向實際應用場景大幅增強,包括:

增強Charts, Table, Inforgraphics, Screenshot 識別能力,支持復雜圖表理解、信息提取、問答以及推理。中文圖表體驗超過GPT4V;

Yi-VL-Plus模型在一些中文圖表理解場景,比GPT-4V準確率更高

在 Yi-VL 基礎上進一步提高圖片分辨率,模型支持 1024*1024 分辨率輸入,顯著提高生產力場景中的文字、數字 OCR 的準確性;

保持 LLM 通用語言、知識、推理、指令跟隨等能力。

同時,零一萬物還表示,近期零一萬物將為開發者提供更多更強模型和 AI 開發框架,提供更加豐富和靈活的開發工具,以適應多樣化的應用場景。