過去幾個月裡,由ChatGPT引發的AI熱潮向人類展現通用語言模型的生產力前景。就在聊天機器人逐漸變成生產力工具之時,利用通用語言模型驅動真正的機器人也已經提上日程。本周老牌AI大廠谷歌與柏林工業大學的研究人員聯合發佈PaLM-E視覺語言模型,通過同時處理圖像和語言文本,解鎖人類與機器人交互的新篇章。

(預印本論文,來源:谷歌、柏林工業大學)

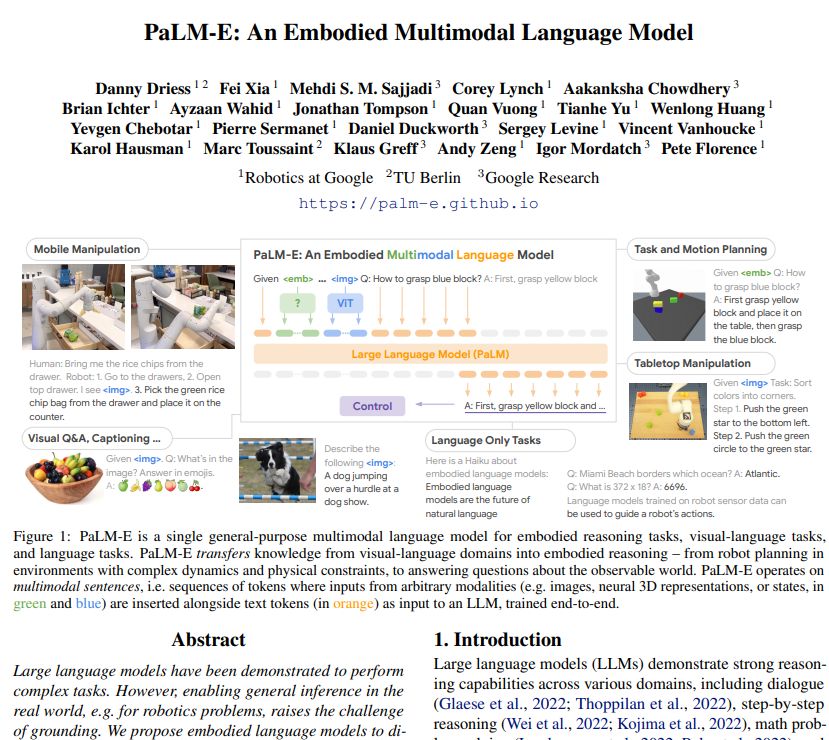

顧名思義,PaLM-E模型源自於谷歌的大型語言模型PaLM,E指的就是具象化(Embodied)。通過將通用語言模型與視覺轉換模型ViT相結合,PaLM-E成功實現讓AI同時具備“理解文字”和“讀懂圖片”的能力,不僅能夠輸出文字,還能輸出指令使得機器人的智能化躍上一個新的臺階。

研究人員介紹稱,PaLM和ViT的結合,使得PaLM-E的參數量最高可達5620億組,也是全球已知的最大視覺語言模型。

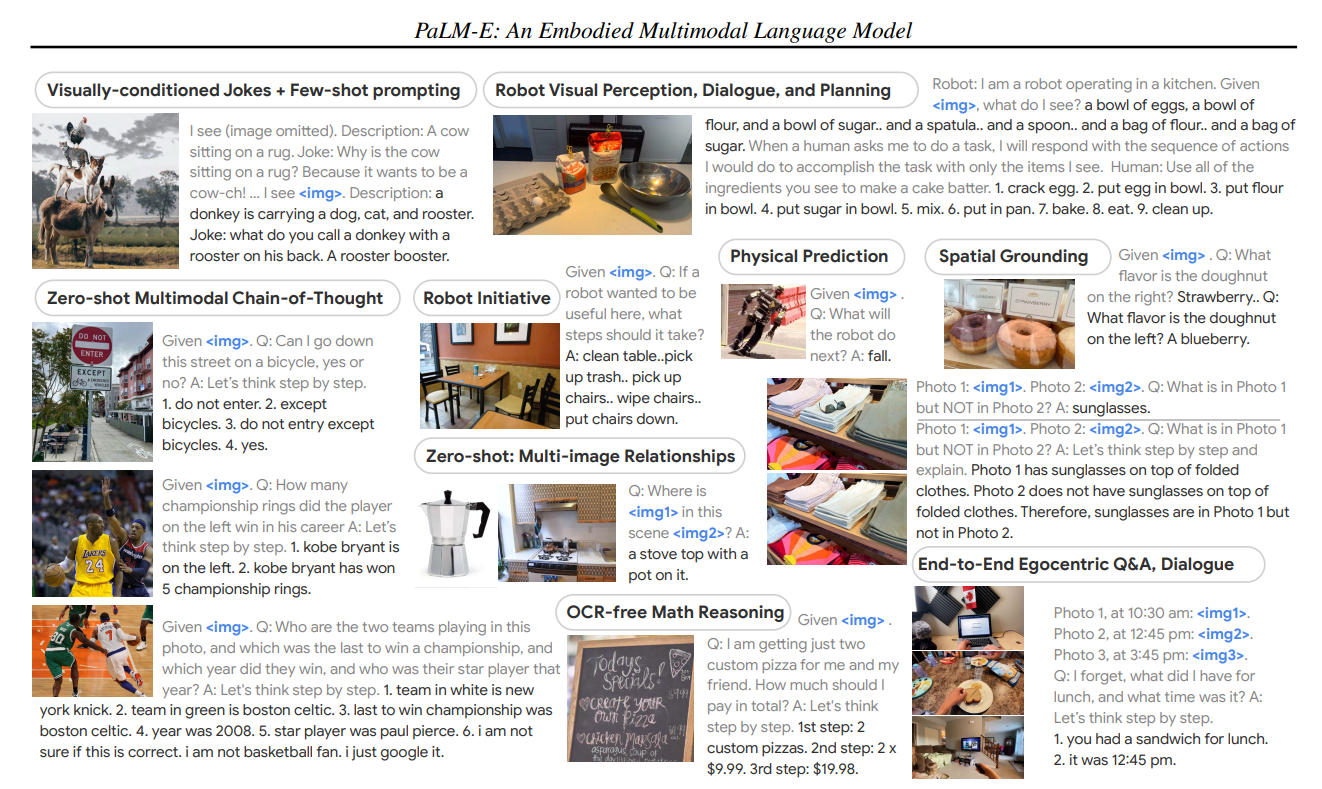

回歸到資本市場最關心的問題,這個聽上去很厲害的AI模型,到底能幹什麼事情呢?對此研究人員也給出一系列案例,幫助外界理解這個模型的妙處。

(PaLM-E模型的案例,來源:谷歌、柏林工業大學)

首先,具備視覺屬性的AI模型將擁有解讀圖片並進行思維推理的能力。例如可以通過一張禁行交通標志(除自行車外)的圖片,來解答“我能否在這條馬路上騎自行車”;通過OCR識別餐館的手寫菜單,能進行賬單的計算;或是通過識別一系列烘焙材料的照片,向機器人傳達“制作蛋糕胚”的流程。

在AI模型與機器人結合的實驗演示中,機器人得到“從抽屜裡拿出米餅”的指令後,能夠順利地從十多個開放式抽屜中找到米餅,拿給研究人員。

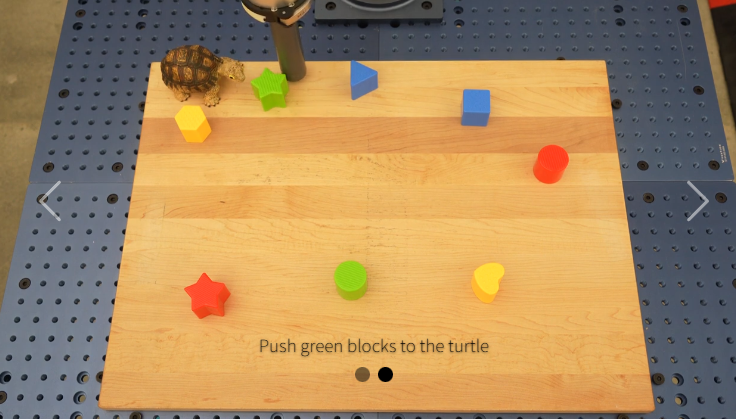

在後續的實驗中,研究人員還要求機器人“將所有色塊按顏色堆放到不同角落”的指令,以及將“綠色色塊推到烏龜旁邊”的指令,即便機器人之前沒有見過這隻烏龜擺件,也能順利地完成任務。

雖然從演示視頻中來看,受限於演示機器人較為簡單的設計,執行指令的時候仍顯得“笨手笨腳”。但隨著PaLM-E模型賦予機器思考如何執行人類指令的能力,工業應用和工業設計上的突破也指日可待。或許在不久的將來,就會出現一款風靡全球的智能機器人硬件。

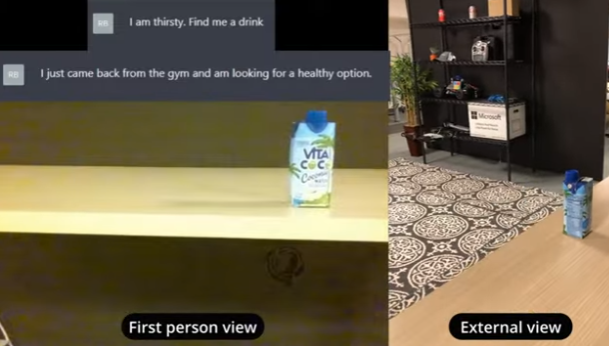

值得一提的是,作為AI大戰的老對手,微軟也已經在“圖像+語言模型”的路數上有所佈局。在今年2月底發表的研究中,微軟就展現如何使用ChatGPT為大疆Tello無人機編寫“找飲料”程序的案例。