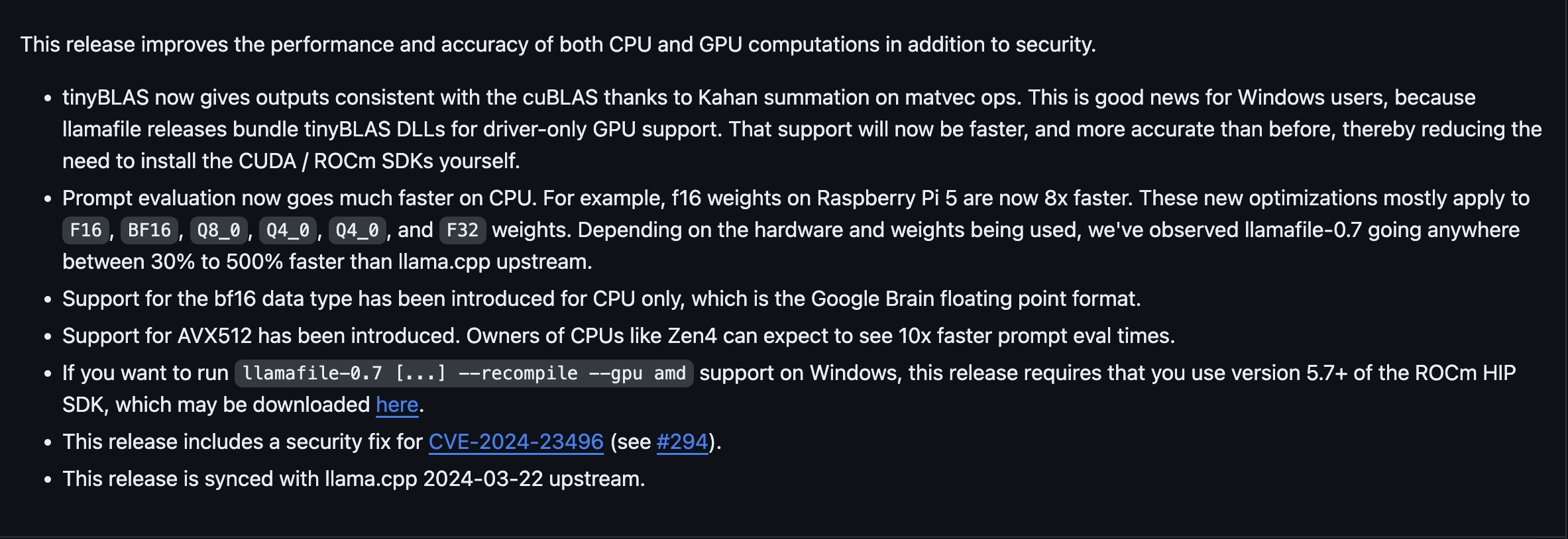

借助Llamafile的最新更新,在本地系統上運行龐大的LLM模型變得更容易,因為采用AVX-512的AMDRyzenCPU性能提升10倍。Phoronix報道稱,Llamafile的最新更新現在支持AVX-512指令集,使支持AVX-512的CPU在使用該軟件時性能得到大幅提升。

據悉,AMD 的 Zen 4"Ryzen"CPU 在使用新更新後,提示評估速度將提高十倍,最終使該工具的 LLM 性能更加高效。

對於不解 Llamafile 的人來說,它隻需部署一個可執行文件,將 LLM 模型與運行該模型所需的庫結合在一起即可。Mozilla Ocho 開發這一工具,旨在通過利用 CPU 和 GPU 的執行能力,讓更多人解 LLM。

不過,Llamafile的開發仍處於早期階段,因此還存在一些不準確的地方,我們相信一旦邊緣計算的發展勢頭強勁,這些問題很快就會得到解決。

你可以通過 GitHub 訪問最新版本。請註意,AMD 的 Ryzen CPU 是唯一支持 AVX-512 指令的消費級芯片,而英特爾已經放棄對它的支持,因為害怕這會影響其至強芯片的銷售。這使得 AMD 的 Ryzen 平臺對於希望運行 AVX-512 應用程序的用戶來說更具優勢。