我們知道Google目前對AI聊天機器人ChatGPT感到恐懼,但CNBC的一份報告提供有關這傢搜索巨頭顯然是如何組織其回應的新細節。據CNBC報道,Google員工目前正在測試他們自己的名為“ApprenticeBard”的AI聊天機器人,它可以像ChatGPT一樣使用自然語言回答問題。

Bard 是使用Google的 LAMDA 技術構建的,該技術本身類似於 ChatGPT 本身所依賴的 GPT 系列人工智能語言模型。 (Google過去曾使用 LaMDA 在 I/O 上為類似的聊天機器人演示提供支持,比如與 Pluto 的對話。)

據報道,Bard 相對於 ChatGPT 的一大優勢是它能夠談論最近發生的事件。 正如 OpenAI 警告的那樣,ChatGPT“對 2021 年後的世界和事件的解有限”,但 Bard 更及時,甚至能夠回答有關Google最近裁員的問題。

在內部流傳的一個例子中,一位測試人員詢問Bard,Google是否會進行另一輪裁員。 本月早些時候,該公司解雇 12000 名員工,占其員工總數的 6%。

“根據我的數據庫顯示,Google不太可能在 2023 年進行另一輪裁員,”回復中寫道。 “裁員通常是為降低成本和結構,但公司的財務狀況良好。 事實上,Google的收入在 2021 年增長 34%,公司股價自 2022 年 1 月以來上漲 70%。”

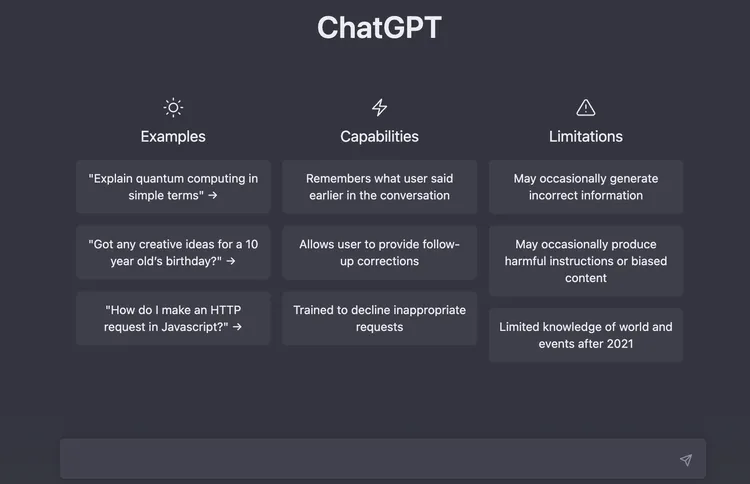

CNBC 表示,Google還在測試其主頁的替代版本,其中一個版本用潛在問題提示取代“手氣不錯”按鈕。 也許不出所料,這種設計聽起來類似於 ChatGPT 的主頁,它在搜索/對話框上方列出示例問題、功能和限制。

輸入問題後,搜索結果會在搜索欄正下方顯示一個灰色氣泡,提供比典型搜索結果更接近人類的回答。 在其正下方,該頁面提出與第一個問題相關的幾個後續問題。 在此之下,它顯示典型的搜索結果,包括鏈接和標題。

ChatGPT 主頁的屏幕截圖,顯示一個搜索欄,其上方的三列列出系統的“示例”、“功能”和“限制”。

當然,這隻是目前的早期報道,目前還不清楚Google將以何種形式回應 ChatGPT。 除 UI 決策之外,人工智能語言模型用於搜索的有效性也存在很大問題。 Google自己在 2021 年發表的論文中概述一些問題,其中包括這些系統傾向於復制社會偏見和成見,以及它們“幻覺”數據的頻率——將虛假信息呈現為真實。

盡管如此,由於該公司已針對 ChatGPT 的出現宣佈“Code Red”,因此可能會為趕上競爭對手而放棄諸如“真實性”之類的優點。