據TheInformation最新報道,OpenAI已經向一些客戶展示一種新的多模態人工智能模型,它既能與人對話,又能識別物體。該媒體援引未具名消息人士的話稱,這可能是該公司計劃在周一展示的內容的一部分。

據報道,與現有的獨立轉錄和文本到語音模型相比,新模型能更快、更準確地解讀圖像和音頻。它可以幫助客服人員"更好地理解來電者聲音的語調或他們是否在諷刺",而且"理論上",該模型可以幫助學生學習數學或翻譯現實世界中的標志。

該媒體的消息來源稱,該模型在"回答某些類型的問題"方面可以超越 GPT-4 Turbo,但仍然容易十分自信地輸出錯誤答案。

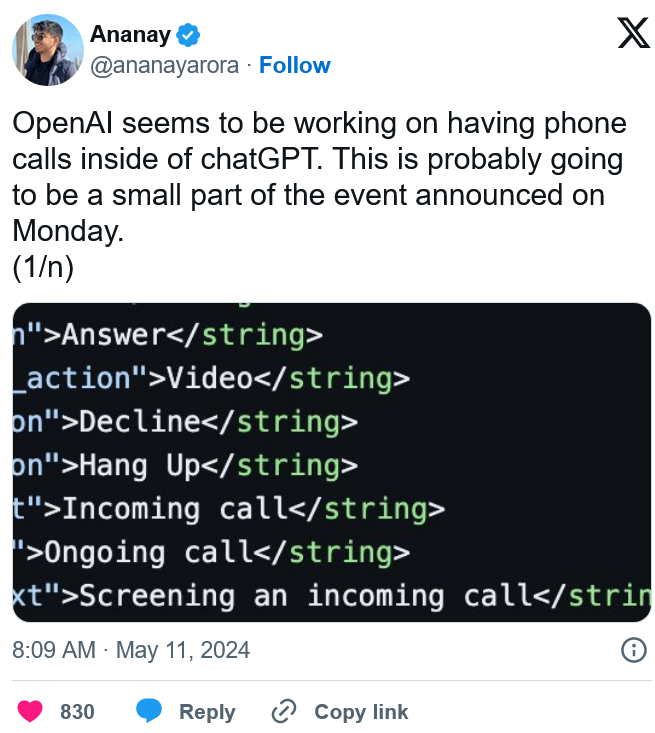

據開發者 Ananay Arora 稱,OpenAI 可能還在準備新的內置 ChatGPT 電話功能,他發佈上述與通話相關的代碼截圖。阿羅拉還發現有證據表明,OpenAI 已經為實時音頻和視頻通信配置服務器。

公司首席執行官山姆-奧特曼(Sam Altman)明確否認即將發佈的消息與這款據稱比 GPT-4"更好"的模型有關,傳聞中的GPT-5 可能會在今年年底公開發佈。

奧特曼還表示,公司不會宣佈新的人工智能搜索引擎。但如果《The Information》所報道的內容屬實,那麼Google的 I/O 開發者大會仍有可能因此受到影響。Google一直在測試使用人工智能打電話。傳聞中的一個項目是多模態Google助手的替代品"Pixie",它可以通過設備的攝像頭觀察物體,並提供購買建議或使用說明。

OpenAI 計劃於周一上午 10 點(太平洋時間)/下午 1 點(美國東部時間)在其網站上通過現場直播的方式發佈新服務。