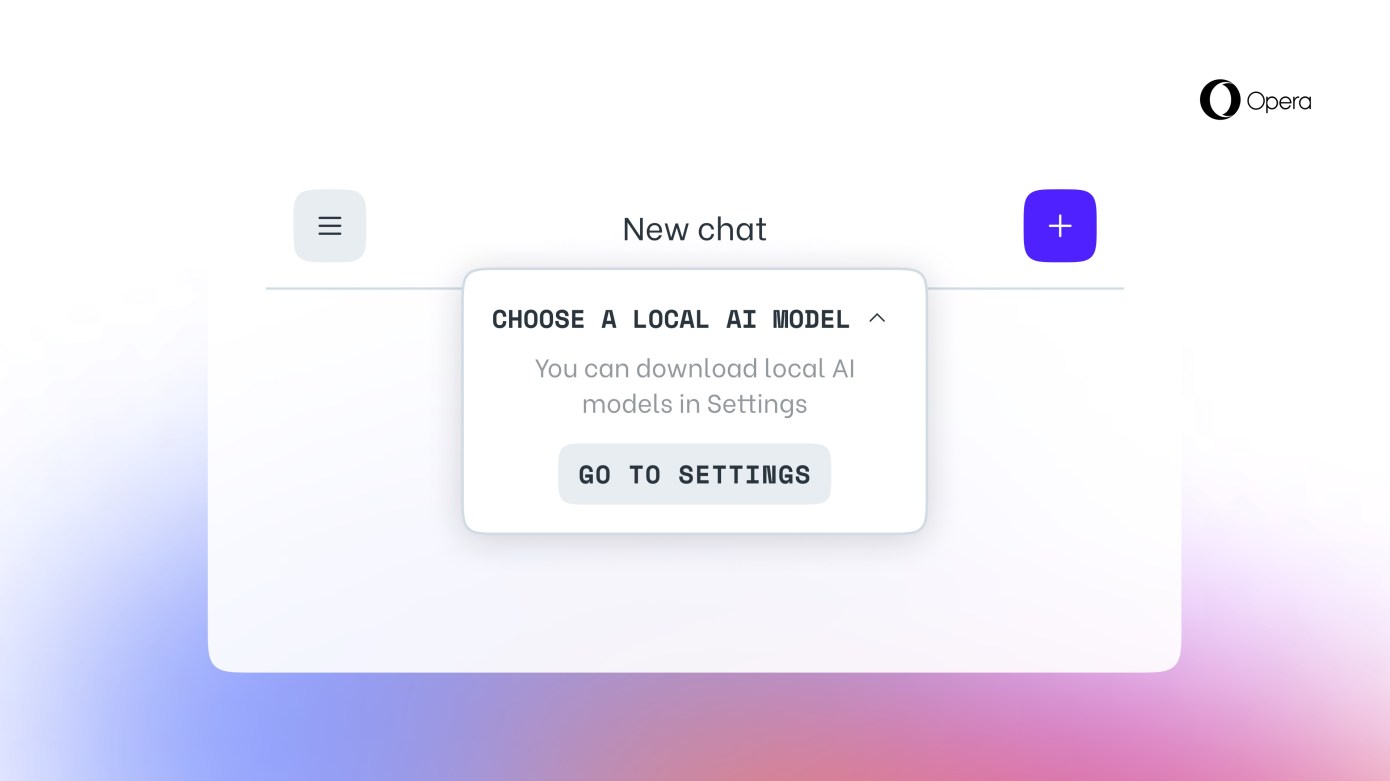

網絡瀏覽器公司Opera今天宣佈,現在用戶可以在電腦上下載和使用大型語言模型(LLM)。該功能將首先向獲得開發者流更新的OperaOne用戶推出,用戶可以從50多個系列的150多個模型中進行選擇。

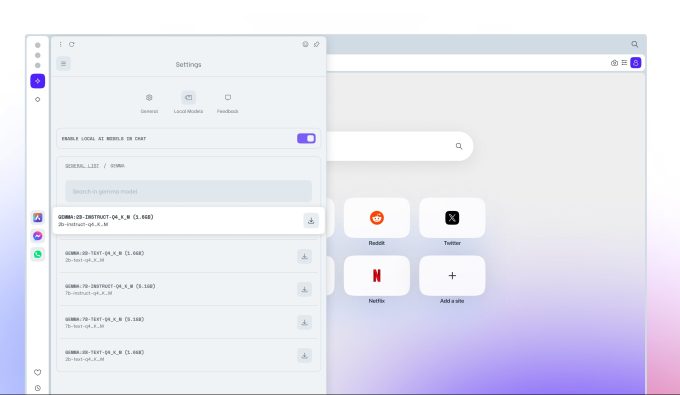

這些模型包括 Meta 的 Llama、Google 的 Gemma 和 Vicuna。該功能將作為 Opera 人工智能功能發佈計劃的一部分提供給用戶,讓用戶提前使用部分人工智能功能。

該公司表示,它在瀏覽器中使用 Ollama 開放源碼框架在計算機上運行這些模型。目前,所有可用的模型都是 Ollama 庫的子集,但該公司希望將來能加入不同來源的模型。

該公司提到,每個變體都會占用本地系統超過 2GB 的空間。因此應該謹慎使用可用空間,以免存儲空間耗盡。值得註意的是,Opera 在下載模型時不會做任何節省存儲空間的工作。

"Opera現在首次在瀏覽器中直接提供大量第三方本地LLM。"Opera 副總裁 Jan Standal 在一份聲明中表示:"隨著第三方本地 LLM 越來越專業,預計它們的規模可能會縮小。"

如果用戶計劃在本地測試各種模型,這項功能會很有用,但如果想節省空間,也可以使用Quora's Poe和HuggingChat等大量在線工具來探索不同的模型。

自去年以來,Opera 一直在嘗試人工智能功能。去年 5 月,該公司在側邊欄推出一款名為 Aria 的助手,並於8 月將其引入 iOS 版本。今年 1 月,Opera 表示,由於歐盟數字市場法案(DMA)要求蘋果放棄對移動瀏覽器 WebKit 引擎的強制要求,該公司正在為 iOS 構建一款自帶引擎的人工智能瀏覽器。