微軟推出其輕量級人工智能模型Phi-3Mini的下一個版本,這是該公司計劃發佈的三款小型模型中的第一款。Phi-3Mini可測量38億個參數,其訓練數據集比GPT-4等大型語言模型要小。它現在可在Azure、HuggingFace和Ollama上使用。微軟計劃發佈Phi-3Small(7B參數)和Phi-3Medium(14B參數)。參數指的是模型能理解多少復雜指令。

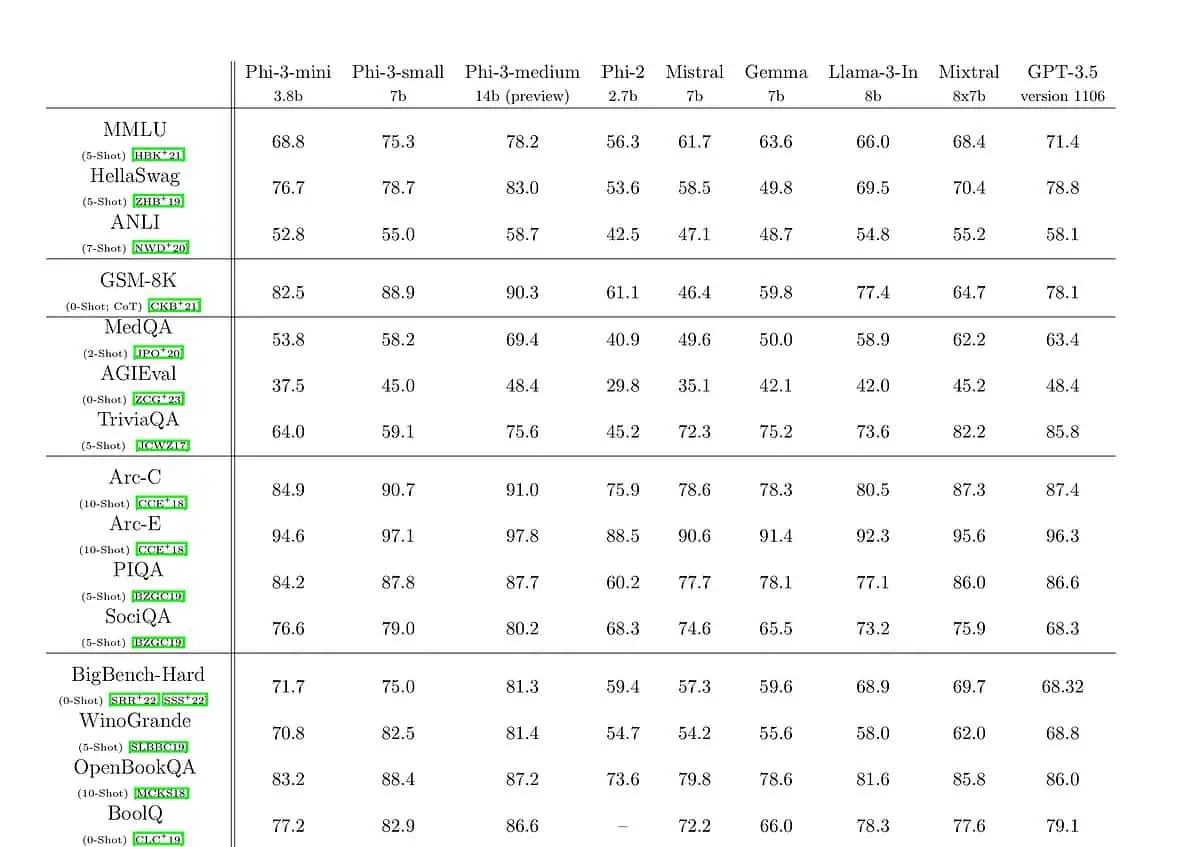

該公司於 12 月發佈 Phi-2,其性能與 Llama 2 等更大的型號不相上下。微軟表示,Phi-3 的性能比前一版本更好,其響應速度接近比它大 10 倍的機型。

微軟Azure人工智能平臺公司副總裁埃裡克-博伊德(Eric Boyd)介紹說,Phi-3 Mini的性能與GPT-3.5等LLM不相上下,"隻是外形尺寸更小而已"。

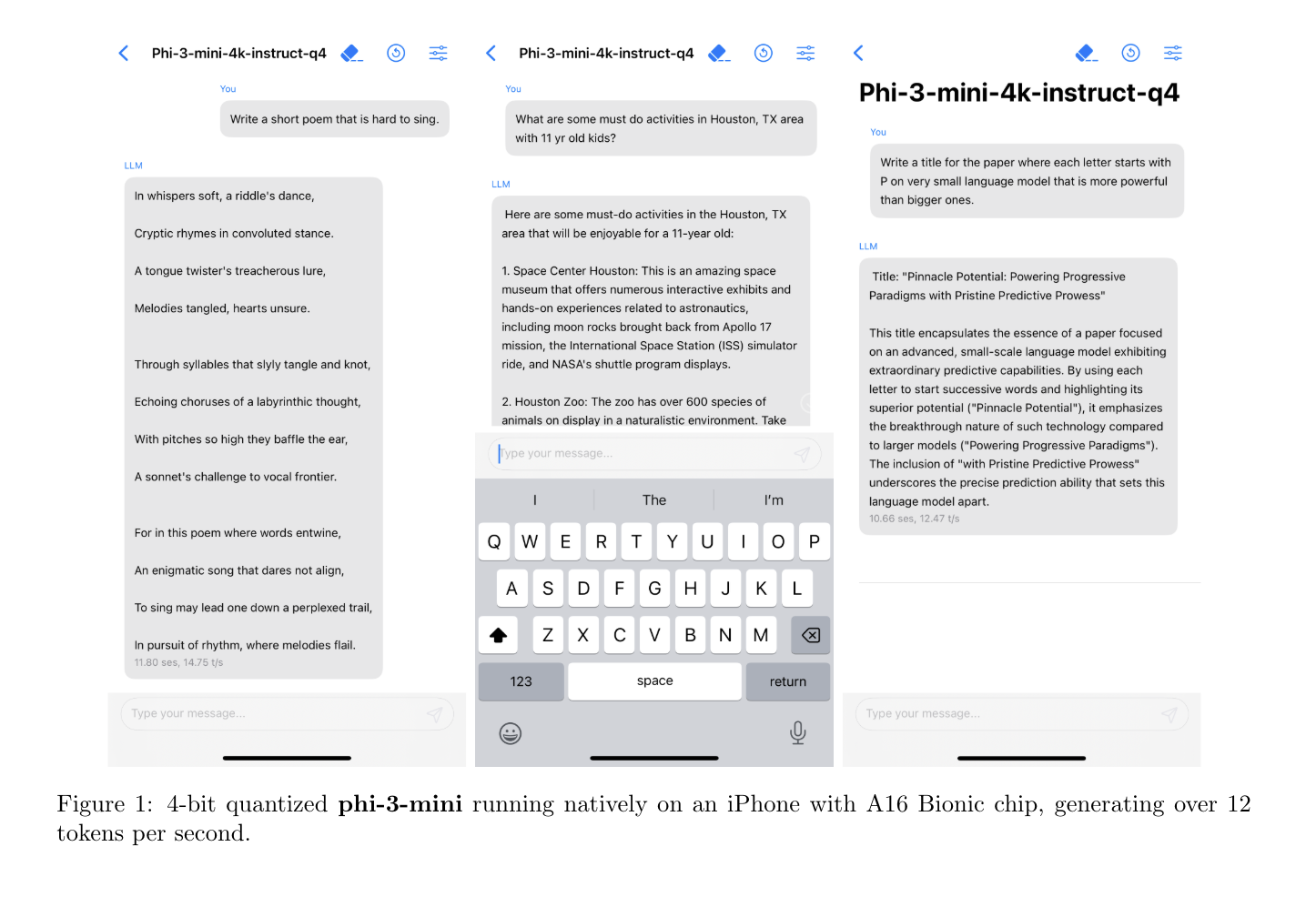

與體積較大的同類,小型人工智能模型的運行成本通常更低,在手機和筆記本電腦等個人。據 The Information今年早些時候報道,微軟正在組建一個專門研究輕量級人工智能模型的團隊。 除 Phi,該公司還建立一個專註於解決數學問題的模型Orca-Math。

微軟的競爭對手也有自己的小型人工智能模型,它們大多針對文檔摘要或編碼輔助等較簡單的任務。Google的 Gemma 2B 和 7B適合簡單的聊天機器人和語言相關工作。Anthropic 的 Claude 3 Haiku可以閱讀帶圖表的高密度研究論文並快速總結,而Meta 最近發佈的 Llama 3 8B可能會用於一些聊天機器人和編碼輔助工作。

博伊德說,開發人員用"課程"來訓練 Phi-3。他們的靈感來自於兒童是如何從睡前故事、單詞較簡單的書籍以及談論較大主題的句子結構中學習的。

Phi-3 隻是在前幾個迭代學習的基礎上更進一步。Phi-1 專註於編碼,Phi-2 開始學習推理,而 Phi-3 則更擅長編碼和推理。雖然Phi-3系列模型知道一些常識,但它在廣度上無法擊敗GPT-4或其他LLM--從一個在整個互聯網上接受過訓練的LLM和一個像Phi-3這樣的小型模型中得到的答案差別很大。

Boyd 說,公司經常發現,像 Phi-3 這樣的小型機型更適合他們的定制應用,因為對於很多公司來說,他們的內部數據集無論如何都會偏小。而且,由於這些型號使用的計算能力較低,它們的價格往往要低得多。