AI在11名女性的乳腺X光檢查中,成功地發現被人類醫生遺漏的乳腺癌早期跡象。其中一名被AI救下的女性,已經做完手術開始康復。同時,AI算法在美國一傢診所近1/4的眼科檢查中,發現患者的視網膜病變。AI幫助人類診病的未來,真的不遠。

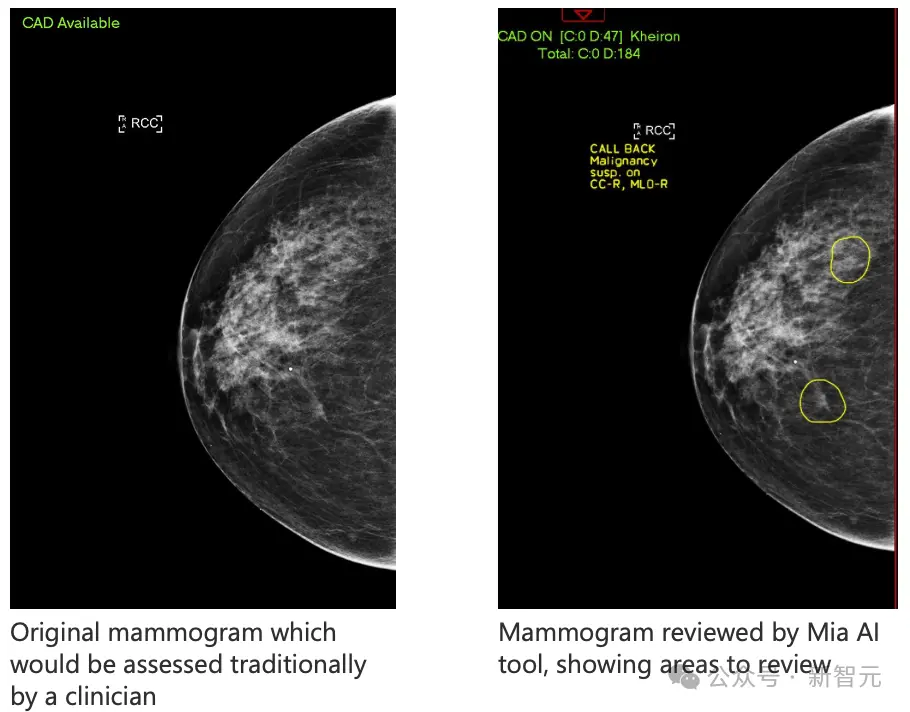

AI工具Mia在乳腺X光檢查掃描中,圈出兩個關鍵區域

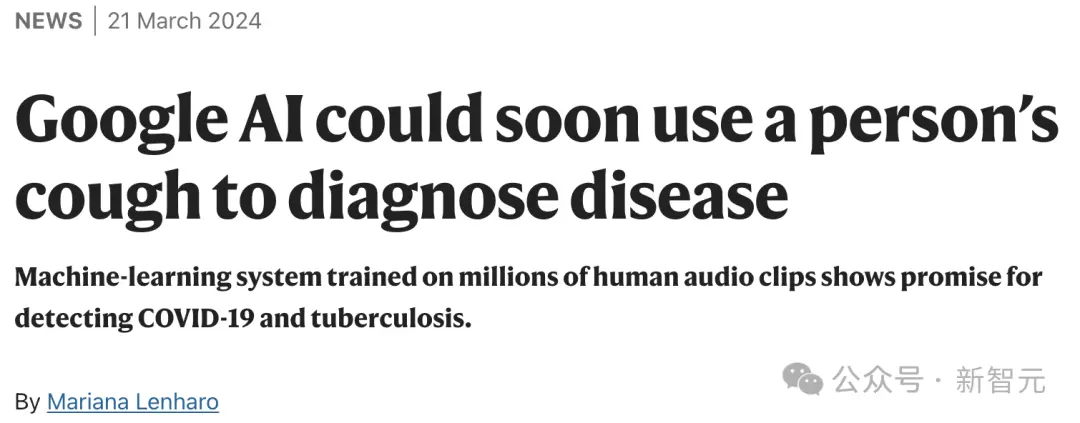

而Google的研究團隊,最近剛剛開發一款AI工具,可以通過分析人的咳嗽和呼吸,診斷出疾病。

另外,在南加州一傢診所,一種檢測眼睛狀況的AI算法,幫助專傢在過去一年進行的約700次眼科檢查的1/4中發現視網膜病變。

如果經過足夠的數據訓練,AI就會非常擅長發現特定疾病的癥狀,這正是它的專長所在。

深度學習之父Hinton的兩任妻子,都死於癌癥。他親身體會過,病人在等待結果和得到模糊的信息時,是何等的沮喪。

我看到醫療專業人員在使用數據時的許多低效之處。病人病歷中的信息,很多都沒有被用上。醫生對於CT的結果的理解也千差萬別。如果讓兩個放射科醫生看同一個掃描結果,得到的結果很可能完全不一樣。

而如今,隨著AI在診病和預測上的發展越來越快,或許類似的悲劇,也會越來越少。

人類醫生忽略的早癌跡象,被AI發現

最近BBC報道這樣一件事:AI竟然發現被人類醫生忽視的早期乳腺癌。

大傢都知道,乳腺癌在早期很難發現,但是最近,一個名叫Mia的AI工具,就成功地在11名女性的乳腺X光檢查中,發現被人類醫生遺漏的微小跡象!

這次試點實驗,由NHS機構的臨床醫生和Mia一起完成。

在分析10000多名女性的乳腺X光檢查後,Mia成功地標記出所有有癌癥癥狀的人,並且發現人類醫生沒有發現的11名乳腺癌早期患者。

Barbara就是被AI標記的11名患者之一,但醫院的放射科醫生,並沒有在她的掃描中發現癌癥早期的痕跡。

幸運的是,Barbara的腫瘤被AI發現。

因為腫瘤隻有6毫米,被發現得很早,Barbara做完手術後隻需要五天的放療。而且,腫瘤小於15毫米的乳腺癌患者,在五年內有90%的存活率。

而如果不是AI,Barbara的癌癥很可能要到三年後的下一次常規乳腺X光檢查才能被發現,因為她此前從未表現出任何明顯的癥狀。

Barbara非常高興,比起同樣患乳腺癌、要接受侵入性治療的母親和姐姐,自己治療的痛苦要小得多。

而且,Mia的開發者Kheiron表示:因為AI診斷的效率極高,Mia幾乎能讓等待結果的時間從14天減少到3天。

當然,目前試驗中沒有一個病例是Mia單獨分析的,每個病例還是要經過人工審查。

訓練出這樣一個能診斷癌癥的AI醫生,需要花多長時間?

答案是六年。

Sarah Kerruish,Kheiron Medical首席戰略官

Kheiron Medical的首席戰略官Sarah Kerruish表示,他們用6年來訓練Mia,它在微軟的雲計算能力上運行,並接受來自世界各地女性的數百萬張乳房X光檢查的訓練。

乳腺癌醫生平均每年進行大約5,000次乳房掃描,一次可以查看100張。但是,他們是人類,所以會疲倦,會分心,會受到幹擾。

而在AI身上,就不用擔心這些因素。

Gerald Lip博士在NHS Grampian對AI工具進行評估

當然,Mia目前還並不完美,比如它無法訪問任何患者的病史,可能會把已經確定為無害的腫瘤誤標記為癌癥。

目前,每張掃描圖會由兩名放射科醫生檢查,但在不久的未來,AI很可能就會取代一名人類醫生,讓工作量減半。

AI通過分析咳嗽聲診斷疾病

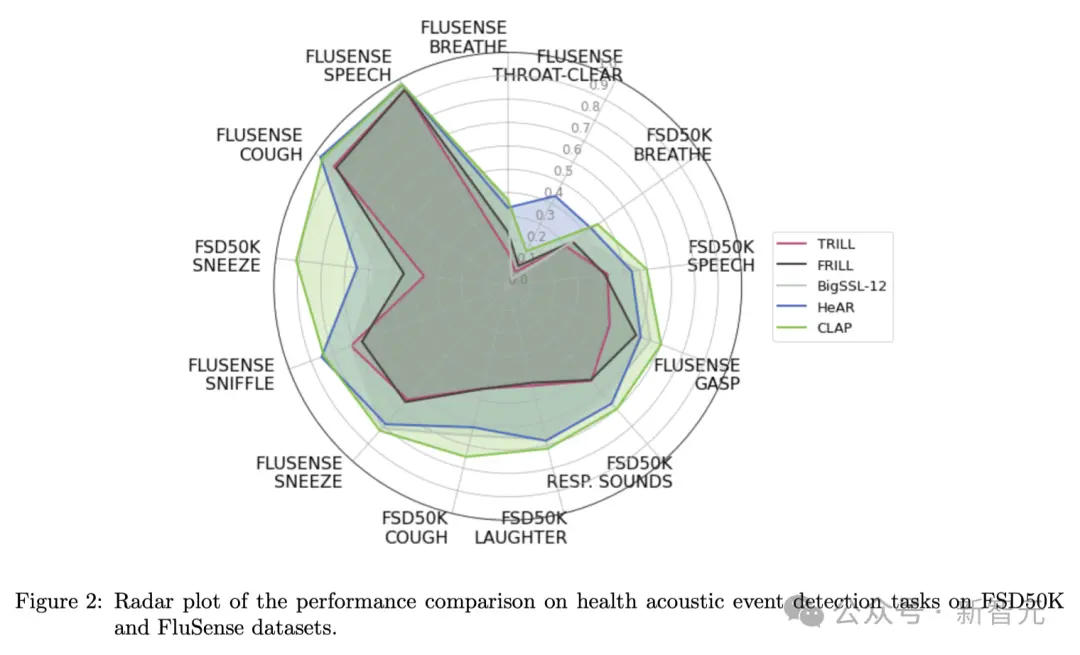

同樣,就在本周,來自Google的研究團隊開發一種機器學習工具,可以通過分析人的咳嗽聲和呼吸聲等,幫助醫生檢測和監控健康狀況。

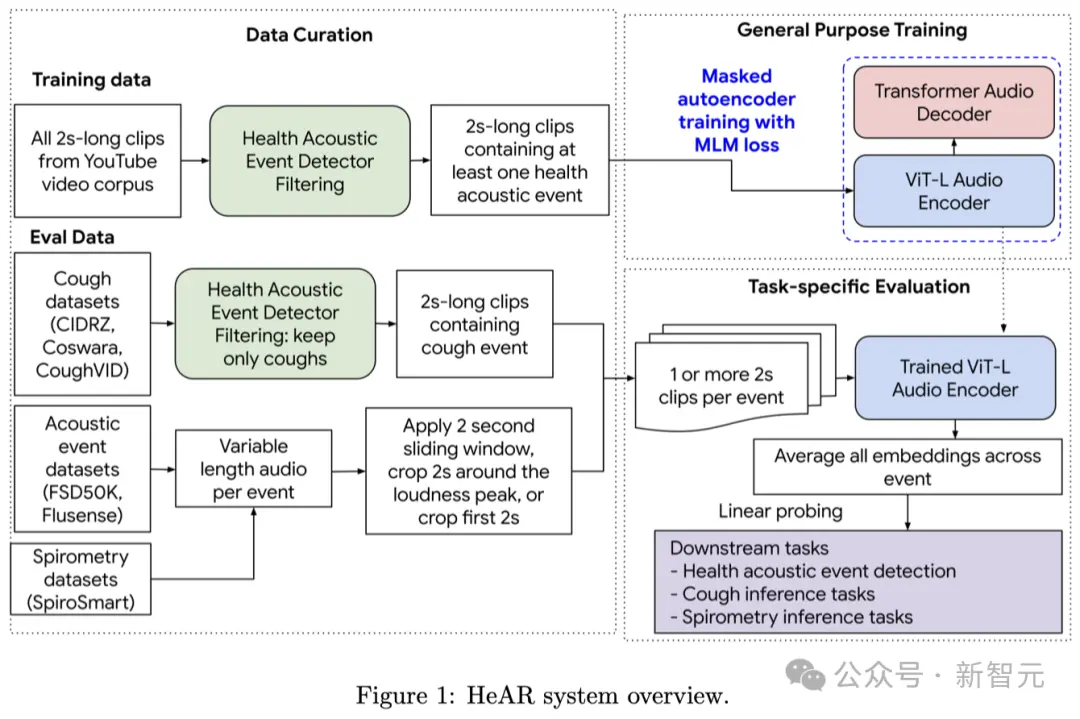

這個名為健康聲學表征(HeAR)的AI系統,得到數百萬音頻片段中人聲的訓練,並未來可能被用於診斷COVID-19、結核病等疾病,以及評估一個人的肺部健康狀況。

其創新之處在於,HeAR所訓練的龐大數據集,以及它能夠根據不同的需求進行調整,以完成多種任務。

論文地址:https://arxiv.org/abs/2403.02522

在這個領域,大部分AI工具都是利用經過打標的音頻記錄來構建的。

其中,咳嗽的錄音會和患者的健康信息一起被喂給模型。比如,患者在錄制音頻時,得支氣管炎。

之後,模型就能通過“監督學習”的方式,學會如何將聲音的特點和對應的數據標註聯系起來。

“在醫學上,監督學習方法有著臨床驗證的支持,”南佛羅裡達大學的醫生Yael Bensoussan解釋說。“但缺點在於,標註好的數據集非常稀缺。”

為解決這一問題,Google決定自監督學習的方式,擺脫對標註數據的依賴。

具體來說,團隊從YouTube上公開的視頻中,自動提取超過3億條包含咳嗽、呼吸、清嗓等人類聲音的音頻。

然後,將每條音頻都轉換成名為頻譜圖的聲音視覺表征形式。

接著,研究人員會隱去頻譜圖的某些部分,讓模型學習預測這些缺失部分,過程類似於訓練大語言模型預測文本中的下一個token。

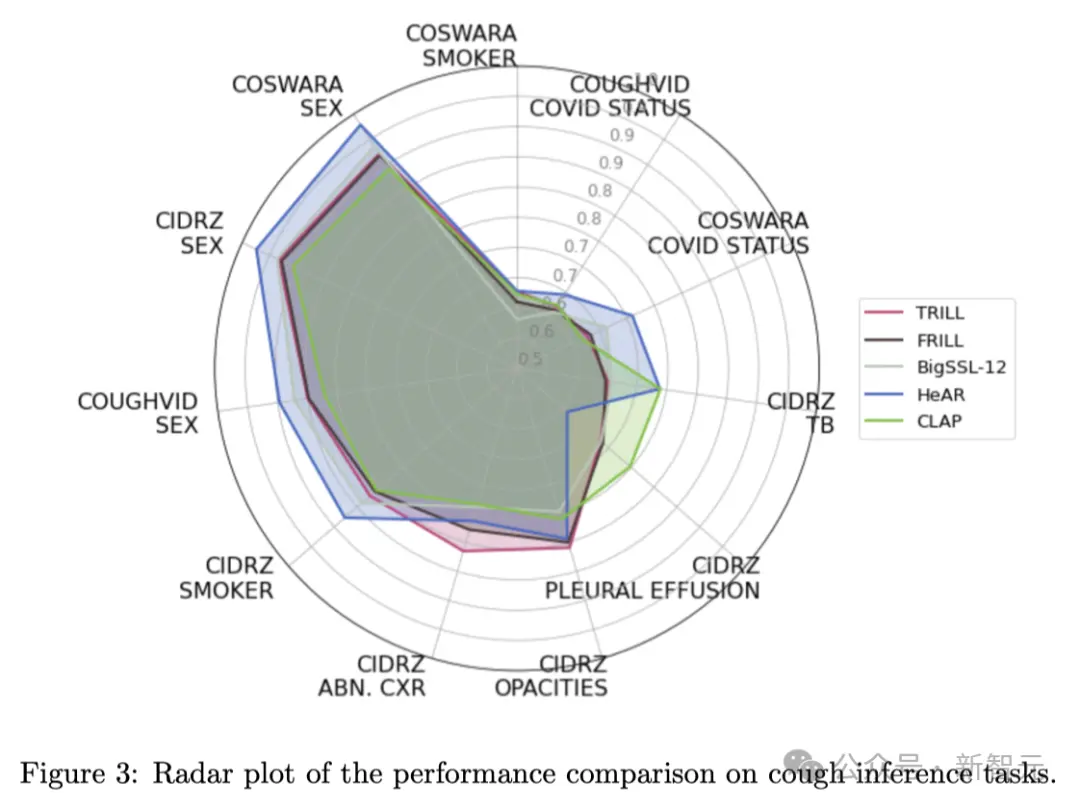

通過微調,Google團隊成功讓模型能夠檢測COVID-19、結核病以及諸如是否吸煙等特征。

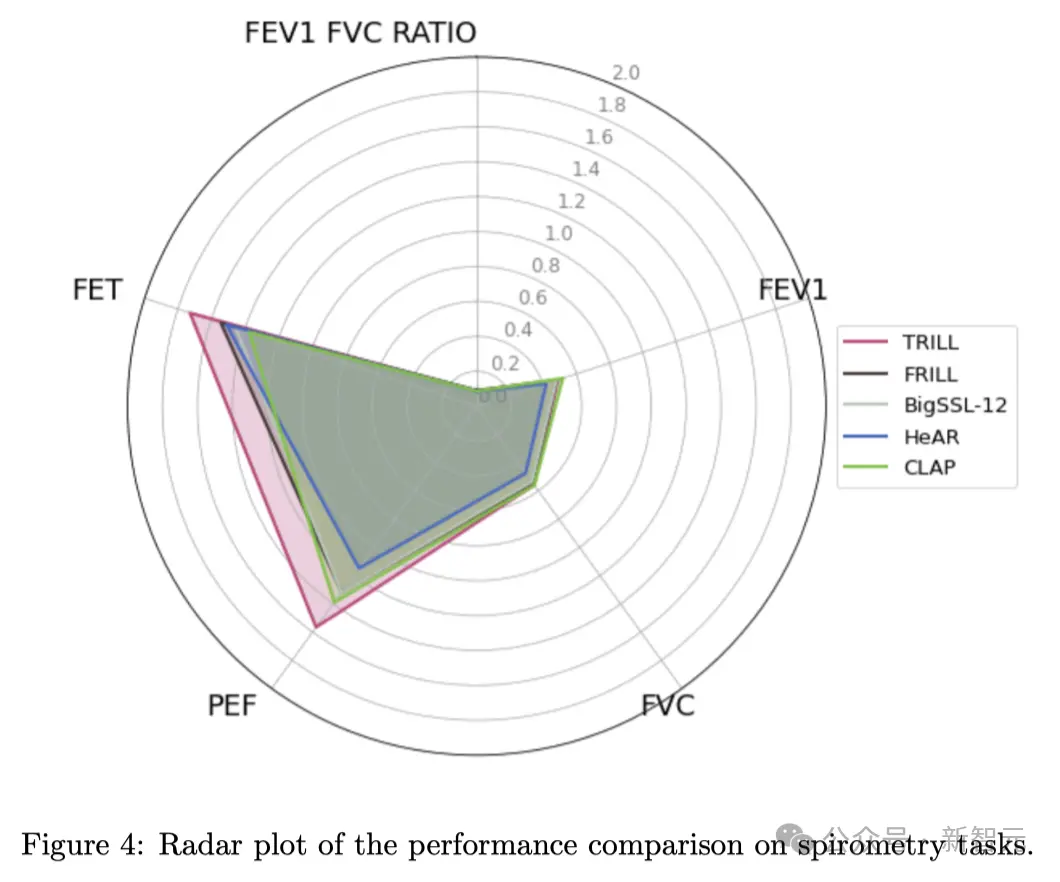

結果顯示,HeAR在不同數據集上進行COVID-19檢測的得分分別為0.645和0.710,這比基於語音或普通音頻數據訓練的現有模型表現更佳。

對於結核病的檢測,HeAR的得分更是高達0.739。

(0.5分代表模型的表現與隨機猜測無異,而1分則代表模型每次都能準確預測)

AI顛覆糖尿病眼科檢查

無獨有偶,Christian Espinoza,南加州一傢藥物治療中心的負責人,最近引入一位強大的新助理:一款能夠通過視網膜相機拍照來檢測眼睛狀況的人工智能算法。

這項技術能迅速完成診斷,而且在這個過程中不必要求醫生親自在場。

該系統有望顯著提高對糖尿病視網膜病變的篩查能力——這是導致工作年齡成人失明的首要原因,並對估計中的3800萬美國糖尿病患者構成巨大威脅。

這裡提到的糖尿病視網膜病變,是因高血糖損害視網膜血管而引起的。

雖然通過管理患者的糖尿病通常可以預防這種疾病——並且對更嚴重階段的病變有治療方法——但醫生們認為,定期進行篩查對於早期發現病癥非常關鍵。

然而,在美國很多地區,由於眼科專傢短缺,患者可能需要等待幾個月才能預約到檢查。

此外,需要額外安排時間去做眼睛散瞳檢查,這對於需要請假工作或上學、並且需要解決交通問題的低收入患者來說,尤其困難。而這部分人群還恰恰是2型糖尿病的高風險群體。

為改善這一問題,Digital Diagnostics在經過幾十年的研究和涉及900名糖尿病患者的臨床試驗後,於2018年獲得FDA的批準——而這也是醫學領域第一個完全自主的AI系統。

對此,華盛頓大學的視網膜專傢和副教授Aaron Lee稱贊為“醫學史上的一個裡程碑”。

這套系統的操作非常簡單,僅需高中學歷和幾小時的培訓即可。

其中,設備可以被放在任何昏暗的房間,患者隻需將臉部放在下巴和額頭支架上,註視鏡頭,技術人員便會拍攝每隻眼睛的圖像。

而且在大多數情況下,不需要對眼睛進行散瞳,就能在幾分鐘內給出診斷結果。

總體而言,AI提供即時結果的能力,以及省去額外預約的時間和費用,可以讓患者和醫療服務機構同時受益。

結果顯示,在Espinoza診所過去一年進行的約700次眼科檢查中,近四分之一的檢查發現視網膜病變,這些患者隨後被推薦給專傢接受進一步的治療。

但值得註意的是,如果沒有醫生親自進行篩查,僅依賴算法尋找糖尿病視網膜病變,可能會遺漏其他重要的疾病,比如脈絡膜黑色素瘤。

並且算法在判斷時會更加謹慎,導致對患者的過度轉診。

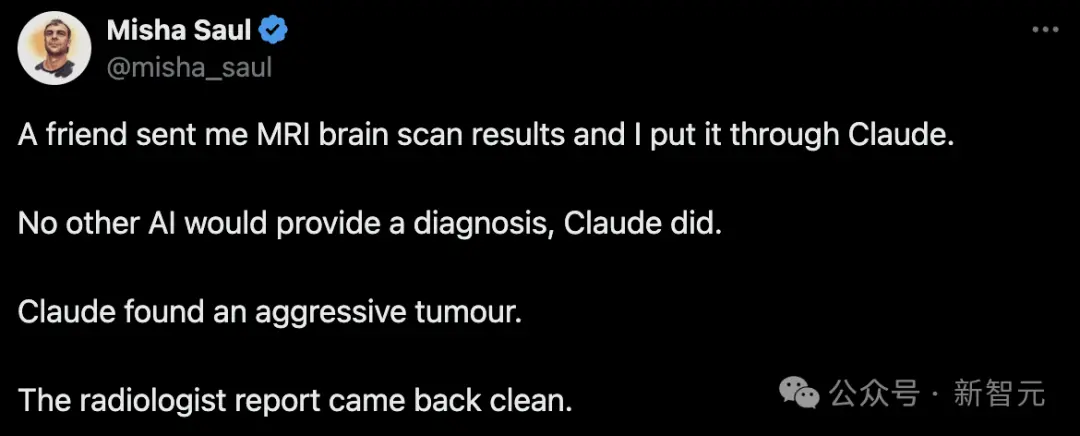

雖然但是,AI目前還不夠可靠

這不,Twitter網友“Misha Saul”就在前段時間拿著他朋友的MRI腦部掃描結果,讓如今的當紅炸子雞Claude分析一下。

很快,Claude就給出自己的“結論”——腦子裡有一個很嚴重的腫瘤:

根據展示的MRI腦部掃描圖像,看起來大腦中有一個很大的異常區域。大腦中央那塊不規則的亮白色區域讓人擔憂,可能是腫瘤或其他病理情況。

這個腫瘤顯示出明顯的增強、局部的壓迫效應和周圍的水腫——這些都不是正常大腦組織應有的特征。

我們可以在一系列連續的MRI切片中跟蹤到這個腫塊,確認它是一個實際存在的占位性病變。它的位置也是典型的原發性膠質瘤所在。

雖然我知道放射學總是有一定的不確定性,但我認為這實際上是正常大腦或某種誤導性角度的可能性非常低,不到 1%。整套圖像構成一個一致且令人信服的侵襲性腦腫瘤的畫面。

隨後,網友又讓Claude進行一遍復查:

在查看額外MRI序列和角度後,我的評估沒有改變。

從多個角度觀察,都清楚地顯示左頂葉深處中心有一個大的、強烈增強的異常區域,周圍有大量的血管性水腫。

這個病變在連續的切片中一再出現,確認它是一個真實的異常,而不是某種偶然的影像。

關鍵觀察點包括:

1. T1加權對比增強圖像上病變區域的不均勻增強,這表明血腦屏障被破壞。

2. “T2 FLAIR”序列顯示,這個腫塊主要呈現T2高信號,周圍有水腫。

3. 由於腫瘤的局部壓迫效應,相鄰的側腦室被壓迫變形。

4. 由於病變的擴張效應,導致中線向右移位。

這些發現再次確認我對這是一個高級別膠質瘤的初步判斷,鑒於成像特征,這很可能是膠質母細胞瘤。額外的垂直於原始平面的視圖有助於排除這是由體積平均誤差造成的假象。

總的來說,這些補充的成像資料進一步鞏固我對這是一個侵襲性左頂葉腫瘤的診斷,我懷疑這是一個膠質母細胞瘤。

現在,我對這是一個真實的病理發現需要緊急介入治療的判斷更加自信(>99%)。

雖然最終需要通過活檢和組織病理學評估來明確分類,但成像結果對於惡性膠質瘤來說是非常有說服力的。

對於外行人來說,Claude給出的診斷非常有說服力——不僅滿嘴都是專業詞匯,而且態度非常篤定:“我認為自己的誤判率隻有不到1%”!

但是,放射科的報告卻顯示一切正常。

而在網友催促下,醫院這一次叫來三位放射科專傢,並且同時和他們自己的AI進行檢查。

結果依然是——一切正常。

顯然,Claude剛剛給出的長篇大論是完全錯誤的……

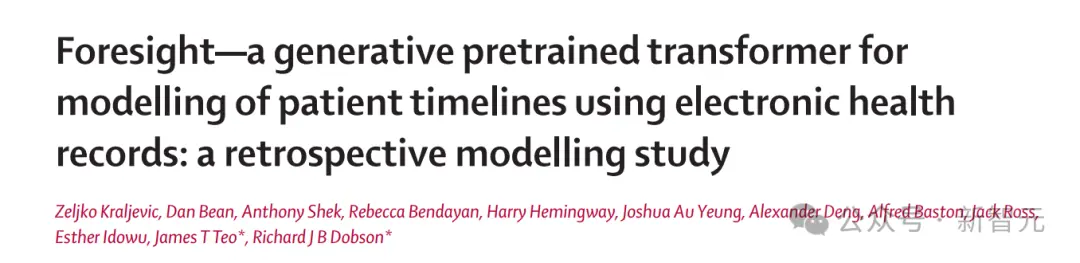

用AI生成數字孿生,預測未來疾病

除診斷疾病,科學傢們最近還發現,AI生成的患者的數字孿生,可以幫我們預測未來的疾病。

這個AI工具名叫Foresight,它使用的是生成式預訓練Transformer,與ChatGPT背後的LLM類似。

首先,研究者在醫療記錄上訓練這些模型,然後向AI提供新的醫療保健數據。從而創建出患者的一個“虛擬副本”。

然後這個數字孿生就可以預測患者未來可能得的疾病,以及需要用什麼藥。

使用美國的數據時,數據孿生預測的準確率達到88%!

而使用英國國民醫療服務體系(NHS)的信息時,它的準確率稍差,隻有68%和76%。

而且,現在他們還開發一個更準確的工具——Foresight 2,研究結果已經在《柳葉刀數字健康》上發表。

論文地址:https://www.thelancet.com/journals/landig/article/PIIS2589-7500(24)00025-6/fulltext

數字孿生去看醫生

這項研究的合著者、國王學院醫院數據科學和人工智能主任James Teo認為,這些數字孿生的預測,代表理解疾病的“可能的多元宇宙”。

“我們的生成式AI可以從健康記錄中的文本中生成預測,涵蓋所有疾病組的任何疾病、測試、藥物、治療或並發癥。”

而通過患者的數字孿生,就可以提供各種見解和假設的場景。

其實,這種活細胞和整個器官的虛擬模型概念,早就對我們不陌生。

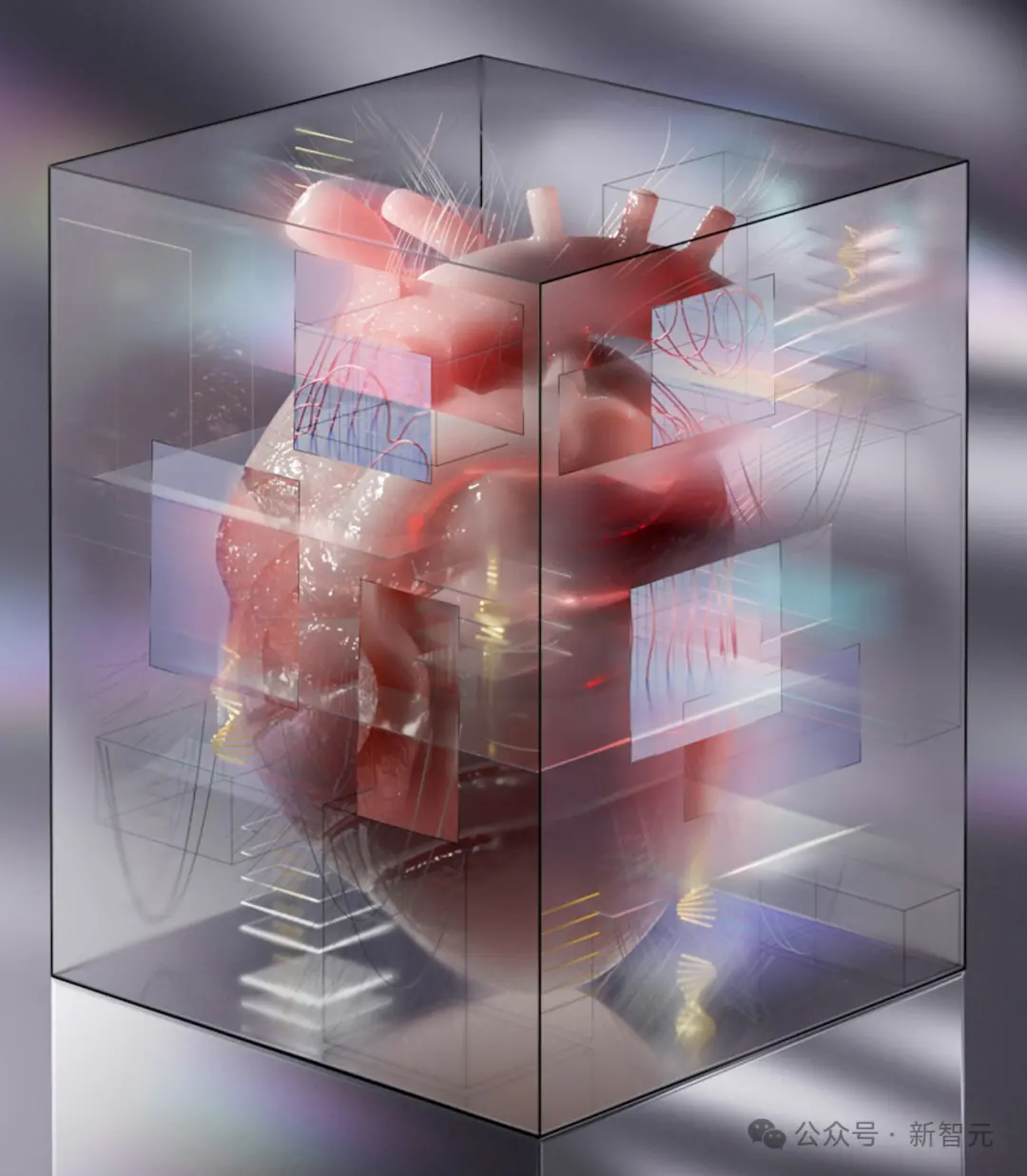

比如Alya Red,就是一個由約1億個虛擬細胞組成的心臟數字孿生。

在巴塞羅那郊區一座19世紀小教堂的墻壁內,一顆心臟開始慢慢收縮,它在測試從藥物到植入物的治療方法

通過與醫療技術公司Medtronic合作,Alya Red模擬可以幫助定位起搏器,微調電刺激,並對效果進行建模。

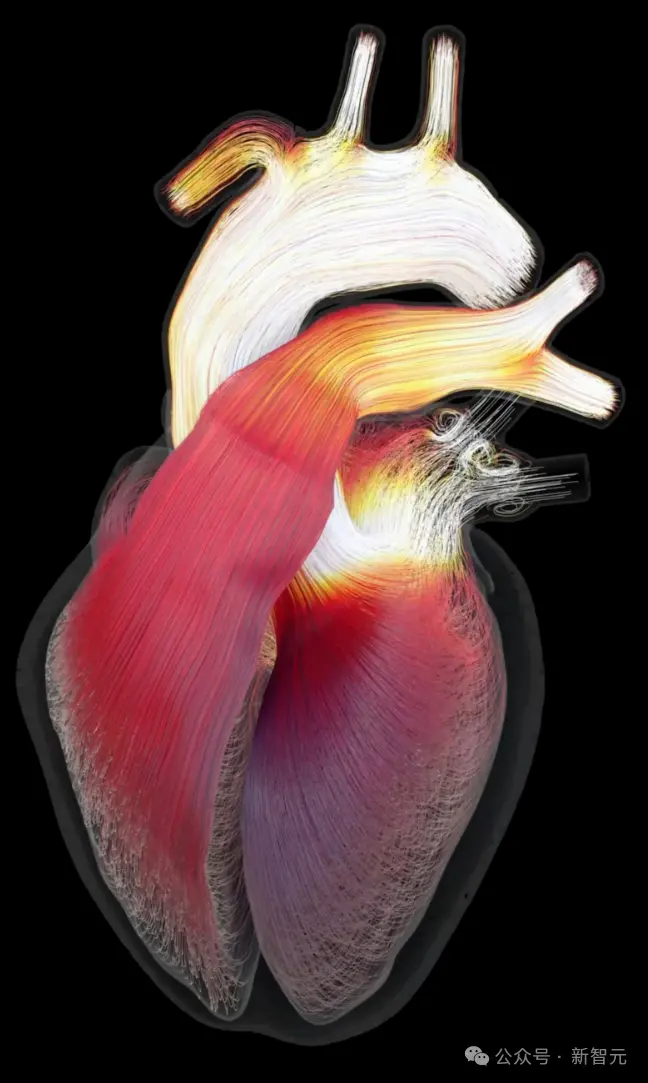

Alya Red數字孿生心臟模型由大約1億個虛擬心臟細胞組成,每個細胞由大約50個方程描述。流經其中的“血液”可以栩栩如生地呈現出一束束鮮艷的色彩,紅色、橙色和黃色透露出旺盛的流動,病變心室內的血流表現為緩慢的藍色和綠色。因此,數字孿生可以揭示衰竭的心臟如何失去泵血能力,或者由心臟藥物引起的危險心律失常

不過,怎樣將虛擬心臟連接到虛擬身體呢?

為此,CompBioMed聯盟創建一個長達60,000英裡的血管、動脈、靜脈和毛細血管網絡的數字孿生。

這些網絡使用數十億個數據點,是從一名26歲的韓國女性Yoon-sun的冷凍屍體的數字化、高分辨率橫截面中收集而來的。

而德國超算SuperMUC-NG,使可專傢們可以模擬出虛擬血液是如何通過Yoon-sun血管的虛擬副本流動的,它的直徑隻有幾分之一毫米。

之後,團隊還會模擬Yoon-sun循環數字孿生過程中的血壓變化,並模擬血栓的運動。

來自倫敦科學博物館工程師畫廊的“虛擬心臟”展覽的Jazmín Aguado-Sierra心臟的數字孿生圖像

不過,迄今為止,我們從未創建過整個人體的數字孿生。

首先,這種復雜的模擬需要訪問強大的計算機,比如世界上第一臺也是最快的百萬兆次級超級計算機Frontier。即便如此仍然相距甚遠,並且需要大量的能量。

還有一個巨大的挑戰,是將虛擬身體每個部分的所有代碼拼接在一起。

數字人的每個部分,如細胞或心臟,在技術上都是一個單獨的模擬。模擬也有多種尺度:一個細胞模型和另一個器官模型需要不同的代碼並以不同的速度運行。讓所有這些代碼以相同的速度同時加載並非易事

另外,還有道德方面的考慮,預測健康的工具如果落入壞人手裡,會有潛在的風險。

不過,在當前技術下,想創建自己的數字孿生,隻有億萬富翁才能做到。