誒?這是《老友記》流出未公開鏡頭?還是“子彈時間”特效那種?隻見人物定格的一瞬,機位絲滑運動,一個多角度全方位的廚房出現在眼前,仿佛我人就站在現場啊。

要知道,在正片裡其實隻有這兩幅畫面:

沒錯,又是AI在搞“魔法”。

在看《老友記》之後,AI能直接還原出宛如真實現場的3D場景,補足兩個切換畫面之間人物在不同角度時的姿態。

沒拍過的角度畫面,它都能重建出來。

還能把一個近景鏡頭,變成大遠景。

乍一眼看去,真的很難分辨出生成效果其實是完全捏造的。

“以後電視劇補拍鏡頭都省?”

這就是由UC伯克利大學研究人員提出的重建3D人物和環境的新方法。

網友看後腦洞大開:

可能不出10年,你就能把自己的VR形象放到自己喜歡的節目裡。

目前,該方法已被ECCV 2022接收。

專門針對電視劇場景重建

研究人員表示,這次提出的新方法就是專門針對電視劇場景的。

除《老友記》外,他們還3D重建《生活大爆炸》等7個電視劇的場景。

要知道,使用單個視頻來重建3D場景的難度其實還很高,但是電視劇中往往是同一場景拍下多個畫面,這為AI學習提供非常豐富的圖像資料。

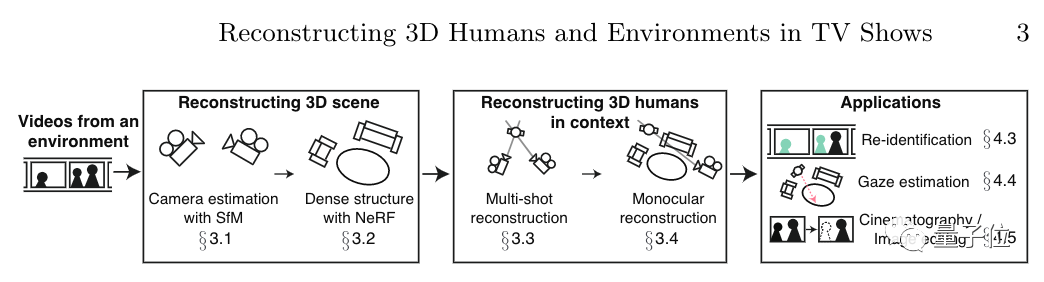

本文方法能夠在整季劇集中自動運行,計算出各個鏡頭的攝像機位置信息、靜態三維場景結構和人物身體信息,然後將他們整合計算成一個3D場景來。

具體來看,該方法主要分為處理場景信息人物信息兩方面。

場景上,基於不同畫面,該方法通過SfM(Structure-from-Motion)來估計出拍攝時攝像機的位置。

這種方法是指在隻有單個攝像機的情況下,通過分析攝像機移動時拍到的場景來確定3D場景信息。

然後通過分析攝像機與人物之間的位置關系,以此確定出人物所在的區域,然後將兩個不同角度的畫面整合分析,進行三角定位,以此確定人物的真正位置。

之後,利用NeRF來重建出細致的3D場景信息。

神經渲染輻射場可以將場景的體積表示優化為向量函數,該函數由位置和視圖方向組成的連續5D坐標定義。

也就是沿著相機射線采樣5D坐標,以此合成圖像。

接下來,就是處理場景中人物信息方面。

針對多鏡頭情況下,在確定好人物所在位置後,使用NeRF就能直接重建出人體3D信息。

而如果是單鏡頭情況,就需要利用上下幀畫面中人體姿勢的變化、攝像機位置和環境結構信息來進行重建。

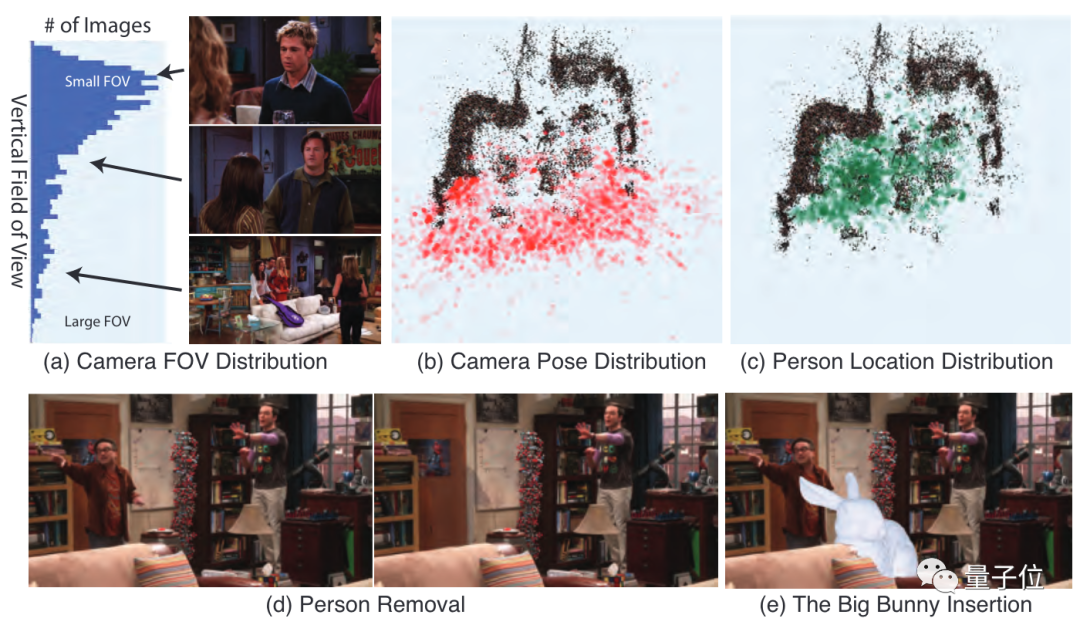

從實驗結果中可以看到,該方法最終可以綜合得到的3D信息,重新渲染出一個新的畫面。

在消融實驗中,如果沒有確定攝像機、人物的特征信息,最終得到的結果也都不盡如人意。

並且,研究人員還對得到的場景進行數據分析,包括相機距離、人物位置分佈。

還提供編輯選項,可以刪除或插入選定對象。

目前,該團隊已將代碼和論文數據開源。

研究團隊來自UC伯克利大學人工智能研究實驗室。

作者表示,本文方法在電影、體育節目等領域同樣適用。